論文翻訳: Consensus: Bridging Theory and Practice

哲学博士の学位取得に必要な条件の一部を満たすためにスタンフォード大学計算機科学科および卒業研究委員会に提出した学位論文

Diego Ongaro

August 2014

This work is licensed under the Creative Commons Attribution 4.0 International License. http://creativecommons.org/licenses/by/4.0/

This work is licensed under the Creative Commons Attribution 4.0 International License. http://creativecommons.org/licenses/by/4.0/

この論文は Diego Ongaro と John Ousterhout によって書かれた論文 "In Search of an Understandable Consensus Algorithm" [89] を発展させたものである。元の論文の内容のほとんどは何らかの形でこの論文に含まれている。本論文では John Ousterhout の許可を得て Creative Commons Attribution license の下で複製・ライセンスされている。

Abstract

Abstract

分散コンセンサスはフォールトトレラントなシステムを構築するために不可欠である。これにより、一部のメンバーに障害が発生しても複数のマシンが動作を継続できる、一貫性のあるグループとして動作することが可能となる。しかし残念ながら最も一般的なコンセンサスアルゴリズムである Paxos は正しく理解し実装することが難しいと広く認識されている。

この論文では、理解しやすさを重視して設計された Raft と呼ばれる新しいコンセンサスアルゴリズムを紹介する。Raft はまずサーバをリーダーとして選出し、次にすべての意思決定をリーダーに集中させる。この 2 つの基本ステップは比較的独立しており、コンポーネントの分離が難しい Paxos よりも優れた構造を形成している。Raft は投票とランダムなタイムアウトを用いてリーダーを選出する。この選挙により、リーダーが必要なすべての情報を既に保存していることが保証されるため、データはリーダーから他のサーバへのみ流れる。他のリーダーベースのアルゴリズムと比較して、これによりメカニズムを減らし動作を簡素化する。選出されたリーダーは複製されたログを管理する。Raft は、ログの成長方法に関する単純な不変条件を利用することでアルゴリズムの状態空間を縮小し、最小限のメカニズムでこのタスクを達成する。

Raft は従来のアルゴリズムよりも実環境への実装に適している。また実用的なデプロイメントに十分なパフォーマンスを発揮し、クライアントとのやりとりを管理する方法、クラスタメンバーシップを変更する方法、ログが大きくなりすぎた場合にコンパクトにする方法など、完全なシステムを構築するためあらゆる側面に対応している。クラスタメンバーシップの変更において、Raft では一度に 1 つのサーバを追加または削除することができ (これらの基本的な手順から複雑な変更を構成できる)、クラスタは変更中もリクエストへの応答を継続する。

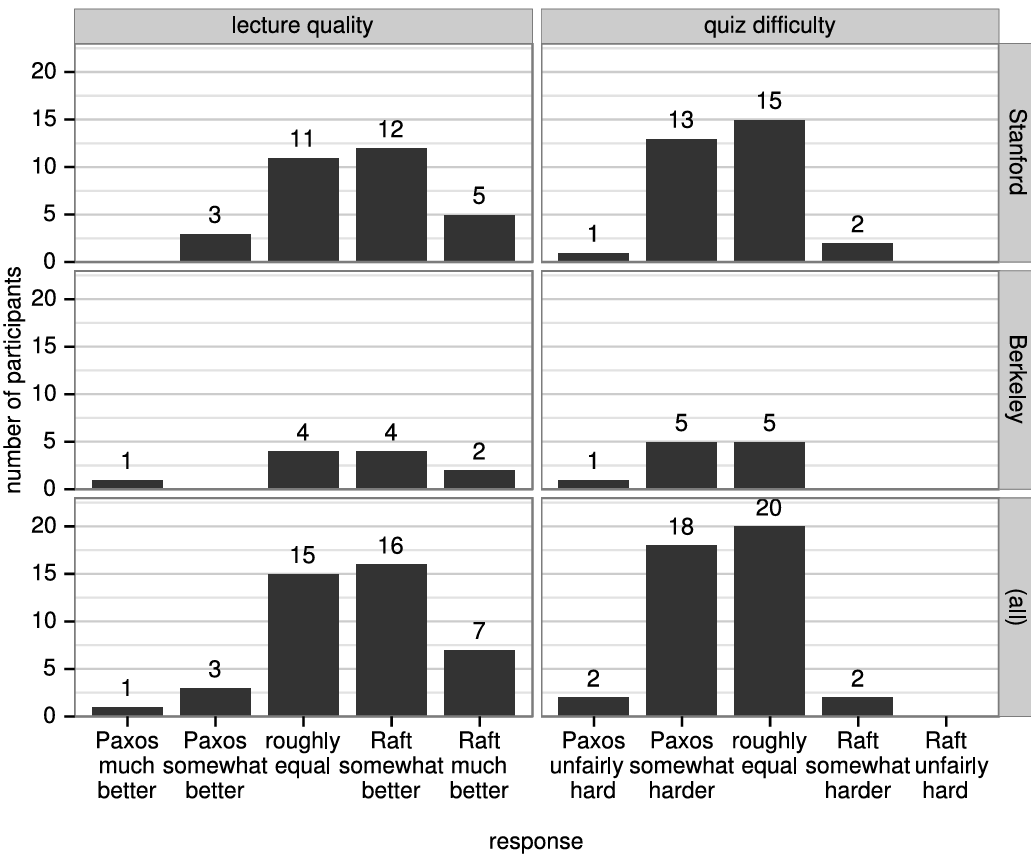

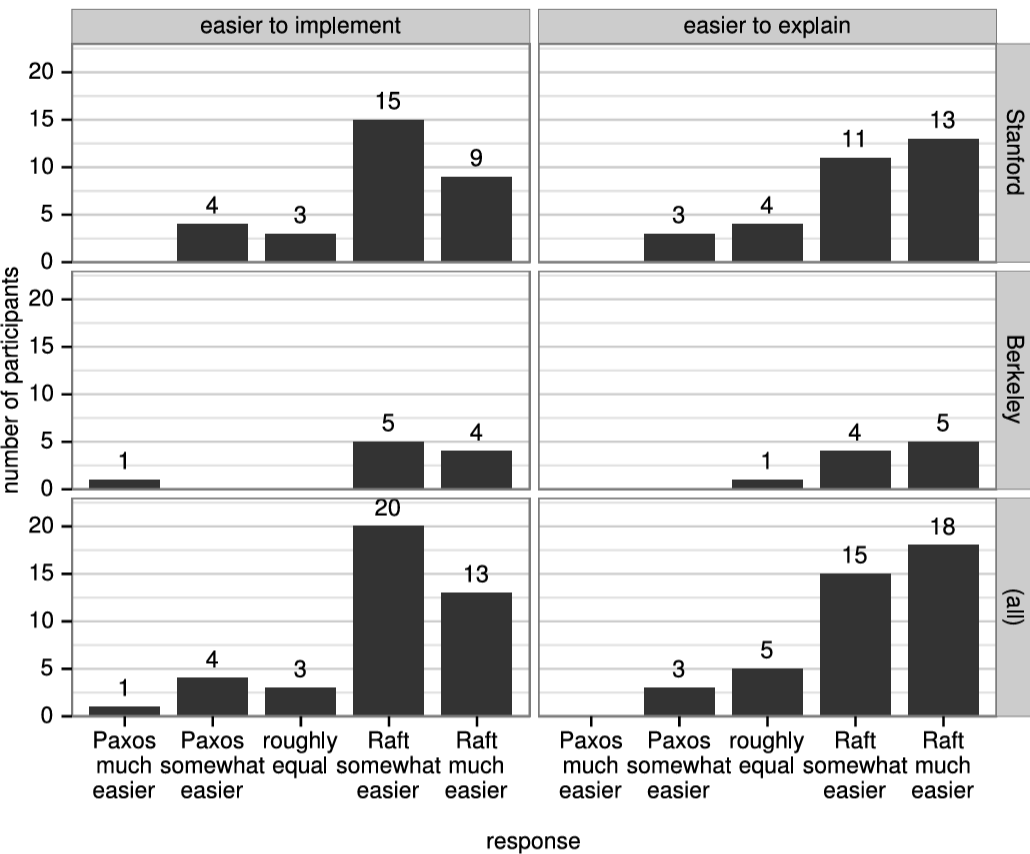

我々は、教育目的と実装の基礎の両面において Raft は Paxos やその他のコンセンサスアルゴリズムよりも優れていると考えている。ユーザ調査の結果、Raft は Paxos よりも学生にとって学習しやすいことを示している。このアルゴリズムは正式に仕様化され証明されており、そのリーダー選出アルゴリズムは様々な環境で適切に動作し、その性能は Multi-Paxos と同等である。現在、Raft の多くの実装が提供されており、いくつかの企業が Raft を導入している。

Table of Contents

- Abstract

- 序文

- Acknowledgements

- Chapter 1 - はじめに

- Chapter 2 - 動機

- Chapter 3 - 基本 Raft アルゴリズム

- Chapter 4 - クラスタメンバーシップ変更

- Chapter 5 - ログ圧縮

- Chapter 6 - クライアントとの相互作用

- Chapter 7 - Raft ユーザ調査

- Chapter 8 - 正しさ

- Chapter 9 - リーダー選出評価

- Chapter 10 - 実装と性能

- Chapter 11 - 関連研究

- Chapter 12 - 結論

- Appendix A - ユーザ調査資料

- Appendix B - Safety の証明と形式仕様

- Bibliography

- 翻訳抄

序文

序文

読者は Raft に関するビデオや Raft のインタラクティブな可視化について Raft のウェブサイト [92] を参照することをおすすめする。

Acknowledgements

Acknowledgements

Acknowledgements

Thanks to my family and friends for supporting me throughout the ups and downs of grad school. Mom,thanks for continuously pushing me to do well academically, even when I didn’t see the point. I still don’t know how you got me out of bed at 6 a.m. all those mornings. Dad, thanks for helping us earn these six (seven?) degrees, and I hope we’ve made you proud. Zeide, I wish I could give you a copy of this small book for your collection. Ernesto, thanks for sparking my interest in computers; I still think they’re pretty cool. Laura, I’ll let you know if and when I discover a RAMCloud. Thanks for listening to hours of my drama, even when you didn’t understand the nouns. Jenny, thanks for helping me get through the drudgery of writing this dissertation and for making me smile the whole way through. You’re crazy for having wanted to read this, and you’re weird for having enjoyed it.

I learned a ton from my many labmates, both in RAMCloud and in SCS. Deian, I don’t know why you always cared about my work; I never understood your passion for that IFC nonsense, but keep simplifying it until us mortals can use it. Ankita, you’ve single-handedly increased the lab’s average self-esteem and optimism by at least 20%. I’ve watched you learn so much already; keep absorbing it all, and I hope you’re able to see how far you’ve come. Good luck with your role as the new Senior Student. Thanks especially to Ryan and Steve, with whom I formed the first generation of RAMCloud students. Ryan, believe it or not, your optimism helped. You were always excited about wacky ideas, and I always looked forward to swapping CSBs (“cool story, bro”) with you. You’ll make a great advisor. Steve, I miss your intolerance for bullshit, and I strive to match your standards for your own engineering work. You continuously shocked the rest of us with those silent bursts of productivity, where you’d get quarter-long projects done over a single weekend. You guys also figured out all the program requirements before I did and told me all the tricks. I continue to follow your lead even after you’ve moved on. (Ryan, you incorrectly used the British spelling “acknowledgements” rather than the American “acknowledgments”. Steve, you did too, but you’re just Canadian, not wrong.)

Thanks to the many professors who have advised me along the way. John Ousterhout, my Ph.D. advisor, should be a coauthor on this dissertation (but I don’t think they would give me a degree that way). I have never learned as much professionally from any other person. John teaches by setting a great example of how to code, to evaluate, to design, to think, and to write well. I have never quite been on David Mazières’s same wavelength; he’s usually 10–30 minutes ahead in conversation. As soon as I could almost keep up with him regarding consensus, he moved on to harder Byzantine consensus problems. Nevertheless, David has looked out for me throughout my years in grad school, and I’ve picked up some of his passion for building useful systems and, more importantly, having fun doing so. Mendel Rosenblum carries intimate knowledge of low level details like x86 instruction set, yet also manages to keep track of the big picture. He’s helped me with both over the years, surprising mewith how quickly he can solve my technical problems and how clear my predicaments are when put into his own words. Thanks to Christos Kozyrakis and Stephen Weitzman for serving on my defense committee, and thanks to Alan Cox and Scott Rixner for introducing me to research during my undergraduate studies at Rice.

Many people contributed directly to this dissertation work. A special thanks goes to David Mazières and Ezra Hoch for each finding a bug in earlier versions of Raft. David emailed us one night at 2:45 a.m. as he was reading through the Raft lecture slides for the user study. He wrote that he found “one thing quite hard to follow in the slides,” which turned out to be a major issue in Raft’s safety. Ezra found a liveness bug in membership changes. He posted to the Raft mailing list, “What if the following happens?” [35], and described an unfortunate series of events that could leave a cluster unable to elect a leader. Thanks also to Hugues Evrard for finding a small omission in the formal specification.

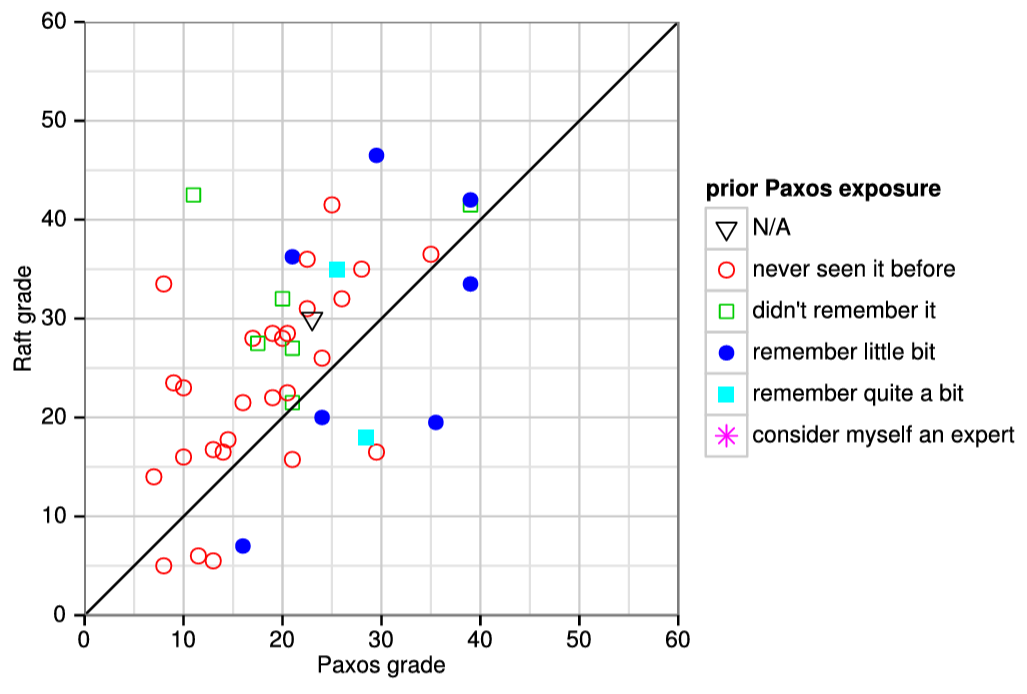

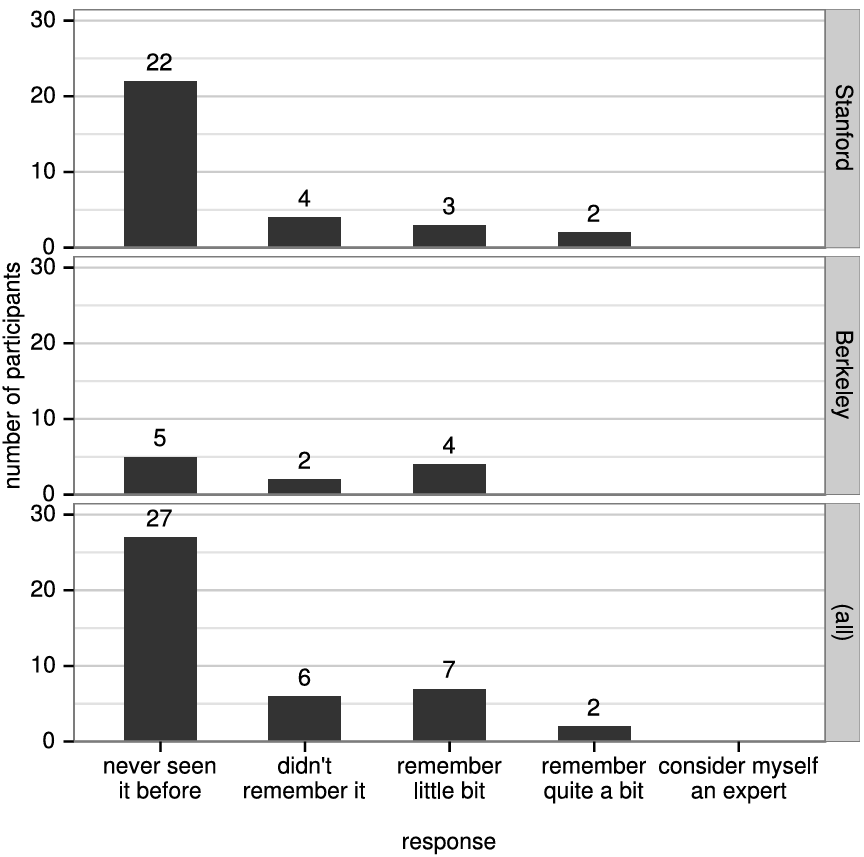

The user study would not have been possible without the support of Ali Ghodsi, David Mazières, and the students of CS 294-91 at Berkeley and CS 240 at Stanford. Scott Klemmer helped us design the user study, and Nelson Ray advised us on statistical analysis. The Paxos slides for the user study borrowed heavily from a slide deck originally created by Lorenzo Alvisi.

Many people provided feedback on other content in this dissertation. In addition to my reading committee, Jennifer Wolochow provided helpful comments on the entire dissertation. Blake Mizerany, Xiang Li, and Yicheng Qin at CoreOS pushed me to simplify the membership change algorithm towards single-server changes. Anirban Rahut from Splunk pointed out that membership changes may be needlessly slow when a server joins with an empty log. Laura Ongaro offered helpful feedback on the user study chapter. Asaf Cidon helped direct me in finding the probability of split votes during elections. Eddie Kohler helped clarify the trade-offs in Raft’s commitment rule, and Maciej Smoleński pointed out that because of it, if a leader were to restart an unbounded number of times before it could mark entries committed, its log could grow without bound (see Chapter 11). Alexander Shraer helped clarify how membership changes work in Zab.

Many people provided helpful feedback on the Raft paper and user study materials, including Ed Bugnion, Michael Chan, Hugues Evrard, Daniel Giffin, Arjun Gopalan, Jon Howell, Vimalkumar Jeyakumar, Ankita Kejriwal, Aleksandar Kracun, Amit Levy, Joel Martin, Satoshi Matsushita, Oleg Pesok, David Ramos, Robbert van Renesse, Mendel Rosenblum, Nicolas Schiper, Deian Stefan, Andrew Stone, Ryan Stutsman, David Terei, Stephen Yang, Matei Zaharia, 24 anonymous conference reviewers (with duplicates), and especially Eddie Kohler for shepherding the Raft paper.

Werner Vogels tweeted a link to an early draft of the Raft paper, which gave Raft significant exposure. Ben Johnson and Patrick Van Stee both gave early talks on Raft at major industry conferences.

This work was supported by the Gigascale Systems Research Center and the Multiscale Systems Center, two of six research centers funded under the Focus Center Research Program, a Semiconductor Research Corporation program, by STARnet, a Semiconductor Research Corporation program sponsored by MARCO and DARPA, by the National Science Foundation under Grant No. 0963859, and by grants from Facebook, Google, Mellanox, NEC, NetApp, SAP, and Samsung. Diego Ongaro was supported by The Junglee Corporation Stanford Graduate Fellowship. James Myers at Intel donated several SSDs used in benchmarking.

Chapter 1 - はじめに

Chapter 1 - はじめに

今日のデータセンターシステムとアプリケーションは非常に動的な環境で稼働している。これらは追加サーバのリソースを活用してスケールアウトし、需要に応じて拡大・縮小する。サーバやネットワーク障害も日常的である。例えば毎年ディスクドライブの約 2-4% が故障し [103]、サーバもほぼ同じ頻度でクラッシュし [22]、現在のデータセンターでは毎日数十のネットワークリンクが故障している [31]。

その結果、システムは通常運用中にサーバの増減に対応しなければならない。システムは変化に反応し、数秒以内に自動的に適応する必要があり、人間が気づくような停止は通常許容されない。これは今日のシステムにとって大きな課題である。このような動的な環境では、障害処理、協調、サービスディスカバリー、構成管理のすべてが困難である。

幸いなことに、分散コンセンサスはこれらの課題を解決するのに役立つ。コンセンサスにより、機械の集合は、一部のメンバーの故障に耐えることができる一貫したグループとして機能することができる。コンセンサスグループ内では、障害は原則に基づいて実証済みの方法で処理される。コンセンサスグループは高い可用性と信頼性を持つため、他のシステムコンポーネントはコンセンサスグループを自身の耐障害性の基盤として使用することができる。したがって、コンセンサスは信頼性の高い大規模ソフトウェアシステムを構築する上で重要な役割を果たす。

我々がこの研究を始めたとき、コンセンサスの必要性は明らかになりつつあったが、多くのシステムは依然としてコンセンサスが解決できる問題に苦しんでいた。一部の大規模システムは単一障害点となる単一の協調サーバによって依然として制約を受けていた (例: HDFS [81, 2])。その他多くのシステムには安全でない方法で障害を処理するアドホックなレプリケーションアルゴリズムを採用していた (例: MongoDB および Redis [44])。新しいシステムはすぐに利用できるコンセンサス実装の選択肢がほとんどなく (ZooKeeper [38] が最も人気であった)、システム構築者は特定のコンセンサス実装に従うか、独自の実装を構築せざるを得なかった。

コンセンサスを独自に実装することを選択した人々は、通常、Paxos [48, 49] に目を向けた。Paxos は過去 20 年間にわたりコンセンサスアルゴリズムの議論を支配してきた。ほとんどのコンセンサス実装は Paxos に基づいて構築されているか、それから影響を受けており、Paxos は学生にコンセンサスを教えるための主要な手段となっていた。

残念ながら、より理解しようとするための数多くの試みにもかかわらず、Paxos は非常に難解である。さらに、そのアーキテクチャは実用的なシステムをサポートするために複雑な変更を必要とし、Paxos に基づいた完全なシステムを構築するには、詳細が公開されていない、あるいは合意されていない複数の拡張機能を開発する必要がある。結果として、システム開発者と学生の両方が Paxos に苦戦する。

他の 2 つのよく知られたコンセンサスアルゴリズムは Viewstamped Replication [83, 82, 66] と ZooKeeper で使用されている Zab [42] である。これらのアルゴリズムはどちらも、偶然にもシステム構築において Paxos よりも構造的に優れていると我々は考えているが、どちらもこの主張を明示的に行っていない。それらはシンプルさや理解しやすさを主要な目的として設計されたものではなかった。これらのアルゴリズムを理解し、実装する負担は依然として高すぎる。

これらのコンセンサスの選択肢はそれぞれ理解が難しく実装するのも難しかった。残念ながら、実証済みのアルゴリズムでコンセンサスを実装するコストが高すぎると、システム構築者は厳しい決断を迫られた。彼らはコンセンサスを完全に避けてシステムの障害耐性や一貫性を犠牲にするか、独自のアドホックなアルゴリズムを開発し、しばしば安全でない挙動につながるかのどちらかであった。さらに、コンセンサスを説明するコストが高すぎると、すべての講師がそれを教えようとせず、すべての学生がそれを習得できるわけではなかった。コンセンサスは 2-フェーズコミットと同じくらい基本的であり、(コンセンサスは根本的により難しいとはいえ) 理想的にはより多くの学生が習得すべきである。

我々自身が Paxos に苦戦した後、システム構築と教育のためによりよい基盤を提供できる新しいコンセンサスアルゴリズムを見つけることを目指した。我々のアプローチは、その主要な目標が理解しやすさ (understandability) であるという点で異例であった。すなわち、実用的なシステムのためのコンセンサスアルゴリズムを定義し、Paxos よりも著しく学習しやすい方法でそれを記述できるか、と言うことであった。さらに、アルゴリズムがシステム構築者にとって不可欠な直感を促進することを望んだ。アルゴリズムが機能するだけではなく、なぜ機能するのかが明白であることが重要であった。

このアルゴリズムは、実用的なシステムを構築するすべての側面に対処するのに十分完全である必要があり、また、実用的な展開のために十分な機能を発揮する必要があった。コアアルゴリズムは、メッセージの受信による効果を指定するだけでなく、何がいつ起こるべきかを記述すべきであり、これらはシステム構築者にとって同様に重要である。同様に、一貫性を保証する必要があり、また、可能な限り可用性も提供する必要があった。さらに、コンセンサスの達成を超えたシステムにおける多くの側面、例えばコンセンサスグループのメンバー変更にも対処する必要があった。これらは実際には不可欠であり、この負担をシステム構築者に任せることはアドホックで最適とは言えず、あるいは誤った解決策を招く危険性があった。

この研究の成果が Raft と呼ばれるコンセンサスアルゴリズムである。Raft の設計において我々は理解しやすさを向上させるための特定の手法を適用した。これには分解 (Raft はリーダー選出、ログレプリケーション、Safety を分離する) と状態空間の削減 (Raft は非決定論の度合いとサーバが互いに不整合になる方法を減らす) が含まれる。我々はまた、完全なコンセンサスベースのシステムを構築するために必要なすべての問題に対処した。各設計の選択は、我々の実装のためだけでなく、我々が実現を望む多くの他の実装のためにも慎重に検討された。

我々は Raft が教育目的および実装の基盤として Paxos や他のコンセンサスアルゴリズムより優れていると信じている。これは他のアルゴリズムよりもシンプルで理解しやすく、実用的なシステムのニーズを満たすのに十分完全に記述されている。いくつかのオープンソース実装があり、いくつかの企業で使用されている。Safety 特性は正式に仕様化され証明されており、効率性は他のアルゴリズムに匹敵する。

この論文の主な貢献は以下の通りである:

Raft コンセンサスアルゴリズムの設計、実装、評価。Raft は既存のコンセンサスアルゴリズム (特に Oki と Liskov の Viewstamped Replication [83, 66]) と多くの点で類似しているが、理解しやすさを目指して設計されている。これがいくつかの斬新な特徴につながった。例えば、Raft は他のコンセンサスアルゴリズムよりも強力な形式のリーダーシップを使用する。これにより、レプリケーションされたログの管理が簡素化され、Raft の理解が容易になる。

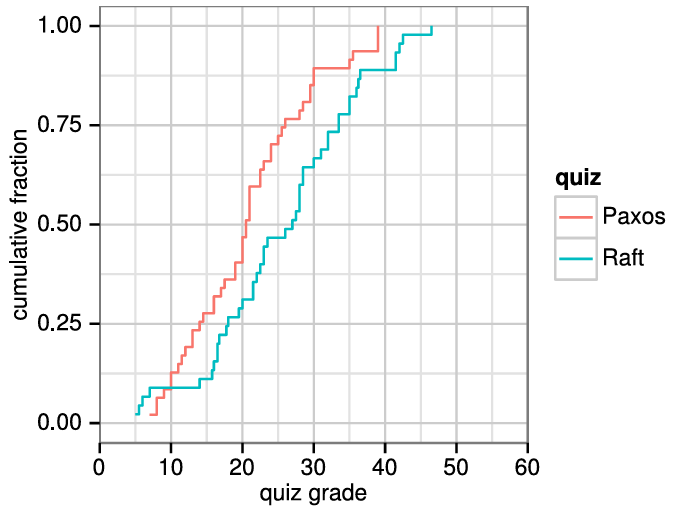

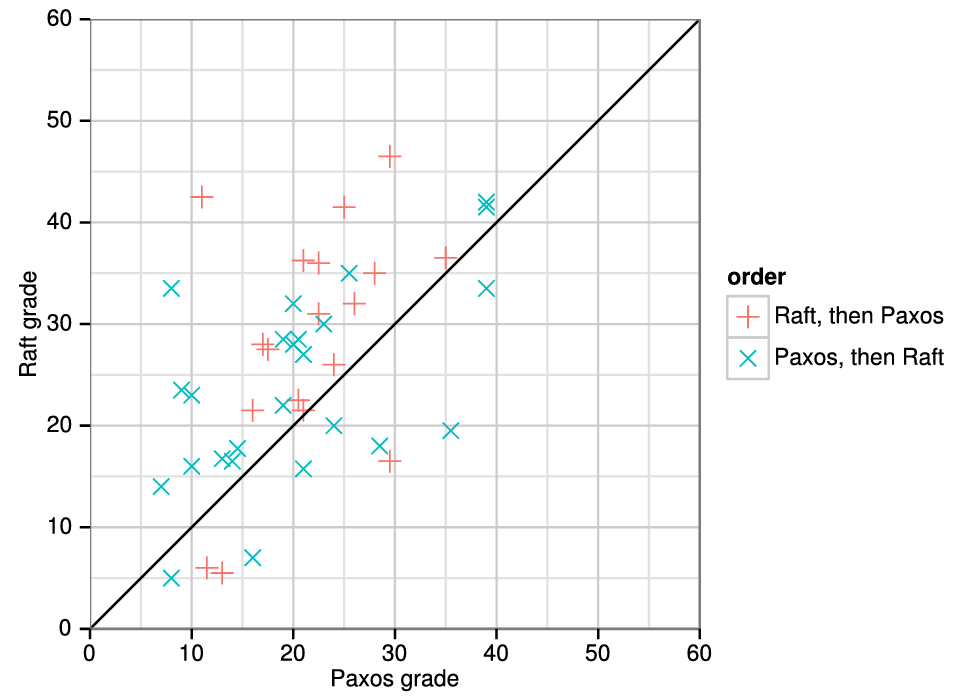

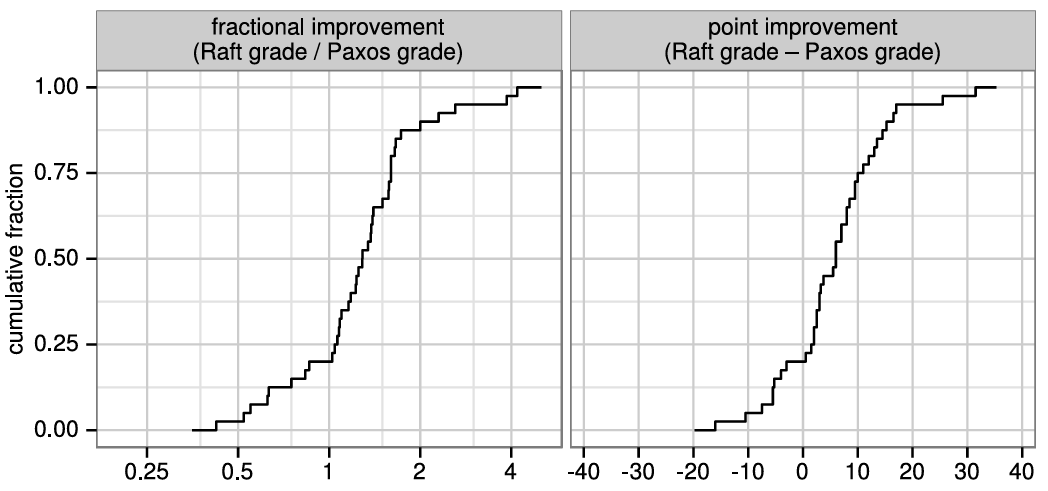

Raft の理解しやすさの評価。2 つの大学の 43 人の学生を対象としたユーザ調査は、Raft が Paxos よりも著しく理解しやすいことを示している。両方のアルゴリズムを学んだ後、これらの学生のうち 33 人は Paxos に関する質問よりも Raft に関する質問により正確に回答することができた。これは、教育と学習に基づいてコンセンサスアルゴリズムを評価する最初の科学的研究であると我々は考えている。

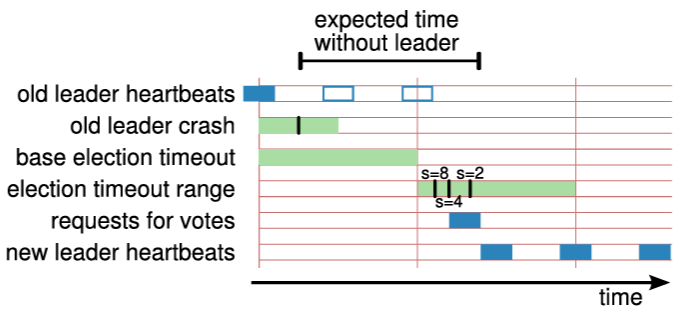

Raft のリーダー選出メカニズムの設計、実装、評価。多くのコンセンサスアルゴリズムは特定のリーダー選出アルゴリズムを規定しないが、Raft はランダム化されたタイマーを含む独自のアルゴリズムを採用している。これは、既存のコンセンサスアルゴリズムで既に必要なハートビートにわずかなメカニズムを追加するだけであり、同時に競合をシンプルかつ迅速に解決する。リーダー選出の評価はその挙動と性能を調査し、このシンプルなアプローチが多種多様な実用的な環境で十分であることを結論づけている。通常、Raft はクラスタの片方向ネットワーク遅延 (one-way network latency) の 20 倍未満でリーダーを選出する。

Raft のクラスタメンバーシップ変更メカニズムの設計と実装。Raft は一度に 1 台のサーバを追加または削除できる。これらの操作は、変更中に少なくとも 1 つのサーバが任意の過半数と重複するため Safety をシンプルに確保する。より複雑なメンバーシップ変更は単一サーバの変更を繰り返すことで実装される。Raft は変更中でもクラスタが正常に動作し続けることを可能にし、メンバーシップ変更は基本的なコンセンサスアルゴリズムへのいくつかの拡張だけで実現できる。

クライアントとの相互作用やログ圧縮など、完全なコンセンサスベースのシステムに不可欠な他のコンポーネントについて、徹底的な議論と実装。これらの Raft の側面が特に斬新であるとは考えていないが、完全な記述は理解しやすさ、そして他の人々が実際のシステムを構築できるようにするために重要である。我々は、関連するすべての設計上の決定を探求し対処するために完全なコンセンサスベースのサービスを実装した。

Raft アルゴリズムの Safety の証明と形式仕様。形式仕様の精度レベルは、アルゴリズムについて慎重に推論し、アルゴリズムの非形式的な説明の詳細を明確にするのに役立つ。Safety の証明は Raft の正しさへの信頼を構築するのに役立つ。また、Raft を拡張しようとする他の人々に対しても、拡張の Safety への影響を明確にすることで役立つ。

我々はこの論文の多くの設計を Raft のオープンソース実装である LogCabin [86] で実装した。LogCabin は Raft における新しいアイディアのテストプラットフォームとして、また、完全で実用的なシステムを構築する際の問題を理解していることを検証する手段として機能した。実装についてはセクション 10 でさらに詳しく説明する。

この論文の残りの部分では、複製ステートマシンの問題を紹介し Paxos の長所と短所を議論し (セクション 2)、Raft コンセンサスアルゴリズム、クラスタメンバーシップ変更とログ圧縮のための拡張、およびクライアントが Raft とどのように相互作用するかを提示し (セクション 3 ~セクション 6)、理解しやすさ、Safety、Liveness、リーダー選出、およびログ複製の性能に関して Raft を評価し (セクション 7 ~セクション 10)、関連する研究を議論する (セクション 11)。

Chapter 2 - 動機

Chapter 2 - 動機

コンセンサスは障害耐性システムにおける根本的な問題である。すなわち、サーバが故障に直面してもいかにして共有された状態について合意に達することができるのか。この問題は高レベルの可用性を提供する必要があり、一貫性を損なうことができない多種多様なシステムで発生する。そのため、コンセンサスは実質的に一貫性のあるすべての大規模ストレージシステムで利用されている。セクション 2.1 ではコンセンサスが障害耐性システムの汎用的な構成要素である複製ステートマシンを作成するために一般にどのように使われるかを説明する。セクション 2.2 では大規模システムにおける複製ステートマシンの様々な使用方法について議論する。セクション 2.3 では Raft が解決を目指す Paxos コンセンサスプロトコルの問題点について議論する。

2.1 複製ステートマシンによる障害耐性の達成

2.1 複製ステートマシンによる障害耐性の達成

コンセンサスアルゴリズムは、通常、複製ステートマシン (replicated state machine) [102] の文脈で出現する。このアプローチでは、複数のサーバ上のステートマシンが同一のコピーの同じ状態を計算し、一部のサーバがダウンしても動作し続けることができる。複製ステートマシンは、セクション 2.2 で説明されているように、分散システムにおける様々な障害耐性問題を解決するために使用されている。複製ステートマシンの例には Chubby [11] と ZooKeeper [38] があり、どちらも少量の構成データのために階層的な key-Value ストアを提供している。get や put といった基本的な操作に加えて、それらは compare-and-swap のような同期プリミティブも提供し、並行クライアントが安全に連携することを可能にする。

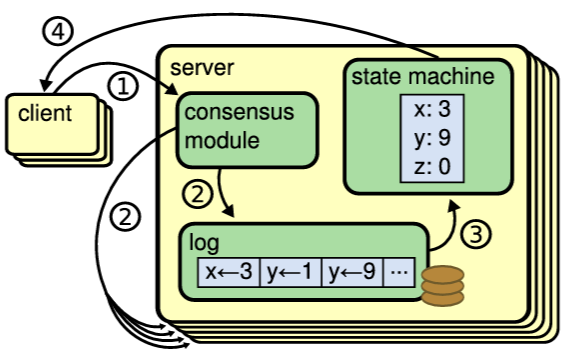

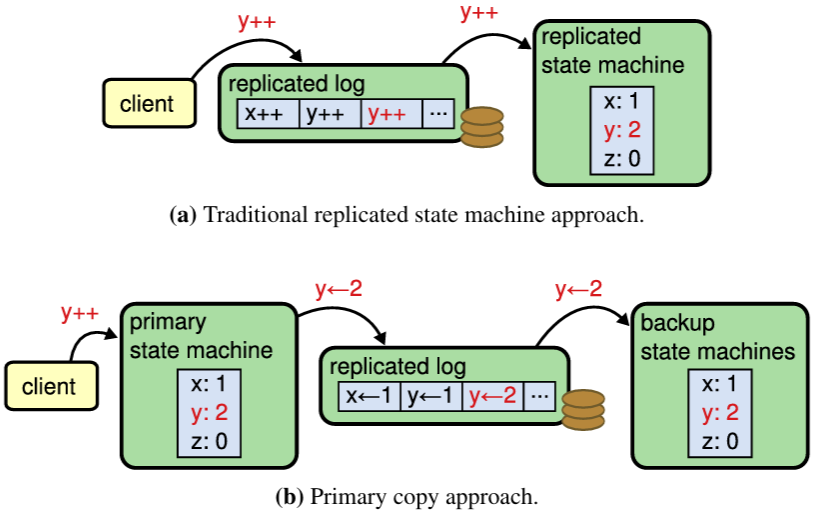

典型的には複製ステートマシンは Figure 2.1 に示すように複製ログを使用して実装される。各サーバは一連のコマンドを含むログを保存し、そのステートマシンはそれらを順番に実行する。各ログは同じコマンドを同じ順序で含んでいるため、各ステートマシンは同じコマンドシーケンスを処理する。ステートマシンは決定論的であるため、各ステートマシンは同じ状態と同じ出力シーケンスを算出する。

複製ログを一貫した状態に保つことがコンセンサスアルゴリズムの役割である。サーバ上のコンセンサスモジュールはクライアントからのコマンドを受信し、それらを自身のログに追加する。他のサーバ上のコンセンサスモジュールと通信することで、一部のサーバが故障してもすべてのログが最終的に同じリクエストを同じ順序で含むことを保証する。コマンドが適切に複製されるとコミットされた (committed) と見なされる。各サーバのステートマシンはログ順でコミットされたコマンドを処理し、その出力をクライアントに返す。結果としてサーバ群は非常に信頼性の高い単一のステートマシンを形成しているように見える。

実用的なシステムのコンセンサスアルゴリズムは、通常、以下の特徴を備えている:

ネットワーク遅延、パーティション、パケット損失、重複、順序逆転など、非ビザンチン条件の下で Safety (誤った結果を決して返さないこと) を保証する。

サーバの任意の過半数が稼働しており、相互に、そしてクライアントと通信できる限り、完全に機能 (Available) する。したがって、典型的な 5 台のサーバからなるクラスタは、任意の 2 台のサーバ故障に耐えることができる。サーバは停止することで故障すると想定され、その後、安定したストレージ上から回復してクラスタに再参加することができる。

ログの一貫性を保証するためにタイミングに依存しない。クロックの故障や極端なメッセージの遅延は、最悪の場合、可用性の問題を引き起こすだけである。つまり、メッセージとプロセッサが任意の速度で進行する非同期モデル [71] の下で Safety を維持する。

一般的なケースでは、コマンドはクラスタの過半数が 1 ラウンドのリモートプロシジャコールに応答するとすぐに完了することができる。少数の遅いサーバがシステム全体の性能に影響を与える必要はない。

2.2 複製ステートマシンの一般的なユースケース

2.2 複製ステートマシンの一般的なユースケース

複製ステートマシンはシステムに障害耐性を与えるための汎用的な構成要素である。それらは様々な用途があり、このセクションではいくつかの典型的な使用パターンについて説明する。

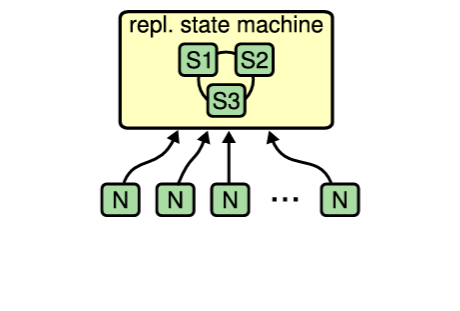

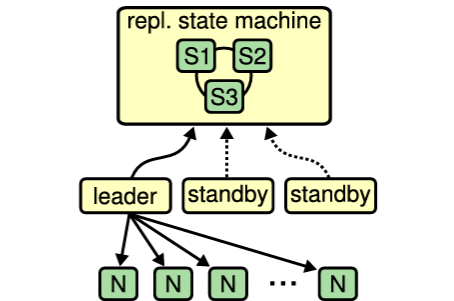

コンセンサスの最も一般的な手に開くでは、3 台または 3 台のサーバが 1 つの複製ステートマシンを形成する。他のサーバは Figure 2.2(a) に示すように、このステートマシンを使用して各自の活動を調整することができる。これらのシステムでは、グループメンバーシップ、構成管理、またはロック [38] を提供するためにしばしば複製ステートマシンを使用する。より具体的な例としては、複製ステートマシンが障害耐性のあるワークキューを提供し、他のサーバが複製ステートマシンを使用して自身に作業を割り当てることで連携する、といったことが挙げられる。

この使用法の一般的な簡略化が Figure 2.2(b) に示されている。このパターンでは 1 台のサーバがリーダーとして機能して他のサーバを管理する。リーダーは自身の重要なデータをコンセンサスシステムに保存する。リーダーが故障した場合、他のスタンバイサーバがリーサーの座を争い、成功すればコンセンサスシステム内のデータを使用して操作を継続する。GFS [30]、HDFS [105]、RAMCloud [90] のような単一のクラスタリーダーを持つ多くの大規模ストレージシステムがこのアプローチを使用している。

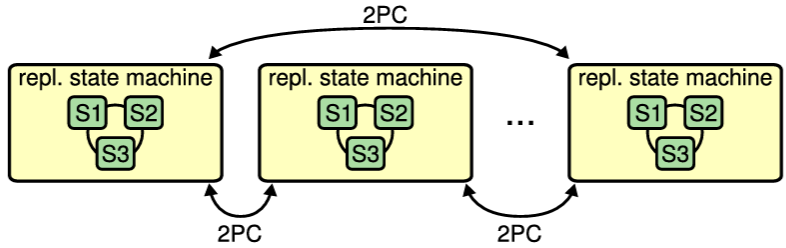

Figure 2.3 に示すように、コンセンサスは非常に大量のデータを複製するためにも使用されることがある。Megastore [5]、Spanner [20]、Scatter [32] のような大規模ストレージシステムは単一のサーバグループに収まらないほど大量のデータを保存する。それらはデータを多くの複製ステートマシンに分割し、複数のパーティションにまたがる操作は一貫性を維持するために 2-フェーズコミットプロトコル (2PC) を使用する。

2.3 Paxos の何が問題なのか?

2.3 Paxos の何が問題なのか?

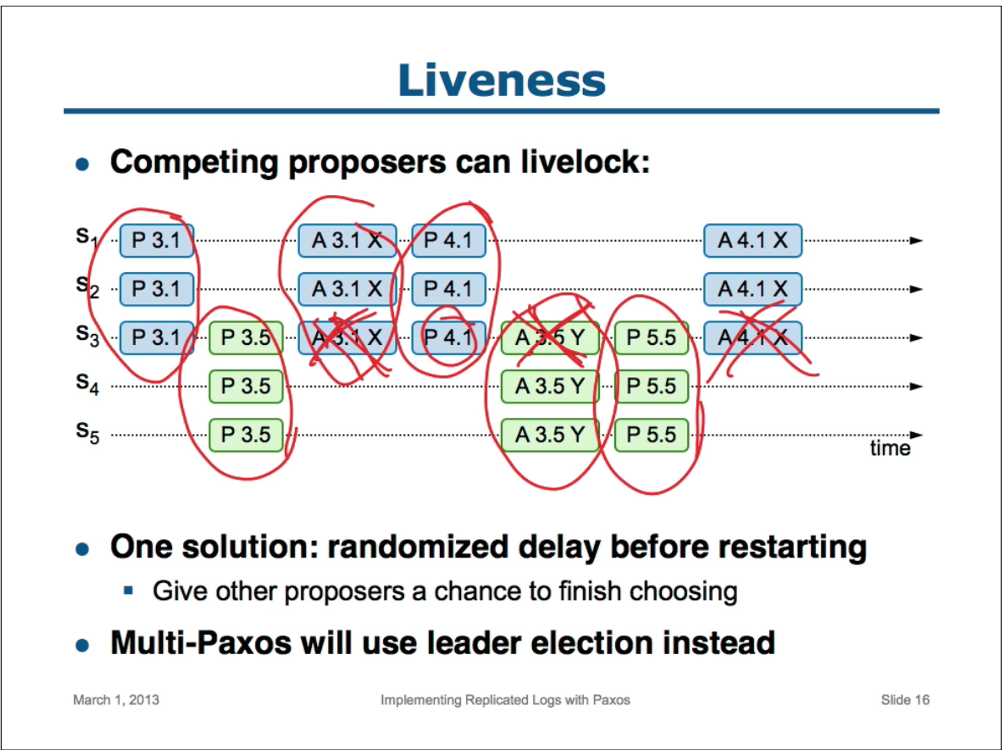

過去 10 年で Leslie Lamport の Paxos プロトコル [48] はコンセンサスとほぼ同義となった。これは授業でも最も一般的に教えられているプロトコルであり、ほとんどのコンセンサス実装がその出発点としている。Paxos はまず、単一複製ログエントリのような単一の決定について合意に達することができるプロトコルを定義する。我々はこのサブセットを単一決定 Paxos (single-decree Paxos) と呼ぶ。次に、Paxos はログなどの一連の決定を促進するためにこのプロトコルの複数のインスタンスを結合する (Multi-Paxos)。単一決定 Paxos は Figure 2.4 に、Multi-Paxos は Figure A.2 にまとめられている。Paxos は Safety と Liveness を保証し (適切な故障検出器がプロポーザーのライブロックを回避するために使用されると仮定すれば、最終的にはコンセンサスに達する)、その正しさは証明されている。Multi-Paxos は通常の場合に効率的であり、Paxos はクラスタメンバーシップの変更をサポートしている [69]。

残念ながら Paxos には 2 つの重大な欠点がある。1 つ目の欠点は Paxos が並外れて理解しにくいことである。完全な説明 [48] は非常に難解で理解できる人はほとんどおらず、それも多大な努力を要する。その結果、Paxos をより簡単な言葉で説明しようとする試みが数多くなされてきた [49, 60, 61]。これらの説明は単一決定サブセットに焦点を当てているが、それでもなお難解である。NSDI 2012 の参加者を対象とした非公式な調査では、ベテランの研究者でさえ、Paxos に慣れている人はほとんどいないことがわかった。我々自身も Paxos の理解に苦戦し、いくつかの説明を読み、独自の代替プロトコルを設計するまで、完全なプロトコルを理解することができなかった。このプロセスにはほぼ 1 年を要した。

我々は、Paxos の不透明さはその基盤に単一決定サブセットを選択したことにある仮説を立てている。単一決定 Paxos は複雑で繊細である。これは 2 つの段階に分かれており、それぞれに直感的な説明を持たず、独立して理解することができない。このため、単一決定プロトコルがなぜ機能するのかについて直感を得ることが難しい。Multi-Paxos の合成ルールはさらに重大な複雑さと繊細さを加えている。複数の決定 (すなわち、単一のエントリではなくログ) についてコンセンサスに達するという全体的な問題は、より直感的で明白な他の方法で分解できると我々は信じている。

Paxos の 2 つ目の問題は、実用的な実装を構築するための良い基盤を提供しないことである。その理由の一つは Multi-Paxos について広く合意されたアルゴリズムが存在しないことである。Lamport の説明はほとんどが単一決定 Paxos に関するものである。彼は Multi-Paxos へのアプローチの可能性を概説しているが、多くの詳細が欠けている。例えば [77]、[108]、[46] など、Paxos を具体化し最適化しようとするいくつもの試みが成されてきたが、これらは互いに異なり、Lamport の概説とも異なる。Chubby [15] のようなシステムは Paxos に似たアルゴリズムを実装しているが、ほとんどの場合、その詳細は公開されていない。

さらに、Paxos のアーキテクチャは実用的なシステムを構築するのには貧弱である。これも単一決定分解のもう一つの結果である。例えば、ログエントリのコレクションを独立して選択し、それから順次ログにマージすることにはほとんど利点がない。これは単に複雑さを増すだけである。新しいエントリが制約された順序で順次追加されるログを中心にシステムを設計する方がよりシンプルで効率的である。もう一つの問題は、Paxos がそのコアで対称的なピアツーピアアプローチを使用していることである (ただし、性能最適化として弱い形式のリーダーシップも示唆している)。これは 1 つの決定のみが行われる単純化された世界では理にかなっているが、このアプローチを使用する実用的なシステムは少ない。一連の決定を行う必要がある場合、最初にリーダーを選出し、次にリーダーに決定を調整させる方がよりシンプルで高速である。(第 11 章では、リーダーを使用しないが状況によってはリーダーベースのアルゴリズムよりも効率的な Paxos の最近の変種である Egalitarian Paxos を議論する。ただし、このアルゴリズムはリーダーベースのアルゴリズムよりもはるかに複雑である。)

結果として、実用的なシステムは Paxos との類似性がほとんどない。各実装は Paxos から始まり、実装の困難さを発見し、その後、大きく異なるアーキテクチャを開発する。これは時間がかかり、エラーを起こしやすく、Paxos の理解の困難さが問題を悪化させる。Paxos の定式化は、その正しさに関する定理を証明するのには適しているかもしれないが、実際の実装は Paxos と大きく異なるため、証明にはほとんど価値がない。Chubby 実装者からの以下のコメントは典型的である。

There are significant gaps between the description of the Paxos algorithm and the needs of a real-world system.... the final system will be based on an unproven protocol [15].

Paxos アルゴリズムの記述と現実世界のシステムのニーズの間には大きなギャップがある.... 最終的なシステムは未検証のプロトコルに基づくことになるだろう [15]。

これらの問題のため、我々は Paxos がシステム構築にも教育にも適した基盤を提供しないと結論づけた。大規模ソフトウェアシステムにおけるコンセンサスの重要性を鑑み、我々は Paxos よりも優れた特性を持つ代替コンセンサスアルゴリズムを設計できるかどうかを検討することにした。Raft はその実験の結果である。

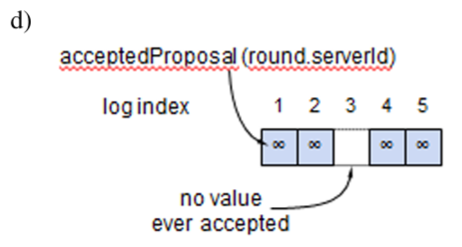

新しい提案番号 (proposal number) を選択する。一意性を保持するためにサーバ ID を含める。

Acceptor に Prepare リクエストを送信する。

Acceptor の過半数が応答した場合、同じ提案番号で Accept リクエストを Acceptor に送信する。

Acceptor の過半数が応答した場合、Accept リクエストの値がコミットされる。

Proposer からの Prepare および Accept リクエストを処理する。

| proposal | 提案番号 |

|---|

| acceptedProposal | この Acceptor がこれまでに Accept した最も高い提案番号 (存在する場合) |

|---|---|

| acceptedValue | この Acceptor がこれまでに Accept した最も高い提案の値 |

proposal が以前の Prepare または Accept リクエストにおけるどの番号よりも高い場合、その提案を保存して応答する。そうでない場合は応答しない。

| proposal | 提案番号 |

|---|---|

| value | Proposer が Accept 応答で何らかの acceptedValues を受信した場合、その値は最も高い acceptedProposal に対応するものでなければならない。そうでない場合、Proposer は任意の値を選択して良い。 |

proposal が以前の Prepare または Accept リクエストにおけるどの番号よりも高い場合、その提案と値を保存して応答する。そうでない場合は応答しない。

Chapter 3 - 基本 Raft アルゴリズム

Chapter 3 - 基本 Raft アルゴリズム

この章では Raft アルゴリズムについて説明する。我々は Raft を可能な限り理解しやすいように設計した。最初のセクションでは理解可能性を考慮した設計への我々のアプローチを記述する。続くセクションではアルゴリズム自体を記述し、理解可能性のために我々が行った選択の例を示す。

3.1 理解可能性の設計

3.1 理解可能性の設計

Raft の設計において、我々にはいくつかの目標があった。システム構築のための完全かつ実用的な基盤を提供し、開発者が必要とする設計作業量を大幅に削減すること。あらゆる条件下で Safety であり、典型的な運用条件下で可用性があること。そして、一般的な操作において効率的であることである。しかし、我々の最も重要な目標、そして最も困難な課題は理解可能性 (understandability) であった。幅広い読者がアルゴリズムを快適に理解できる必要がある。さらに、システム構築者が現実世界の実装で避けられない拡張を行えるように、アルゴリズムについての直感的な理解を得られるようにする必要がある。

Raft の設計には複数のアプローチから選択しなければならない局面が数多く存在した。これらの状況において我々は理解可能性に基づいて代替案を評価した。すなわち、それぞれの代替案を説明するのがどれほど難しいか (例えば、その状態空間の複雑さや、微妙な意味を持つのかなど)、そして読者がそのアプローチとその影響を完全に理解するのがどれほど容易か、と言う点である。

このような分析にかなりの主観性が含まれることは認識しているが、それでも我々は一般的に適用可能な 2 つの手法を用いた。1 つ目の手法はよく知られている問題分析のアプローチである。可能な限り、問題を比較的独立して解決、説明、理解できる個別の部分に分割した。例えば、Raft ではリーダー選出、ログ複製、Safety を分離した。

2 つ目の手法は、考慮すべき状態の数を減らすことで状態空間を単純化し、システムをより一貫性のあるものにし、可能な限り非決定性を排除することであった。具体的には、Raft はログに穴を許容せず、ログが互いに矛盾する可能性を制限する。ほとんどのケースで我々は非決定性を排除しようと試みたが、非決定性がむしろ理解可能性を向上させる状況もいくつか存在する。特に、ランダム化手法は非決定性をもたらすが、すべての可能な選択肢を同様に処理する (「どれを選んでも問題ない」) ことは状態空間を削減する傾向にある。我々は Raft のリーダー選出アルゴリズムを簡素化する目的でランダム化を使用した。

3.2 Raft の概要

3.2 Raft の概要

Raft はセクション 2.1 で説明した形式の複製ログを管理するためのアルゴリズムである。Figure 3.1 は参照のためにアルゴリズムを要約したもので、 Figure 3.2 はアルゴリズムの主要な特性を列挙している。これらの図の要素は本章の残りの部分で個別に説明する。

Raft はまず、サーバをリーダー (leader) として選出し、そしてリーダーに複製ログの管理に関する完全な責任を与えることでコンセンサスを実装する。リーダーはクライアントからのログエントリを受け入れ、他のサーバにそれらを複製し、それらのステートマシンにログエントリを適用しても安全なタイミングをサーバに伝える。リーダーの存在により複製ログの管理が簡素化される。例えば、リーダーは他のサーバと相談することなく新しいエントリをログ内で配置する場所を決定でき、データはリーダーから他のサーバへ単純な方法で流れる。リーダーは、故障したり、他のサーバから切断される可能性があり、その場合、新しいリーダーが選出される。

リーダーアプリーチに基づき、Raft はコンセンサス問題を 3 つの比較的独立した部分問題に分解する。これらの部分問題は以下のサブセクションで議論される。

リーダー選出: クラスタの起動時および既存のリーダーが故障したときに、新しいリーダーを選出する必要がある (セクション 3.4)。

ログ複製: リーダーはクライアントからのログエントリを受け入れ、それらをクラスタ全体に複製することで、他のログを自身のログと一致させることを強制する必要がある (セクション 3.5)。

Safety: Raft の重要な Safety 特性は Figure 3.2 に示す State Machine Safety 特性である。つまり、あるサーバが特定のログエントリを自身のステートマシンに適用した場合、他のいかなるサーバも同じログインデックスに対して異なるコマンドを適用してはならない。セクション 3.6 は Raft がこの特性をどのように保証するかを記述する。この解決策は、セクション 3.4 で説明する選出メカニズムに対して追加の制約を伴う。

この章ではコンセンサスアルゴリズムを紹介した後、可用性の問題とシステムにおけるタイミングの役割 (セクション 3.9)、およびサーバ間でリーダーシップを転送するためのオプションの拡張 (セクション 3.10) について議論する。

| currentTerm | サーバが認識した最新のターム (初回起動時に 0 に初期化され単調増加する) |

|---|---|

| votedFor | 現在のタームで票を投じた候補者の candidateId (投票がない場合は null) |

| log[] | ログエントリ; 各エントリには、ステートマシンへのコマンドと、リーダーがエントリを受信した時点のタームを含む (最初のインデックスは 1) |

| commitIndex | コミット済みと認識されている最大のログエントリのインデックス (0 で初期化され単純増加する) |

|---|---|

| lastApplied | ステートマシンに適用された最大のログエントリのインデックス (0 で初期化され単調増加する) |

| nextIndex[] | 各サーバに対し、そのサーバに送信する次のログエントリのインデックス (リーダーの最後のログインデックス + 1 に初期化される) |

|---|---|

| matchIndex[] | 各サーバに対し、サーバで複製済みとして認識されている最大のログエントリのインデックス (0 に初期化され単調増加する) |

ログエントリを複製するためにリーダーによって呼び出される (§3.5)。ハートビートとしても使用される (§3.4)。

| term | リーダーのターム |

|---|---|

| leaderId | フォロワーがクライアントをリダイレクトできるようにするため |

| prevLogIndex | 新しいエントリの直前のログエントリのインデックス |

| prevLogTerm | prevLogIndex エントリのターム |

| entries[] | 保存するエントリ (ハートビートの場合は空; 効率化のため複数送信可能) |

| leaderCommit | リーダーの commitIndex |

| term | currentTerm (リーダーが自身を更新するため) |

|---|---|

| success | フォロワーが prevLogIndex と prevLogTerm に一致するエントリを含んでいた場合 true |

- commitIndex > lastApplied の場合: lastApplied をインクリメントし、log[lastApplied] をステートマシンに適用 (§3.5)

- RPC リクエスト/レスポンスがターム T > currentTerm を含む場合: currentTerm = T を設定しフォロワーに転身

- 候補者およびリーダーからの RPC に応答

- 現在のリーダーから AppendEntries RPC を受信せず、または候補者に投票することなく選挙タイムアウトが経過した場合: 候補者に転身

- 候補者に転身したら選挙を開始する:

- currentTerm をインクリメント

- 自身に投票

- 選挙タイマーをリセット

- 他のすべてのサーバに RequestVote RPC を送信

- 過半数のサーバから投票を受け取った場合: リーダーに転身

- 新しいリーダーから AppendEntries RPC を受信した場合: フォロワーに転身

- 選挙タイムアウトが経過した場合: 新しい選挙を開始

- 選出後: 最初に各サーバに空の AppendEntries RPC (ハートビート) 送信; 選挙タイムアウトを防ぐためにアイドル期間中も繰り返す (§3.4)

- クライアントからコマンドを受信した場合: ローカルログにエントリを追記し、エントリがステートマシンに適用された後に応答 (§3.5)

- フォロワーの最後のログインデックスが nextIndex より大きい場合: nextIndex から始まるログエントリを含む AppendEntries RPC を送信

- N > commitIndex であり、過半数のサーバが matchIndex[i] ≧ N であり、log[N}.term == currentTerm であるような N が存在する場合: commitIndex = N に設定 (§3.5, §3.6)

Election Safety

Election Safety-

特定のタームでは最大で 1 つのリーダーのみが選出される。§3.4

Leader Append-Only

Leader Append-Only-

リーダーは自身のログ内のエントリを上書きや削除することはなく、新しいエントリを追記するのみである。§3.5

Log Matching

Log Matching-

もし 2 つのログが同じインデックスとタームのエントリを持つならば、そのインデックスまでのすべてのエントリにおいて、ログの内容は同一である。§3.5

Leader Completeness

Leader Completeness-

もし特定のタームであるログエントリがコミットされたならば、そのエントリは、それより番号の大きいタームのすべてのリーダーのログに存在する。§3.6

State Machine Safety

State Machine Safety-

もしあるサーバが特定のインデックスのログエントリを自身のステートマシンに適用したならば、他のサーバは同じインデックスに対して異なるログエントリを適用することはない。§3.6

3.3 Raft の基本

3.3 Raft の基本

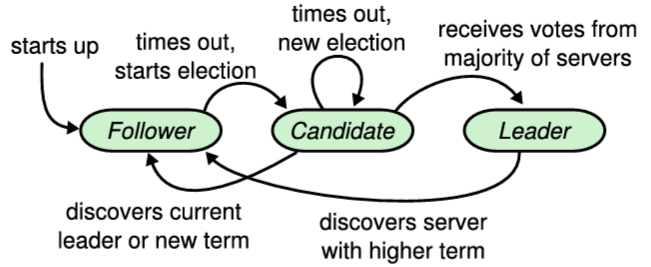

Raft クラスタは複数のサーバで構成される。通常は 5 台が典型的な数であり、これによりシステムは 2 台の故障に耐えることができる。任意の時点において、各サーバはリーダー (leader)、フォロワー (follower)、候補者 (candidate) の 3 つの状態のいずれかにある。通常の動作では、厳密に 1 台のリーダーが存在し、他のすべてのサーバがフォロワーである。フォロワーは受動的であり、自らはリクエストを発行せず、単にリーダーと候補者からのリクエストに応答するのみである。リーダーはすべてのクライアントリクエストを処理する (もしクライアントがフォロワーに接続した場合、フォロワーはそれをリーダーにリダイレクトする)。3 つ目の状態である候補者は、セクション 3.4 で記述されているように、新しいリーダーを選出するために使用される。Figure 3.3 は状態とその遷移を示しており、遷移については後述する。

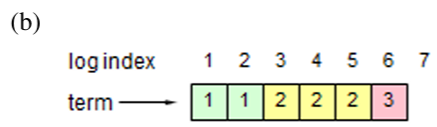

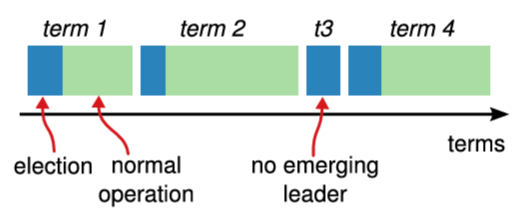

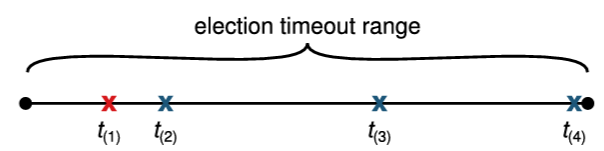

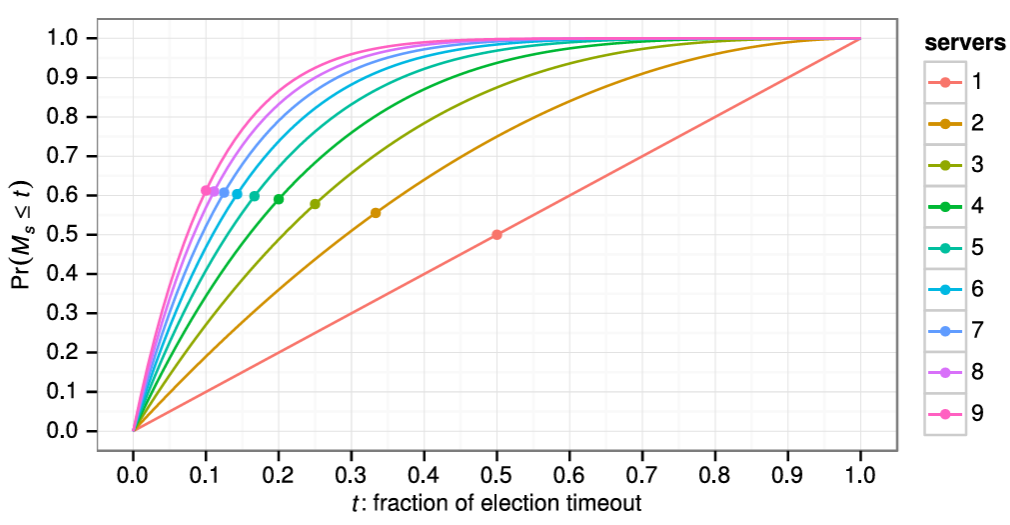

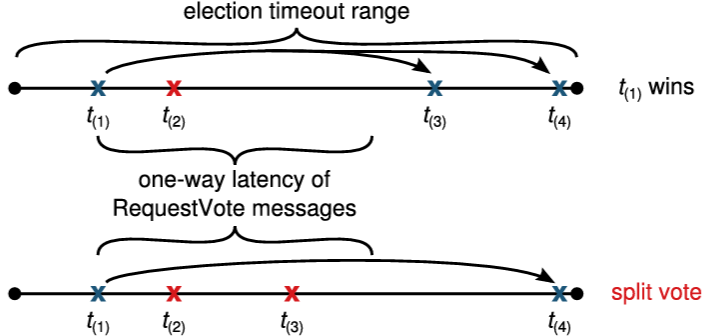

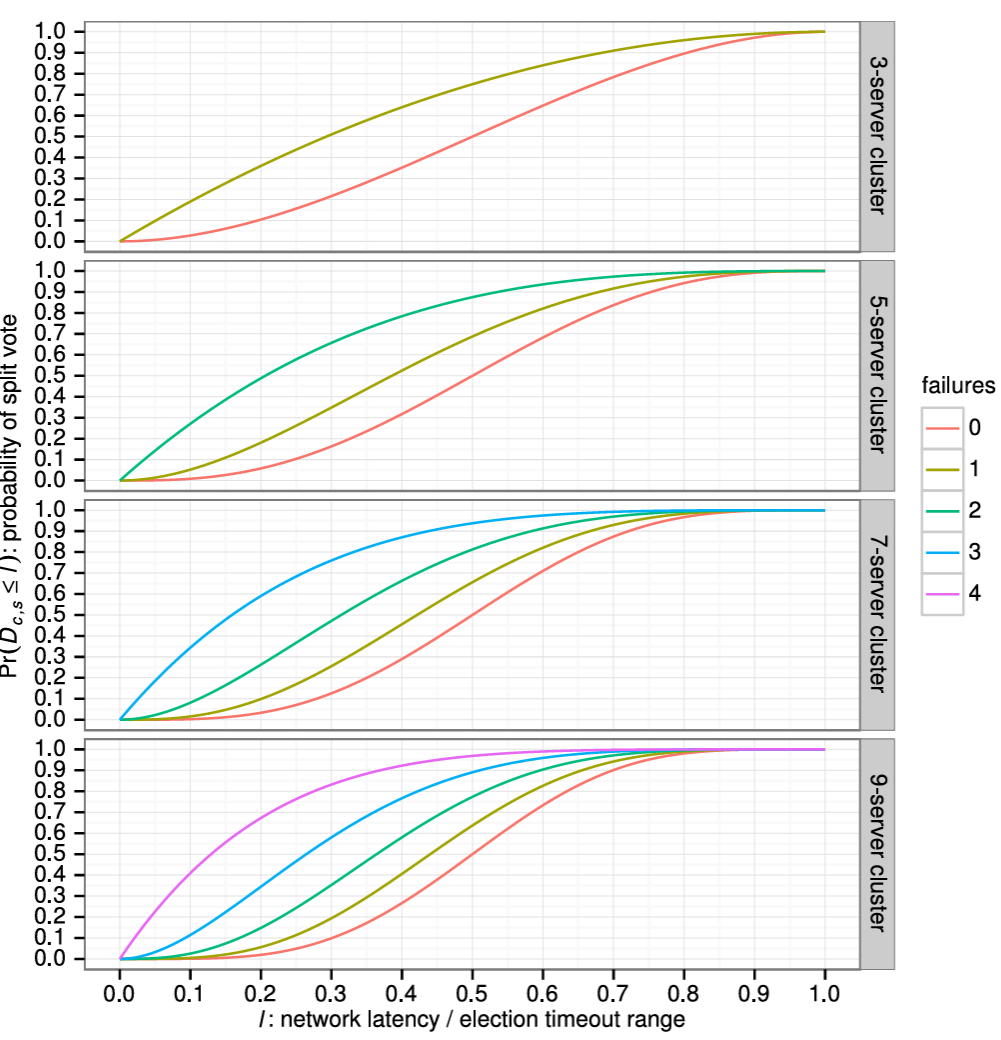

Raft は Figure 3.4 に示すように時間を任意の長さのターム (term) に分割する。タームには連続した整数が番号付けされる。各タームは選挙 (election) から始まり、セクション 3.4 で記述されているように、選挙では 1 つ以上の候補者がリーダーになろうと試みる。ある候補者が選挙に勝利すれば、その候補者はタームの残りの期間のリーダーを務める。状況によっては分割投票 (split vote) となる場合がある。この場合、タームはリーダー不在で終了し、すぐに新しいターム (新しい選挙) が始まる。Raft は、特定のタームにおいてリーダーが最大 1 つしか存在しないことを保証する。

異なるサーバは異なるタイミングでターム間の遷移を観測する可能性があり、状況によってはサーバが選挙やターム全体を観測しないことさえある。タームは Raft において論理クロック [47] とし機能し、古いリーダーなどの期限の切れた情報をサーバが検出できるようにする。各サーバは時間の経過と共に単調増加する現在のターム (current term) を保存している。現在のタームはサーバが通信するたびに交換される。あるサーバの現在のタームが、他の一方のサーバの現在のタームより小さい場合、そのサーバは自身の現在のタームを大きい方の値に更新する。もし候補者やリーダーが自身のタームが期限切れであると気づくと、直ちにフォロワー状態に戻る。サーバが期限切れのターム番号を持つリクエストを受信した場合、そのリクエストを拒否する。

Raft サーバはリモートプロシジャコール (RPC) を使用して通信し、基本的なコンセンサスアルゴリズムにおいてはサーバ間で 2 種類の RPC のみを必要とする。RequestVote RPC は選挙中に候補者によって開始される (セクション 3.4)。AppendEntries RPC はリーダーによって開始され、ログエントリを複製し、一種のハートビートの役割を提供する (セクション 3.5)。リーダーシップ転送 (セクション 3.10) およびそれ以降の章で記述されるメカニズムは、コアコンセンサスアルゴリズムの 2 種類に加えて追加の RPC を導入する。

我々は通信パターンを簡素化するために Raft での通信を RPC として構築することを選択した。各リクエストタイプには対応するレスポンスタイプがあり、レスポンスタイプはリクエストの確認応答としても機能する。Raft は RPC リクエストとレスポンスがネットワーク内で失われる可能性があることを想定している。リクエスト側が適切なタイミングでレスポンスを受信しない場合、RPC を再試行するのはリクエスト側の責任である。サーバは性能を最大化するために RPC を並列に発行するが、Raft はネットワークが RPC 間の順序を維持することを想定していない。

3.4 リーダー選出

3.4 リーダー選出

Raft はリーダー選出をトリガーするためにハートビートメカニズムを使用する。サーバは起動時にフォロワーとして開始する。サーバは、リーダーまたは候補者から有効な RPC を受信している限りフォロワー状態を維持する。リーダーは権限を維持するために定期的にハートビート (ログエントリを含まない AppendEntries RPC) をすべてのフォロワーに送信する。もしフォロワーが選挙タイムアウト (election timeout) と呼ばれる期間内に通信を受信しない場合、有効なリーダーが存在しないとみなし、新しいリーダーを選出するための選挙を開始する。

選挙を開始するには、フォロワーは現在のタームをインクリメントし、候補者状態に遷移する。その後、フォロワーは自身に投票し、並行してクラスタ内の他の各サーバに RequestVote RPC を発行する。候補サーバは次の 3 つの条件のいずれかが発生するまでこの状態を維持する: (a) 選挙に勝利する、(b) 別のサーバがリーダーとして確率する、(c) 勝者が決まらないまま再度選挙タイムアウトが発生する。これらの結果については以下の段落で個別に議論する。

候補者は、同じタームにおいてクラスタ全体のサーバの過半数から票を獲得すると選挙に勝利する。各サーバは、与えられたタームにおいて、先着順で最大 1 つの候補者に投票する (注: セクション 3.6 は投票に関する追加の制約を追加する)。過半数ルールによって特定のタームにおいて最大 1 つの候補者のみが選挙に勝利することを保証する (Figure 3.2 の Election Safety 特性)。候補者が選挙に勝利するとリーダーとなる。その後、他のすべてのサーバにハートビートメッセージを送信し、権限を確立して新たな選挙を防止する。

候補者が投票を待っている間、自身がリーダーであると主張する別のサーバから AppendEntries RPC を受信するケースがある。もしそのリーダーのターム (RPC に含まれている) が候補者の現在のタームと少なくと同じか大きい場合、候補者はそのリーダーを正当なものとして認識し、フォロワー状態に戻る。RPC 中のタームが候補者の現在のタームより小さい場合、候補者はその RPC を拒否し、候補者状態を継続する。

3 つ目の可能性は、候補者が選挙に勝つことも負けることもない場合である。多くのフォロワーが同時に候補者になった場合、票が分散し、どの候補者も過半数の票を獲得できない可能性がある。このような場合、各候補者はタイムアウトし、自身のタームをインクリメントして RequestVote RPC の次のラウンドを開始することで新しい選挙を開始する。しかし、追加の対策がなければ分割投票は無限に繰り返される可能性がある。

Raft は分割投票の発生頻度を低くし迅速に解決することを保証するために、ランダム化された選挙タイムアウトを使用する。つまり、分割投票を防ぐために、選挙タイムアウトは固定間隔 (例: 150~300 ミリ秒) からランダムに選択される。これによりサーバが分散され、ほとんどの場合、タイムアウトするのは単一のサーバのみになる。そのサーバは選挙に勝利し、他のどのサーバがタイムアウトする前にハートビートを送信する。同じメカニズムが分割投票にも使用される。各候補者は、選挙の開始時にランダム化された選挙タイムアウトを再開し、次の選挙を開始する前にそのタイムアウトが経過するのを待つ。これにより、新しい選挙でさらなる分割投票が起きる可能性が低くなる。第 9 章では、このアプローチによってリーダーが迅速に選出されることを示している。

選挙は、理解可能性が設計上の選択肢の間で我々の選択にどのように影響したかを示す一例である。当初、我々はランキングシステムを使用することを計画していた。各候補者には一位のランクが割り当てられ、このランクに基づいて競合する候補者が選出された。もし候補者がより高いランクの別の候補を発見した場合、フォロワー状態に戻り、より高いランクの候補者が次の選挙で勝利しやすくなる。我々はこのアプローチが可用性に関して微妙な (subtle) 問題を生じさせることを発見した (高ランクサーバに障害が発生した場合、低ランクサーバはタイムアウトして再び候補者になる必要があるかもしれないが、それがあまりに早すぎると、リーダー選出のための進捗をリセットしてしまう可能性がある)。我々はアルゴリズムに何度か調整を加えたが、調整のたびに新たなコーナーケースが発生した。最終的に、ランダム化された再試行アプローチがより明確で理解しやすいという結論に至った。

3.5 ログ複製

3.5 ログ複製

リーダーが選出されると、リーダーはクライアントからのリクエスト処理を開始する。各クライアントリクエストには、複製ステートマシンによって実行されるコマンドが含まれている。リーダーはコマンドを新しいエントリとしてログに追記し、その後、エントリを複製するために他の各サーバに並行して AppendEntries RPC を発行する。エントリが完全に複製されると (後述)、リーダーはそのエントリを自身のステートマシンに適用し、その実行結果をクライアントに返す。もしフォロワーがクラッシュしたり、動作が遅くなったり、ネットワークパケットが失われた場合でも、リーダーはすべてのフォロワーがすべてのログエントリを最終的に格納するまで AppendEntries RPC を (クライアントへの応答後であっても) 無期限に再試行する。

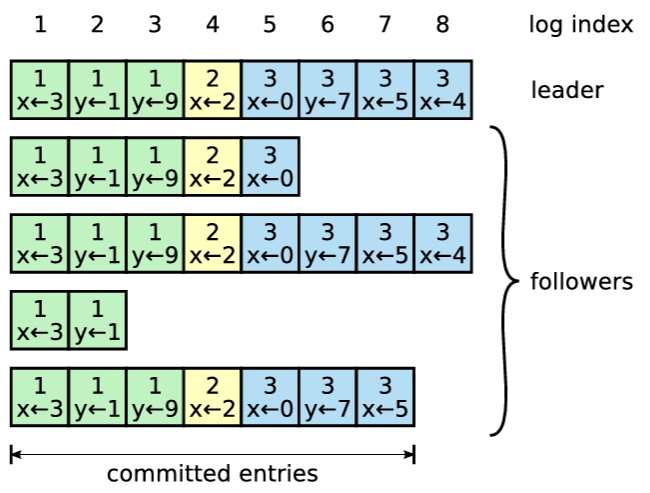

ログは Figure 3.5 に示すように構成される。各ログエントリには、リーダーがエントリを受信した時点のターム番号と、ステートマシンのコマンドが格納される。ログエントリ内のターム番号はログ間の不整合を検出し、Figure 3.2 にいくつかの特性を保証するために使用される。各ログエントリにはログ内の位置を示す整数インデックスも付与される。

リーダーは、ログエントリをステートマシンに適用しても安全な時期を決定する。そのようなエントリはコミット済み (committed) と呼ばれる。Raft は、コミット済みエントリが永続的であり、最終的には利用可能なすべてのステートマシンによって実行されることを保証する。ログエントリは、そのエントリを作成したリーダーがそれを過半数のサーバに複製した時点でコミットされる (例えば Figure 3.5 の Entry 7)。これにより、リーダーのログ内でそれより前に存在するすべてのエントリ (以前のリーダーによって作成されたエントリを含む) もコミットされる。セクション 3.6 ではリーダー交代後にこのルールを適用する際の微妙な点について議論し、またこのコミットの定義が Safety であることも示す。リーダーは、コミット済みであると認識している最も高いインデックスを追跡し、そのインデックスを将来の AppendEntries RPC (ハートビートを含む) に含めることで、他のサーバが最終的にそのインデックスを知ることを可能にする。フォロワーはログエントリがコミット済みであることを知ると、そのエントリを (ログの順序で) ローカルのステートマシンに適用する。

我々は、異なるサーバ上のログ間で高度な一貫性を維持するように Raft のログメカニズムを設計した。これはシステムの動作を簡素化し、予測可能性を高めるだけでなく、Safety を保証するための重要な要素でもある。Raft は以下の特性を維持しており、これは Figure 3.2 の Log Matching 特性を構成する。

異なるログ内の 2 つのエントリが同じインデックスとタームを持つ場合、それらは同じコマンドを格納する。

異なるログ内の 2 つのエントリが同じインデックスとタームを持つ場合、そのログは与えられたインデックスまでの先行するエントリすべてにおいて同一である。

一つ目の特性は、リーダーが特定のタームにおいて特定のログインデックスを持つエントリを最大で 1 つしか作成せず、ログエントリがログ内の位置を変更することがないという事実から導かれる。二つ目の特性は AppendEntries によって実行される一貫性チェックによって保証される。AppendEntries RPC を送信する際、リーダーは新しいエントリの直前に位置する自身のエントリインデックスとタームを含める。もしフォロワーが自身のログ内で同じインデックスとタームを持つエントリを見つけられない場合、新しいエントリを拒否する。この一貫性チェックは帰納ステップとして機能する。ログの初期状態は空で Log Matching 特性を見たており、一貫性チェックはログが拡張されるたびに Log Matching 特性を維持する。結果として、AppendEntries が成功して返るたびに、リーダーはフォロワーのログが新しいエントリまで自身のログと同一であることを認識する。

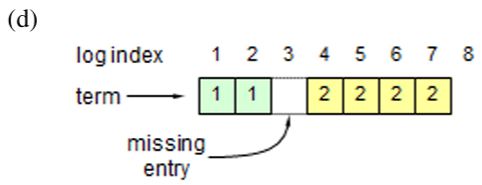

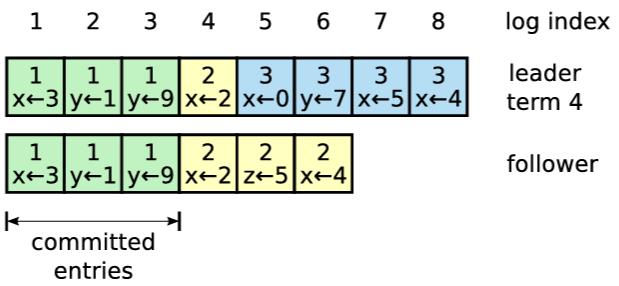

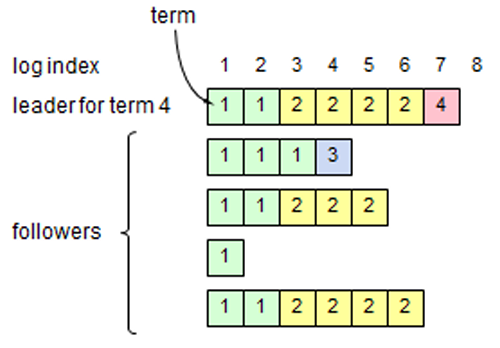

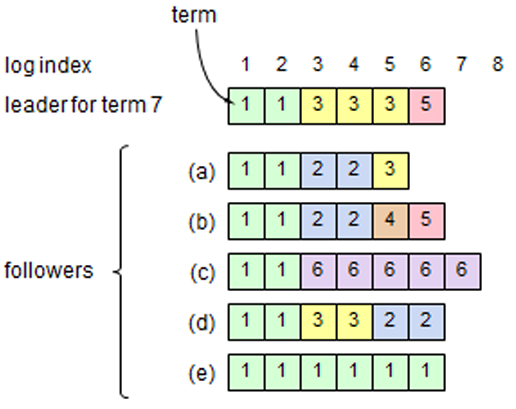

通常の動作中は、リーダーとフォロワーのログは一貫性が保たれているため AppendEntries の一貫性チェックが失敗することはない。しかしリーダーがクラッシュするとログに不整合が生じる可能性がある (古いリーダーが自身のロブ内のすべてのエントリを完全に複製できなかった可能性がある)。これらの不整合はリーダーとフォロワーが何度もクラッシュすることで複合して悪化する可能性がある。Figure 3.6 はフォロワーのログが新しいリーダーのログとどのように異なるかを示している。フォロワーではリーダーに存在するエントリが欠落しているかもしれないし、リーダーには存在していない余分なエントリを持っているかもしれないし、またその両方かもしれない。ログの欠落エントリと余分なエントリは複数のタームにまたがる可能性がある。

Raft では、リーダーはフォロワーのログを自身のログと同じように鳴るように強制することで不整合を処理する。これは、フォロワーのログに存在する競合するエントリがリーダーのログからのエントリで上書きされることを意味する。セクション 3.6 では、選挙における制約と組み合わせることでこれが安全であることを示す。

リーダーは、フォロワーのログを自身のログと整合させるために、2 つのログが一致する最新のエントリを見つけ、その時点以降のフォロワーのログエントリをすべて削除し、その時点以降のリーダーのエントリをすべてフォルワーに送信する必要がある。これらのアクションはすべて AppendEntries RPC によって実行される一貫性チェックに応答して発生する。リーダーは各フォロワーに対して nextIndex を保持する。これは、リーダーがそのフォロワーに送信する次のエントリのインデックスである。リーダーが最初に権限を得たとき、すべての nextIndex を自身のログの最後のインデックスの次 (Figure 3.6 では 11) に初期化する。もしフォロワーのログがリーダーのログと整合しない場合、次の AppendEntries RPC で AppendEntries 一貫性チェックが失敗する。拒否後、リーダーはフォロワーの nextIndex をデクリメントし、AppendEntries RPC を再試行する。最終的に nextIndex はリーダーとフォロワーのログが一致する点に到達する。この状況が発生すると AppendEntries は成功し、フォロワーのログから競合するエントリを削除し、(もしあれば) リーダーのログからエントリを追加する。AppendEntries が成功すると、フォロワーのログはリーダーのログと一貫し、その状態はタームの残りの期間を通して維持される。

リーダーは、自身とフォロワーのログが一致する箇所を見つけるまで、帯域幅を節約するためにエントリを含まない AppendEntries を (ハートビートのように) 送信できる。その後、matchIndex が nextIndex の直前に達すると、リーダーは実際のエントリの送信を開始する必要がある。

必要に応じて、プロトコルを最適化して拒否される AppendEntries RPC の数を減らすことができる。例えばフォロワーが AppendEntries リクエストを拒否する際に、競合するエントリのタームと、そのタームに格納されている最初のインデックスを含めることができる。この情報を使ってリーダーは nextIndex をデクリメントし、そのターム内のすべての競合エントリを迂回できる。これによってエントリごとに 1 つの RPC を実行するのではなく、エントリが競合する各タームで 1 つの AppendEntries RPC が必要となる。あるいは、リーダーはフォロワーのログが自身のログと異なる最初のエントリを見つけるために二分探索アプローチを使用することもできる。これは最悪ケースの動作がより優れている。しかし、実際には故障は頻繁に発生せず、不整合なエントリが多数発生する可能性は低いため、我々はこれらの最適化が必要であるとは考えていない。

このメカニズムにより、リーダーは権限を得たときにログの一貫性を回避服するための特別な行動を取る必要がない。通常動作を開始するだけで AppendEntries 一貫性チェックの失敗に応じてログは自動的に収束する。リーダーは自身のログ内のエントリを上書きしたり削除することはない (Figure 3.2 の Leader Append-Only 特性)。

このログ複製メカニズムはセクション 2.1 で説明した望ましいコンセンサス特性を備えている。Raft は、サーバの過半数が稼働している限り、新しいログエントリを受け入れ、複製し、適用することができる。通常の場合、新しいログエントリはクラスタの過半数へ 1 回の RPC ラウンドで複製できる。また、1 つの低速のフォロワーが性能に影響を与えることはない。他のコンセンサスアルゴリズムの中には、ログ全体をネットワーク経由で送信して実用的な実装のために必要な最適化の負担を実装者に課すものもあるが、このログ複製アルゴリズムは、AppendEntries リクエストが管理しやすいサイズなため (リーダーは処理を進めるために 1 回の AppendEntries リクエストで複数のエントリを送信する必要はない)、実装も実用的である。

3.6 Safety

3.6 Safety

前のセクションでは、Raft がどのようにリーダーを選出し、ログエントリを複製するかについて説明した。しかし、これまでに説明したメカニズムだけでは、各ステートマシンが同じコマンドを厳密に同じ順序で実行することを保証するに十分ではない。例えば、リーダーがいくつかのログエントリをコミットしている間にフォロワーが利用できなくなると、そのフォロワーがリーダーに選出され、これらのエントリを新しいエントリで上書きする可能性がある。結果として、異なるステートマシンが異なるコマンドシーケンスを実行する可能性がある。

このセクションでは、どのサーバがリーダーに選出されるかを制限することで Raft アルゴリズムを完成させる。この制限により、任意のタームのリーダーが、前のタームでコミットされたすべてのエントリを含むことが保証される (Figure 3.2 の Leader Completeness 特性)。この選出制限を考慮した上で、我々のコミットのルールをより厳密にする。最後に、Leader Completeness 特性の証明スケッチを提示し、それが複製ステートマシンの正しい動作にどのようにつながるかを示す。

3.6.1 選出制約

3.6.1 選出制約

リーダーベースのコンセンサスアルゴリズムでは、リーダーは最終的にコミットされたログエントリをすべて保存する必要がある。Viewstamped Replication [66] のような一部のコンセンサスアルゴリズムでは、リーダーはコミットされたエントリを最初からすべて保持していなくても選出されることが可能である。これらのアルゴリズムには、選挙プロセス中またはその直後に、欠落しているエントリを特定し、新しいリーダーにそれらを送信するための追加のメカニズムが含まれている。残念ながら、これはかなりの追加メカニズムと複雑さをもたらす。Raft はより単純なアプローチを採用しており、新しいリーダーが選出された瞬間からそのリーダー上に以前のタームでコミットされたすべてのエントリが存在することを保証する。これらのエントリをリーダーに転送する必要はない。これは、ログがリーダーからフォロワーへの一方向にのみ流れ、リーダーがログ内の既存のエントリを上書きしないことを意味する。

Raft は、候補者のログにすべてのコミット済みエントリが含まれていない限り、その候補者が選挙に勝つことができない選挙プロセスを使用する。候補者が選挙に勝つためにはクラスタの過半数とコンタクトを取る必要がある。つまり、その中の少なくとも 1 つのサーバには、コミットされたすべてのエントリが存在するはずである。もし候補者のログがその過半数に属する他のログと同等かそれ以上に最新である場合 (「最新である (up-to-date)」は以下で正確に定義される)、候補者はコミットされたすべてのエントリを保持していることになる。RequestVote RPC はこの制限を実装いている。RPC は候補者のログに関する情報を含み、もし投票者のログが候補者のログよりも新しければ、投票者は投票を拒否する。

Raft では、2 つのログのどちらがより最新であるかを、ログ内の最後のエントリのインデックスとタームを比較することで判断する。2 つのログの最後のエントリのタームが異なる場合、より後のタームを持つログの方がより新しい。もしログが同じタームで終わる場合、より長いログの方がより最新である。

3.6.2 以前のタームからのエントリコミット

3.6.2 以前のタームからのエントリコミット

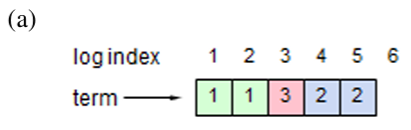

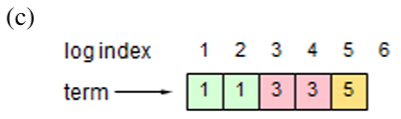

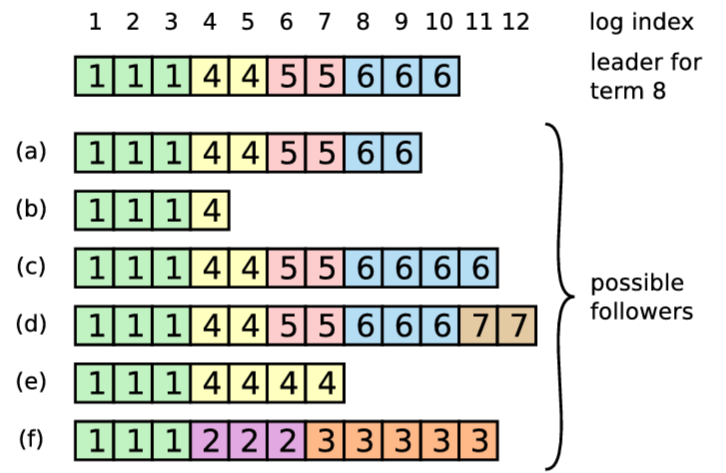

セクション 3.5 で記述したように、リーダーは自身の現在のタームでのエントリが過半数のサーバに保存された時点で、そのエントリがコミット済みであることと認識する。リーダーがエントリをコミットする前にクラッシュした場合、将来のリーダーはそのエントリの複製を完了させようと試みる。しかし、リーダーは、前のタームのエントリがサーバの過半数に保存されたからと言って、そのエントリが直ちにコミット済みであると結論付けることはできない。Figure 3.7 は古いログエントリが過半数のサーバに保存されているにもかかわらず、将来のリーダーによって上書きされる可能性がある状況を示している。

Figure 3.7 のような問題を排除するために、Raft はレプリカを数えることによって以前のタームからのログエントリをコミットすることはない。リーダーの現在のタームでのエントリのみがレプリカを数えることでコミットされる。現在のタームでのエントリがこの方法でコミットされると、Log Matching 特性によってそれ以前のすべてのエントリが間接的にコミットされる。リーダーは古いログエントリがコミット済みであると安全に結論づけられる状況もいくつか存在するが (例えばそのエントリがすべてのサーバに保存されている場合など)、Raft は簡潔さのためにより保守的なアプローチを採用している。

Raft では、リーダーが以前のタームでのエントリを複製する際に、ログエントリが元のターム番号を保持するために、コミットルールにこのような追加の複雑さが生じる。他のコンセンサスアルゴリズムでは、新しいリーダーが以前の「ターム」でのエントリを再複製する場合、新しい「ターム番号」で複製しなければならない。Raft のアプローチでは、ログエントリは時間の経過とログの経過にかかわらず同じターム番号を維持するため、ログエントリについての推論を容易にする。さらに、他のアルゴリズムではコミット前にエントリの番号を付け直すため冗長なログエントリの送信を行う必要があるが、Raft の新しいリーダーは以前のタームでのログエントリの送信は他のアルゴリズムよりも少ない。しかし、リーダーの変更はまれであるはずなので、これは実際ににはそれほど重要ではないかもしれない。

3.6.3 Safety 論証

3.6.3 Safety 論証

完全な Raft アルゴリズムが与えられたので、ここで Leader Completeness 特性が成立することをより正確に議論できる (この論証は Safety の証明に基づいている; 第 8 章を参照)。我々は Leader Completeness 特性が成り立たないと仮定し、矛盾を証明する。ターム \(T\) のリーダー (\({\rm leader}_T\)) が自身のタームでのログエントリをコミットしたが、そのログエントリは将来のタームのリーダーに保存されていなかったと仮定する。\(U \gt T\) となる最小のタームを持つ、そのエントリを保存していないリーダー (\({\rm leader}_U\)) について考える。

コミットされたエントリは、\({\rm leader}_U\) が選出された時点で \({\rm leader}_U\) のログに存在してはならない (リーダーはエントリを削除または上書きしないため)。

\({\rm leader}_T\) はクラスタの過半数にエントリを複製し、\({\rm leader}_U\) はクラスタの過半数から票を得た。したがって、Figure 3.8 に示すように、少なくとも 1 つのサーバ (以下「投票者」と呼ぶ) が \({\rm leader}_T\) からエントリを受け入れ、\({\rm leader}_U\) に投票した。この投票者が矛盾に到達するための鍵である。

Figure 3.8: S1 (ターム T のリーダー) が自身のタームから新しいログエントリをコミットし、S5 がより後のターム U のリーダーに選出された場合、そのログエントリを受け入れ、かつ S5 に投票した少なくとも 1 つのサーバ (S3) が存在しなければならない。 投票者は \({\rm leader}_U\) に投票する前に \({\rm leader}_T\) がコミットしたエントリを受け入れていなければならない。そうでなければ \({\rm leader}_T\) からの AppendEntries リクエストを (その現在のタームが \(T\) より大きかったため) 拒否していたであろう。

投票者は \({\rm leader}_U\) に投票したときもエントリを保存していた。これは、介入するすべてのリーダーがエントリを含んでおり (仮定により)、リーダーはエントリを削除することはなく、フォロワーはリーダーと競合する場合にのみエントリを削除するためである。

投票者は \({\rm leader}_U\) に投票を許可したため、\({\rm leader}_U\) のログは投票者のログと同程度に最新のはずである。これは 2 つの矛盾のうちの 1 つにつながる。

まず、投票者と \({\rm leader}_U\) が同じログタームを共有していた場合、\({\rm leader}_U\) のログは少なくとも投票者のログと同じ長さだったはずで、したがって \({\rm leader}_U\) のログは投票者のログ内のすべてのエントリを含んでいるはずである。これは矛盾である。なぜなら、投票者はコミットされたエントリを含んでいたにもかかわらず、\({\rm leader}_U\) は含んでいないと仮定されたためである。

そうでなければ、\({\rm leader}_U\) の最後のログタームは投票者の最後のログタームよりも大きくなっていたはずである。さらに、投票者の最後のログエントリは少なくとも \(T\) であったため (ターム \(T\) のコミット済みエントリを含むため)、\({\rm leader}_U\) の最後のログタームは \(T\) よりも大きかった。\({\rm leader}_U\) の最後のログエントリを作成した以前のリーダーは、そのログにコミット済みのログを必ず含んでいる (仮定より)。その場合、Log Matching 特性により、\({\rm leader}_U\) のログもコミット済みエントリを含んでいるはずである。これは矛盾である。

これで矛盾によって完了する。したがって、\(T\) より大きいタームのリーダーは、ターム \(T\) でコミットされたターム \(T\) でのすべてのエントリを必ず含んでいる。

Log Matching 特性により、将来のリーダーも Figure 3.7(d2) のインデックス 2 のような間接的にコミットされたエントリを含むことを保証する。

Leader Completeness 特性が与えられると、Figure 3.2 の State Machine Safety 特性をより正確に証明できる。これは、あるサーバが特定のインデックスのログエントリを自身のステートマシンに適用した場合、他のいかなるサーバも同じインデックスに対して異なるログエントリを適用することはないことを述べている。サーバがログエントリを自身のステートマシンに適用した時点で、炉のログはそのエントリまでのリーダーのログと同一であり、そのエントリはコミット済みでなければならない。ここで、いずれかのサーバが特定のログインデックスを適用する最も小さいタームを考える。Leader Completeness 特性は、それより高いタームのすべてのリーダーが同じログエントリを保存していることを保証するため、後続のタームでそのインデックスを適用するサーバは同じ値を適用することになる。したがって State Machine Safety 特性は成立する。

最後に、Raft はサーバがログインデックスの順序でエントリを適用することを要求する。State Machine Safety 特性と組み合わせることで、すべてのサーバが厳密に同じログエントリのセットを同じ順序でステートマシンに適用することを意味する。

3.7 フォロワーおよび候補者のクラッシュ

3.7 フォロワーおよび候補者のクラッシュ

ここまで、我々はリーダーの故障に焦点を当ててきた。フォロワーおよび候補者のクラッシュは、リーダーのクラッシュよりもはるかに処理が簡単であり、どちらも同じ方法で処理される。フォロワーまたは候補者がクラッシュした場合 (または、それらとリーダー間のネットワークリンクに障害が発生した場合)、それ以降に送信される RequestVote および AppendEntries RPC は失敗する。Raft はこれらの失敗を無制限に再試行することで処理する。クラッシュしたサーバが再起動すれば RPC は正常に完了する。サーバが RPC を完了した直後、応答する前にクラッシュした場合、再起動後に同じ RPC を再度受信することになる。Raft の RPC は繰り返されても同じ効果を持つため、これによる問題は発生しない。例えば、もしフォロワーが自身のログに既に存在するログエントリを含む AppendEntries リクエストを受信した場合、新しいリクエスト内のそれらのエントリを無視する。

3.8 永続状態とサーバの再起動

3.8 永続状態とサーバの再起動

Raft サーバは、サーバの再起動を安全に乗り切るために十分な情報を安定したストレージに永続化しなければならない。特に、各サーバは自身の現在のタームと投票を永続化する。これは、サーバが同じタームで二度投票すること、また退任したリーダーのログエントリで新しいリーダーのログエントリを置き換えることを防ぐために必要である。各サーバはまた、新しいログエントリがコミット対象としてカウントされる前にそれらを永続化する。これにより、サーバの再起動時にコミットされたエントリが失われたり、「未コミット」となることを防ぐ。

それ以外の状態変数はすべて再作成可能であるため、再起動時に失われても安全である。最も興味深い例はコミットインデックスである。これは再起動時に安全にゼロに再初期化できる。たとえすべてのサーバが同時に再起動したとしても、コミットインデックスは一時的に実際の値から遅れるに過ぎない。リーダーが選出され、新しいエントリをコミットできるようになると、そのリーダーのコミットインデックスは進み、コミットインデックスはすぐにフォロワーに伝播される。

ステートマシンは揮発的でも永続的でもあり得る。揮発性ステートマシンは、再起動後に (最新のスナップショットを適用した後; 第 5 章参照) ログエントリを再適用することによって回復されなければならない。一方、永続性ステートマシンは再起動後にはほとんどのエントリを既に適用している。それらを再適用するのを避けるためには、その最後に適用済み (last applied) インデックスも永続化されていなければならない。

サーバが永続的な状態の一部を失った場合、以前の識別情報でクラスタに安全に再参加することはできない。そのようなサーバは通常、クラスタメンバーシップ変更を呼び出すことによって新しい識別情報で再びクラスタに参加できる (第 4 章参照)。ただし、もしクラスタの過半数がその永続状態を失った場合、ログエントリが失われ、クラスタメンバーシップ変更を進めることは不可能となる。続行するためには、システム管理者はデータ損失の可能性を認識しなければならないだろう。

3.9 タイミングと可用性

3.9 タイミングと可用性

Raft に対する我々の要件の一つは Safety がタイミングに依存してはならないということである。つまり、あるイベントが予想よりも早くまたは遅く発生したという理由だけでシステムが誤った結果を生成してはならない。しかし、可用性 (システムがクライアントにタイムリーに応答する能力) は必然的にタイミングに依存する。例えば、サーバのクラッシュ間隔よりもメッセージの交換の方が時間がかかる場合、候補者は選挙に勝つまで十分に長く稼働し続けることができない。安定したリーダーがいなければ Raft は進捗できない。

リーダー選出は Raft においてタイミングが最も重要となる部分である。システムが以下のタイミング要件 (timing requirements) を満たしている場合、Raft は安定してリーダーを選出し維持することができる: \[ broadcastTime \ll electionTimeout \ll MTBF \] この不等式における \(broadcastTime\) は、サーバがクラスタ内のすべてのサーバに並行して RPC を送信し、それらの応答を受信するのにかかる平均時間である。\(electionTimeout\) はセクション 3.4 で説明した選挙タイムアウトである。\(MTBF\) は単一のサーバの故障間隔の平均時間である。\(broadcastTime\) は \(electionTimeout\) よりも一桁小さくする必要がある。これにより、リーダーはフォロワーが選挙を開始するのを防ぐためのハートビートメッセージを確実に送信できる。選挙タイムアウトにはランダム化アプローチが使用されるため、この不等式は分割投票も起こりにくくする。選挙タイムアウトは MTBF よりも数桁小さくする必要がある。リーダーがクラッシュした場合、システムは選挙タイムアウトとおよそ同じ時間で利用不能となる。我々はこの期間が全体の時間のほんのわずかな割合にとどめたいと考えている。

ブロードキャスト時間と MTBF は基盤となるシステムの特性だが、選挙タイムアウトはユーザが選択しなければならない。Raft の RPC は通常、受信者が情報を安定ストレージに永続化することを必要とするため、ブロードキャスト時間はストレージ技術に応じて 0.05~20 ミリ秒の範囲となる。結果として選挙タイムアウトは 10~500 ミリ秒の範囲になる可能性が高い。典型的なサーバの MTBF は数ヶ月以上でありタイミング要件を容易に満たす。第 9 章では選挙タイムアウトの設定方法と、それが可用性とリーダー選出の性能に与える影響についてより詳細に説明する。

3.10 リーダーシップ転送の拡張

3.10 リーダーシップ転送の拡張

このセクションでは、あるサーバが別のサーバにリーダーシップを転送できるようにする Raft のオプション拡張について記述する。リーダーシップ転送は次の 2 つの状況で役に立つ:

時々、リーダーは退任 (step down) しなければならない場合がある。例えばメンテナンスのために再起動する必要があるかもしれないし、クラスタから削除されるかもしれない (第 4 章参照)。リーダーが退任すると、クラスタは別のサーバがタイムアウトして選挙に勝利するまでの選挙タイムアウトの間アイドル状態となるだろう。この短期間の利用不能期間はリーダーが退任する前に自身のリーダーシップを別のサーバに転送することで回避できる。

場合によっては、1 つ以上のサーバが他のサーバよりもクラスタのリーダーとして適していることがある。例えば、高負荷のサーバは良いリーダーにはならないだろうし、WAN 環境ではクライアントとリーダー間の片方向ネットワーク遅延を最小限に抑えるためにプライマリデータセンター内のサーバが優先されるかもしれない。他のコンセンサスアルゴリズムでは、リーダー選出時にこれらの優先順位を考慮できるかもしれないが、Raft ではリーダーになるために十分に最新のログを持つサーバが必要であり、そのサーバが必ずしも最優先のサーバとは限らない。代わりに、Raft のリーダーは定期的に利用可能なフォロワーのいずれかがより適しているかを確認し、適任であればそのサーバに自身のリーダーシップを転送することができる (人間のリーダーもこのように優雅であれば良いのですが)。

Raft でリーダーシップを転送するには、先行リーダーは自身のログエントリをターゲットサーバに送信し、ターゲットサーバは選挙タイムアウトの経過を待たずに選挙を実行する。これにより、先行リーダーはターム開始時にターゲットサーバがすべてのコミットエントリを持っていることを保証する。通常の選挙と同様に、過半数投票は Safety 特性 (Leader Completeness 特性など) が維持されることを保証する。以下のステップはこのプロセスをより詳細に説明する:

先行リーダーは新しいクライアントリクエストの受け入れを停止する。

先行リーダーは、セクション 3.5 で説明した通常のログ複製メカニズムを使用して、ターゲットサーバのログを自身のログと一致するように完全に更新する。

先行リーダーはターゲットサーバに TimeoutNow リクエストを送信する。このリクエストはターゲットサーバの選挙タイマーの起動と同じ効果を持つ。つまり、ターゲットサーバは新しい選挙を開始する (自身のタームをインクリメントして候補者となる)。

ターゲットサーバが TimeoutNow リクエストを受信すると、他のどのサーバよりも早く選挙を開始し、次のタームでリーダーになる可能性が非常に高い。ターゲットサーバから先行リーダーへの次のメッセージにはその新しいターム番号が含まれ、以前のリーダーは退任する。この時点でリーダーシップ転送は完了である。

ターゲットサーバに障害が発生する可能性もある。この場合、クラスタはクライアント操作を再開する必要がある。もしリーダーシップ転送が選挙タイムアウトのおおむね 1 回分の時間経過後に完了しない場合、以前のリーダーは交替を中止し、クライアントリクエストの受け入れを再開する。もし以前のリーダーの判断が誤りでターゲットサーバが実際に稼働している場合でも、最悪の場合、この誤りによって余分な選挙が発生するだけであり、その後のクライアント操作は回復するだろう。

このアプローチは Raft クラスタの通常の遷移の範疇で動作することで Safety を維持する。例えば Raft はクロックが任意の速度で動作する場合でも Safety を保証している。ターゲットサーバが TimeoutNow リクエストを受信したとき、それはターゲットサーバのクロックが急速に前方へジャンプするのと同等であり、これは安全である。ただし、我々は現在、このリーダーシップ転送アプローチを実装も評価もしていない。

3.11 結論

3.11 結論

この章ではコンセンサスに基づくシステムにおけるすべての中核的な問題について説明した。Raft は単一決定 Paxos のように単一の値でコンセンサスに達するというものには留まらない。これは複製ステートマシンを構築するために必要な、増大するコマンドログに対する合意形成を行う。また、合意に達した時点で情報を伝播させるため、他のサーバがコミットされたログエントリを知ることができる。Raft はクラスタリーダーを選出して一方的に決定を下し、新しいリーダーが就任したら必要なログエントリのみを送信することで、実用的かつ効率的な方法でコンセンサスを達成する。我々は複製ステートマシンである LogCabin (第 10 章で説明) に Raft のアイディアを実装した。

Raft は完全なコンセンサス問題に対処するためにわずかなメカニズムしか持たない。例えば 2 つの RPC (RequestVote と AppendEntries) のみを使用する。意外かもしれないが、コンパクトなアルゴリズムや実装を開発することは Raft の明示的な目標ではなかった。むしろ、それは理解可能性のための我々の設計の結果であり、そこではあらゆるメカニズムが完全に動機付けられ、説明されなければならない。我々は冗長なメカニズムや回りくどいメカニズムは動機付けが難しく、そのため設計プロセスで自然に排除されることを発見した。

特定の解決策が Raft のデプロイメントの大部分に影響を与えると確信できない限り、我々はそれを Raft で扱わなかった。その結果、Raft の一部は素朴に見えるかもしれない。例えば Raft のサーバは選挙タイムアウトを持つことで分割投票を検出する。原理的には、各候補者に与えられた票数を数えることで分割投票をより早く検出し、さらには解決することも可能であろう。我々はこの最適化を Raft のために開発しないことを選択した。なぜならそれは複雑さを増すだけで実用的な利益はほとんどもたらさないであろう。適切に設定されたデプロイメントでは分割投票はまれである。Raft の他の部分は過度に保守的に見えるかもしれない。例えばリーダーは現在のタームでのエントリのみを直接コミットする。たとえ特別な状況で以前のタームでのエントリを安全にコミットできたとしてもである。より複雑なコミットルールを適用することは理解可能性を損なうだけで、性能に大きな影響を与えることはない。現在のルールではコミットが短時間遅延するだけである。Raft について他者と議論する中で、多くの人々がそのような最適化を考え、それを提案せずにはいられないことに気づいたが、目標が理解可能性である場合は、時期尚早な最適化 (premature optimizations) は省かれるべきである。

必然的に、この章では実用上で役に立つ機能や最適化の一部が省略されている可能性がある。実装者が Raft に関する経験を積むに連れて、特定の追加機能がいつ、なぜ有用であるかを理解し、実際のデプロイメント時にはそれらのいくつかを実装する必要が生じる可能性がある。この章全体を通じて、現時点では不要であると考えているが、必要に応じて実装者を導くのに役立つかもしれないいくつかのオプション拡張を概説した。理解可能性に焦点を当てることで、我々は実装者が自身の経験に応じて Raft を調整するための確固たる基盤を提供できたことを願う。Raft は我々のテスト環境で動作するため、これらは根本的な変更ではなく、単純な拡張になると考えている。

Chapter 4 - クラスタメンバーシップ変更

Chapter 4 - クラスタメンバーシップ変更

これまではクラスタ構成 (configuration) (コンセンサスアルゴリズムに参加するサーバのセット) は固定されていると想定してきた。実際には、サーバの故障時の交換や、レプリケーション度の変更のために構成を変更する必要が時々生じるだろう。これは以下の 2 つのアプローチのいずれかを用いて手動で行うことができる:

構成変更は、クラスタ全体をオフラインにし、構成ファイルを更新し、その後にクラスタを再起動することで行うことができる。ただし、この方法では切り替え中にクラスタは利用できなくなる。

あるいは、新しいサーバが既存のクラスタメンバーのネットワークアドレスを取得することで、そのサーバを置き換えることもできる。ただし、管理者は置き換えられたサーバが二度と稼働しないことを保証しなければならない。そうしないと、システムは Safety 特性を失うことになる (例えば余分な投票が発生するなど)。

これらのメンバーシップ変更アプローチはどちらも重大な欠点があり、手動による手順はオペレータのミスが発生するリスクがある。

これらの問題を回避するために、我々は構成変更を自動化して Raft コンセンサスアルゴリズムに組み込むことを決定した。Raft は変更中もクラスタが正常に動作し続けることを可能にし、メンバーシップ変更は基本的なコンセンサスアルゴリズムにいくつかの拡張を加えるだけで実装できる。Figure 4.1 はクラスタメンバーシップ変更で使用される RPC を要約している。各要素については本章の残りの部分で説明する。

管理者によってクラスタ構成にサーバを追加するために呼び出される。

| newServer | 構成に追加するサーバのアドレス |

|---|

| status | サーバ正常に追加された場合 OK |

|---|---|

| leaderHint | 既知の場合、最新のリーダーのアドレス |

管理者によってクラスタ構成からサーバを削除するために呼び出される。

| oldServer | 構成から削除するサーバのアドレス |

|---|

| status | サーバが正常に削除された場合 OK |

|---|---|

| leaderHint | 既知の場合、最新のリーダーのアドレス |

4.1 Safety

4.1 Safety

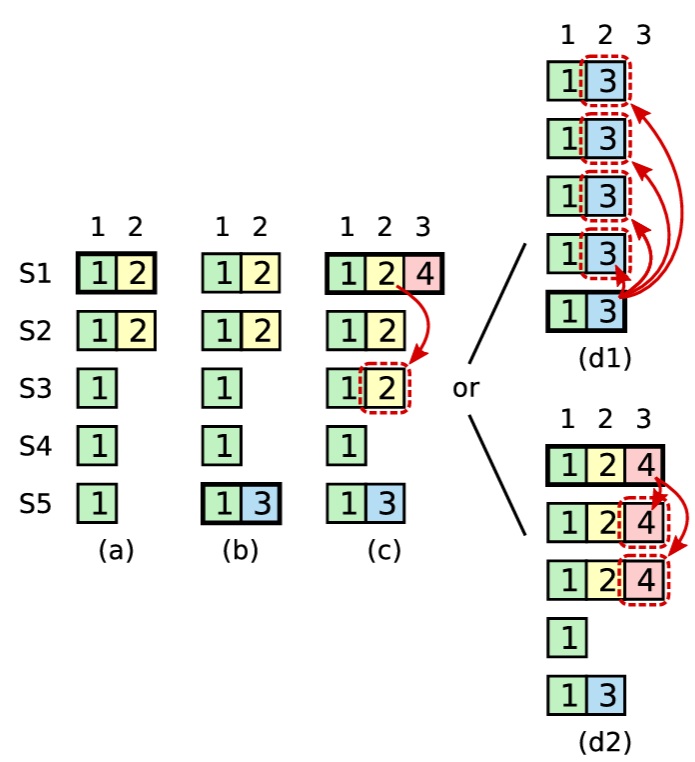

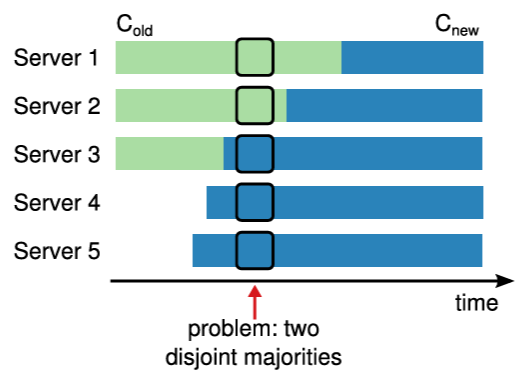

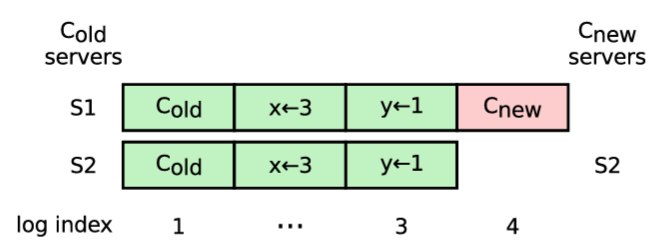

Safety の維持は構成変更における最初の課題である。メカニズムが安全であるためには、移行中に 2 つのリーダーが同じタームで選出される可能性があってはならない。1 回の構成変更で多数のサーバが追加または削除される場合、クラスタを古い構成から新しい構成に直接切り替えることは安全ではない。すべてのサーバを一度にアトミックに切り替えることは不可能であるため、移行中にクラスタが独立した 2 つの過半数に分裂する可能性がある (Figure 4.2 参照)。

ほとんどのメンバーシップ変更アルゴリズムは、このような問題に対処するために追加のメカニズムを導入している。我々は当初 Raft でもこれを行ったが、その後、互いに排他的な過半数をもたらす可能性のあるメンバーシップ変更を禁止するというより単純なアプローチを発見した。このため Raft は許可される変更の種類を制限する。つまり、一度にクラスタに追加または削除できるサーバは 1 台のみである。より複雑なメンバーシップ変更は、単一サーバ変更の連続として実装される。この章のほとんどは、我々の元々のアプローチよりも理解しやすい単一サーバアプローチについて記述する。完全性を保つため、セクション 4.3 では任意の構成変更を処理するために追加の複雑さを伴う元のアプローチについて説明する。LogCabin では、より単純な単一サーバ変更アプローチを発見する前だったため、より複雑なアプローチを実装し、本稿執筆時点でも依然としてより複雑なアプローチを使用している。

クラスタに単一サーバを追加する場合、またはクラスタから単一のサーバを削除する場合、古いクラスタの任意の過半数は新しいクラスタの任意の過半数と重なり合う (Figure 4.3 参照)。この重複はクラスタが独立した過半数に分割されることを防ぐ。セクション 3.6.3 の Safety 論証の観点で言えば「投票者」の存在が保証される。したがって、単一のサーバを追加または削除するだけであれば新しい構成に直接切り替えても安全である。Raft はこの特性を利用して、追加のメカニズムをほとんど必要とせずにクラスタのメンバーシップを安全に変更する。

クラスタ構成は複製ログ内の特殊なエントリを使用して保存し伝達される。これにより、Raft の既存のメカニズムを使用して構成情報を複製して永続化する。また、構成変更とクライアントリクエスト間に順序付けを強制することで、構成変更の進行中にクラスタがクライアントリクエストを処理し続けることも可能にする (両者をパイプラインまたはバッチで同時に複製することも可能)。

リーダーは現在の構成 (\(C_{\rm old}\)) から現在のサーバを追加または削除するリクエストを受信すると、新しい構成 (\(C_{\rm new}\)) をログエントリとして追加し、通常の Raft メカニズムを使用してそのエントリを複製する。新しい構成は、各サーバのログに保存されるとすぐに有効になる。\(C_{\rm new}\) エントリは \(C_{\rm new}\) のサーバに複製され、新しい構成の過半数が \(C_{\rm new}\) エントリのコミットを決定するために使用される。つまり、サーバは構成エントリがコミットされるのを待たずに、各サーバが常に自身のログに記録されている最新の構成を使用することを意味する。

\(C_{\rm new}\) エントリがコミットされると構成変更は完了する。この時点で、リーダーは \(C_{\rm new}\) の過半数のサーバが \(C_{\rm new}\) を採用したことを認識する。また、\(C_{\rm new}\) に移行していないサーバはクラスタの過半数を構成できなくなり、\(C_{\rm new}\) を持たないサーバはリーダーに選出されないことも認識する。\(C_{\rm new}\) のコミットにより以下の 3 つのことが継続できる:

リーダーは構成変更が正常に完了したことを確認できる。

構成変更によってサーバが削除された場合、そのサーバをシャットダウンできる。

さらなる構成変更を開始できる。この時点より前に構成変更が重複すると Figure 4.2 のような安全ではない状況に陥る可能性がある。

前述の通り、サーバは構成エントリがコミットされているかどうかにかかわらず、常にログ内の最新の構成を使用する。これにより、リーダーは以前の変更のエントリがコミットされるまで新しい変更の開始を待つことで構成変更の重複を容易に回避できる (上記の 3 番目の項目)。古いクラスタの過半数が \(C_{\rm new}\) のルールに基づいて動作するようになった後でなければ、別のメンバーシップ変更を開始するのは安全ではない。もしサーバが \(C_{\rm new}\) がコミットされたことを認識してから \(C_{\rm new}\) を採用すると、Raft リーダーは古いクラスタの過半数がいつ \(C_{\rm new}\) を採用したかを知るのが困難になるだろう。これは、リーダーがエントリのコミットをどのサーバが認識しているかを追跡する必要があり、サーバはそのコミットインデックスをディスクに永続化する必要がある。これらのメカニズムはどちらも Raft では必要ない。代わりに、各サーバはログに \(C_{\rm new}\) エントリが存在するとすぐに \(C_{\rm new}\) を採用し、リーダーは \(C_{\rm new}\) エントリがコミットされるとすぐにさらなる構成変更を許可しても安全であると認識する。残念ながら、この決定は (リーダーが変更された場合に) 構成変更のログエントリが削除される可能性があることを意味する。この場合、サーバはログ内の以前の構成にフォールバックする準備ができていなければならない。

Raft では投票とログ複製の両方で、コンセンサスに使用されるのは呼び出し元の構成である:

サーバは、自身の最新の構成に含まれていないリーダーからの AppendEntries リクエストを受け入れる。そうしない場合、新しいサーバをクラスタに追加することはできないだろう (サーバを追加する構成エントリより前のログエントリは受け入れない)。

また、サーバは自身の最新の構成に含まれていない候補者にも票を与える (候補者が十分に最新のログと現在のタームを持っている場合)。この投票はクラスタの可用性を維持するために必要となる場合が時々ある。例えば、3 台のサーバクラスタに 4 台目のサーバを追加することを考える。1 台のサーバに障害が発生した場合、過半数を形成しリーダーを選出するために新しいサーバの票が必要となるだろう。

したがって、サーバは自身の現在の構成を参照することなく、受信した RPC リクエストを処理する。

4.2 可用性

4.2 可用性

クラスタメンバーシップの変更は、クラスタの可用性を維持する上でいくつかの問題を引き起こす。セクション 4.2.1 では、新しいサーバがクラスタに追加される前にそれらを追いつかせ (catch up)、新しいログエントリのコミットを妨げないようにすることについて議論する。セクション 4.2.2 では、既存のリーダーがクラスタから削除された場合に、そのリーダーを段階的に停止する方法について説明する。セクション 4.2.3 では、削除されたサーバが新しいクラスタのリーダーを妨害することを防ぐ方法を記述する。最後に、セクション 4.2.4 では、結果としてられるメンバーシップ変更アルゴリズムがあらゆるメンバーシップ変更中に可用性を維持するのに十分であるという議論で締めくくる。

4.2.1 新しいサーバのキャッチアップ

4.2.1 新しいサーバのキャッチアップ

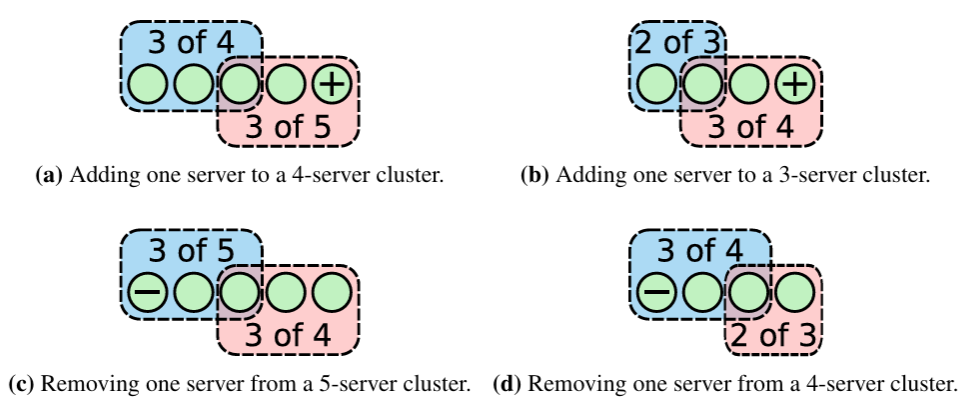

通常、サーバがクラスタに追加されるとき、ログエントリは何も保存していない。この状態でクラスタに追加されると、そのログがリーダーに追いつくまでにかなりの時間がかかり、この間、クラスタは可用性低下によってより脆弱になる。例えば 3 台で構成されるサーバクラスタは、通常、1 台の故障までであれば可用性を損なうことなく許容できる。しかし、ログが空の 4 台目のサーバが同じクラスタに追加され、元の 3 台のうち 1 台が故障した場合、クラスタは一時的に新しいエントリをコミットできなくなる (Figure 4.4(a) 参照)。また、多数の新しいサーバが立て続けにクラスタに追加され、それらの新しいサーバがクラスタの過半数を形成するために必要となる場合 (Figure 4.4(b) 参照) にも、可用性に関する別の問題が発生する可能性がある。どちらの場合も、新しいサーバのログがリーダーに追いつくまでクラスタは利用不能になるだろう。

可用性のギャップを避けるために、Raft は構成変更前に追加のフェーズを導入する。このフェーズでは、新しいサーバは非投票メンバーとしてクラスタに参加する。リーダーはログエントリをそのサーバに複製するが、それはまだ投票やコミットの目的での過半数にはカウントされない。新しいサーバがクラスタの他のサーバに追いつくと、上記のように再構成を進めることができる。(非投票サーバをサポートするメカニズムは他の文脈でも有用である。例えば、緩い一貫性で読み取り専用リクエストを処理できる多数のサーバに状態を複製するために使用できる。)

リーダーは構成変更を続行するために新しいサーバが十分に追いついたかを判断する必要がある。これには可用性を維持するためにいくつかの注意が必要である。もしサーバがあまりにも早く追加されると、前述のようにクラスタの可用性が危険にさらされる可能性がある。我々の目標は、一時的な利用不能期間を選挙タイムアウトより短く抑えることであった。なぜなら、クライアントは既にその規模の一時的な利用不能期間 (リーダー故障の場合など) を許容できる必要があるからである。さらに、可能であれば、新しいサーバのログをリーダーのログにさらに近づけることで、利用不能期間をさらに最小限に抑えたいと考えている。

リーダーはまた、新しいサーバが利用不能であるか、あるいは追いつくのがあまりにも遅すぎて決して追いつけないような場合には、変更を中止すべきである。このチェックは重要である。Lamport の古い Paxon 政府はこれを考慮しなかったために崩壊した。彼らは誤って溺死した船員のみでメンバーシップを構成するように変更してしまい、それ以上進捗できなくなったのである [48]。利用不能または低速のサーバを追加しようと試みることは多くの場合間違いである。実際、我々の最初の構成変更リクエストにはネットワークポート番号のタイプミスが含まれていたため、システムは正しく変更を中止してエラーを返した。

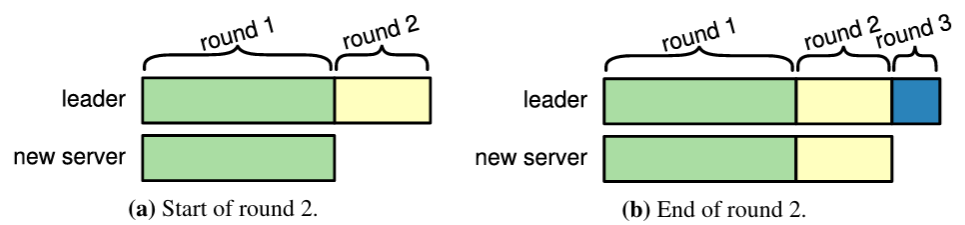

新しいサーバをクラスタに追加するのに十分な程度に追いついたと判断する以下のアルゴリズムを提案する。Figure 4.5 に示すように、新しいサーバへのエントリの複製はラウンドに分割される。各ラウンドでは、ラウンドの開始時点でリーダーのログに存在するすべてのログエントリが新しいサーバのログに複製される。ここで現在のラウンドのエントリを複製している間にリーダーに新しいエントリが到着する可能性があるが、これらは次のラウンドで複製される。進捗が進むにつれて、ラウンドの継続時間は短縮される。このアルゴリズムは、所定のラウンド数 (例えば 10 回) 待機する。もし最後のラウンドが選挙タイムアウトより短かった場合、リーダーは、実質的な可用性ギャップが生じるほど未複製エントリは残っていないという仮定のもと、新しいサーバをクラスタに追加する。そうでない場合、リーダーはエラーを返して構成変更を中止する。呼び出し元は常に再試行できる (新しいサーバのログは既に部分的に追いついているため、次回は成功する可能性が高くなる)。

新しいサーバが追いつくための最初のステップとして、リーダーは新しいサーバのログが空であることを発見しなければならない。新しいサーバの場合、AppendEntries の一貫性チェックはリーダーの nextIndex が最終的に 1 になるまで繰り返し失敗するだろう。この往復が、新しいサーバをクラスタに追加する性能を左右する要因となる可能性がある (このフェーズの後は、バッチ処理を使用することでログエントリをより少ない RPC でフォロワーに転送できる)。nextIndex をより早く正しい値に収束させるには、第 3 章で説明した方法を含め様々な方法がある。しかし、新しいサーバを追加するというこの特定の問題を解決する最も簡単なアプローチは、フォロワーが AppendEntries のレスポンスでログの長さを返すことである。これにより、リーダーはフォロワーの nextIndex を適切に制限できる。

4.2.2 現在のリーダーの削除

4.2.2 現在のリーダーの削除

現存のリーダーがクラスタから自身を削除するよう求められた場合、ある時点で退任する必要がある。一つの直接的なアプローチは第 3 章で説明したリーダーシップ転送の拡張を使用することである。自身を削除するよう求められたリーダーは、そのリーダーシップを別のサーバに転送し、その後そのサーバが通常通りメンバーシップ変更を実行する。

我々は当初、Raft のために異なるアプローチを開発した。それは、既存のリーダーが自身を削除するメンバーシップの変更を実行し、その後に退任するというものである。これにより、リーダーが一時的に自身がメンバーではない構成を管理する期間があり、Raft はややぎこちない動作モードになる。我々は当初、任意の構成変更 (セクション 4.3 参照) のためにこのアプローチが必要であった。そこでは、古い構成と新しい構成がリーダーシップを転送できる共通のサーバを全く持たない可能性があったからである。同じアプローチは、リーダーシップ転送を実装していないシステムでも実行可能である。

このアプローチでは、構成から削除されたリーダーは \(C_{\rm new}\) エントリがコミットされると退任する。もしリーダーがこの時点より前に退任した場合、再びタイムアウトしてリーダーとなり、進捗を遅らせる可能性がある。2 台のサーバクラスタからリーダーを削除するという極端なケースでは、クラスタの処理を進めるためにサーバが再びリーダーにならざるを得ないことさえある (Figure 4.6 参照)。このためリーダーは \(C_{\rm new}\) がコミットされるまで退任を待機する。これは、新しい構成が、退任したリーダーの参加なしに確実に動作できる最初の時点である。\(C_{\rm new}\) のメンバーは常に自分たちの中から新しいリーダーを選出することが可能となる。削除されたリーダーが退任した後、\(C_{\rm new}\) のサーバがタイムアウトして選挙に勝利するだろう。同様の可用性ギャップはリーダーが故障したときにも発生するため、この小さな可用性ギャップは許容できるはずである。

このアプローチは、意思決定に関して特に有害ではないものの、意外な結果をもたらす意味合いのある 2 つの影響をもたらす。一つ目は、リーダーが (\(C_{\rm new}\) をコミットしている間) 自身を含まないクラスタを管理できる機関が存在することになる。つまり、リーダーはログエントリを複製するが過半数には自身をカウントしない。二つ目は、自身の最新の構成の一部ではないサーバも \(C_{\rm new}\) エントリがコミットされるまで (Figure 4.6 のように) 必要とされる可能性があるため、新しい選挙を開始すべきであるということである。自身の最新構成に含まれていないサーバは選挙において自身の投票をカウントしない。

4.2.3 妨害的なサーバ

4.2.3 妨害的なサーバ

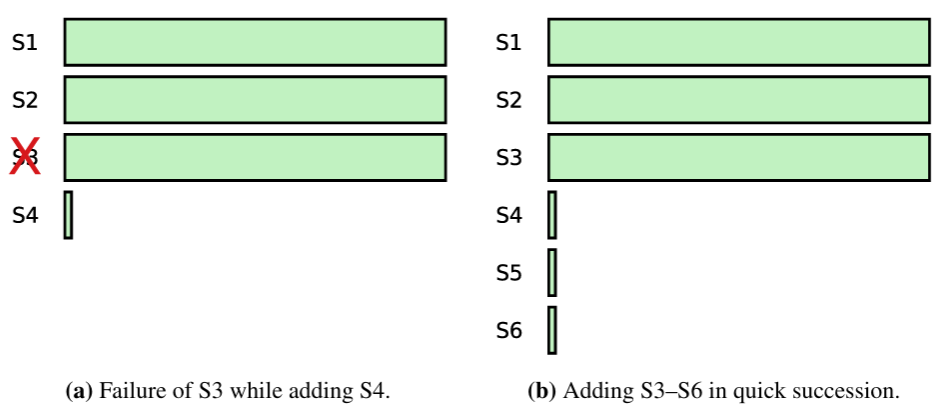

追加のメカニズムなしでは \(C_{\rm new}\) に含まれていないサーバがクラスタを妨害 (disrupt) する可能性がある。クラスタリーダーが \(C_{\rm new}\) エントリを作成すると、\(C_{\rm new}\) に含まれていないサーバはハートビートを受信しなくなるため、タイムアウトして新しい選挙を開始する。さらに、\(C_{\rm new}\) エントリを受信できずそのコミットも認識できないため、自身がクラスタから削除されたことを知ることはできない。このサーバは新しいターム番号を持つ RequestVote RPC を送信し、これによって現在のリーダーはフォロワー状態に戻される。最終的に \(C_{\rm new}\) の中から新しいリーダーが選出されるが、妨害的なサーバは再びタイムアウトし、このプロセスが繰り返されるため結果的に可用性が低下する。複数のサーバがクラスタから削除された場合、状況はさらに悪化する可能性がある。

妨害を排除するための我々の最初のアイディアは、サーバが選挙を開始する前に、それが全員の時間を無駄にしないか、つまり、選挙に勝つチャンスがあることを確認するというものであった。これにより選挙に Pre-Vote フェーズと呼ばれる新しいフェーズが導入された。候補者はまず他のサーバに、自身のログが投票するのに十分なほど最新であるかを尋ねる。候補者がクラスタの過半数から投票を得られると判断した場合のみ、自身のタームをインクリメントして通常の選挙を開始する。

残念ながら、Pre-Vote フェーズは妨害的なサーバの問題を解決することはできない。妨害的なサーバのログが十分に最新であるにもかかわらず、選挙を開始すると依然として妨害的になる状況がある。おそらく驚くべきことだが、このような状況は構成変更が完了する前でさえ発生し得る。例えば Figure 4.7 はクラスタから削除されるサーバを示している。リーダーが \(C_{\rm new}\) ログエントリを作成すると、削除されるサーバが妨害的になる可能性がある。この場合、削除されるサーバはどちらのクラスタの過半数よりも最新のログを持っているため、Pre-Vote チェックは役に立たない。(ただし、Pre-Vote フェーズは妨害的なサーバの問題を解決しないもの、一般的にリーダー選出の堅牢性を向上させるのに有用なアイディアであることが判明した。第 9 章参照。)

このシナリオのため、我々は現在、ログの比較のみに基づく解決策 (Pre-Vote チェックなど) では、選挙が妨害的になるかどうかを判断するのに十分ではないと考えている。Raft は常に障害を許容できなければならないため、サーバが選挙を開始する前に \(C_{\rm new}\) のすべてのサーバのログをチェックすることを要求することはできない。また、リーダーが Figure 4.7 に示すシナリオを迅速に乗り越えるのに十分な速さでエントリを確実に複製することを仮定したくなかった。これは実際には機能するかもしれないが、ログの分岐箇所を見つけるパフォーマンスやログエントリを複製するパフォーマンスに関して、我々が避けたいより強い仮定に依存している。

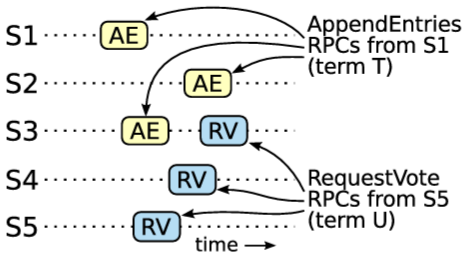

Raft の解決策は、有効なリーダーが存在するかどうかを判断するためにハートビートを使用する。Raft では、リーダーはフォロワーへのハートビートを維持できる場合にアクティブであると見なされる (そうでない場合は別のサーバが選挙を開始する)。したがって、クラスタがハートビートを受信しているリーダーをサーバが妨害できるべきではない。我々はこの目的を達成するために RequestVote RPC を変更する。サーバが現在のリーダーからの通信を受けてから最小選挙タイムアウト以内に RequestVote リクエストを受信した場合、自身のタームを更新したり、票を与えたりしない。サーバはリクエストを破棄するか、投票拒否で応答するか、リクエストを遅延させるかを選択できる。結果は基本的に同じである。これは通常の選挙には影響しない。通常の選挙では、各サーバは選挙を開始する前に少なくとも最低限の選挙タイムアウトを待機する。しかし、\(C_{\rm new}\) に参加していないサーバによる中断を回避するのに役立つ。リーダーは自身のクラスタにハートビートを届けられる限り、より大きなターム番号によって退任させられることはない。

この変更は第 3 章で説明したリーダーシップ転送メカニズムと衝突する。リーダーシップ転送メカニズムでは、サーバは選挙タイムアウトを待たずに正当に選挙を開始する。その場合、他のサーバは現在のクラスタリーダーが存在すると認識していても RequestVote メッセージを処理すべきである。これらの RequestVote リクエストにはこの動作を示す特別なフラグ (「リーダーを中断する許可を得た ── リーダーがそう指示した!」) を含めることができる。

4.2.4 可用性の議論

4.2.4 可用性の議論

このセクションでは、上記の解決策がメンバーシップ変更時の可用性維持に十分であることを議論する。Raft のメンバーシップ変更はリーダーベースであるため、このアルゴリズムはメンバーシップ変更中にリーダーを維持し、交代させることができ、またリーダーはクライアントの要求に応答し、かつ構成変更を完了させられることを示す。とりわけ我々は、古い構成の過半数が利用可能であること (少なくとも \(C_{\rm new}\) がコミットされるまで)、および新しい構成の過半数が利用可能であることを前提とする。

リーダーは構成変更のすべてのステップで選出されうる。

新しいクラスタ内で最新のログを持つ利用可能なサーバが \(C_{\rm new}\) エントリを持っている場合、そのサーバは \(C_{\rm new}\) の過半数から票を集めてリーダーになることができる。

そうでない場合、\(C_{\rm new}\) エントリはまだコミットされていないはずである。新旧両方のクラスタの中で最も最新のログを持つ利用可能なサーバは、\(C_{\rm old}\) の過半数と \(C_{\rm new}\) の過半数から票を集めることができるため、どの構成を利用していてもリーダーになることができる。

リーダーは一度選出されると、ハートビートが構成に届く限り維持される。ただし、\(C_{\rm new}\) に含まれていないが \(C_{\rm new}\) をコミットしてから意図的に退任する場合を除く。

リーダーが、自身の構成に確実にハートビートを送信できる場合、リーダーもそのフォロワーもより高いタームを採用することはない。彼らは新しい選挙を開始するためにタイムアウトすることはなく、他のサーバからのより高いタームを持つ RequestVote メッセージを無視する。したがって、リーダーは強制的に退任されることはない。

\(C_{\rm new}\) に含まれていないサーバが \(C_{\rm new}\) エントリをコミットして退任した場合、Raft は新しいリーダーを選出する。この新しいリーダーは \(C_{\rm new}\) の一部である可能性が高いため、構成変更が完了するだろう。ただし、退任したサーバが再びリーダーになるリスクも (わずかに) ある。もし再び選出された場合、そのサーバは \(C_{\rm new}\) エントリのコミットを確認し、すぐに退任するため、次回は \(C_{\rm new}\) のサーバが成句する可能性が高いだろう。

リーダーは構成変更全体を通してクライアントリクエストを処理する。

リーダーは変更全体を通してクライアントリクエストをログに追加し続けることができる。

新しいリーダーはクラスタに追加される前に追いつく必要があるため、リーダーはコミットインデックスを進めてクライアントにタイムリーに応答できる。

リーダーは \(C_{\rm new}\) をコミットすることで構成変更を進めて完了させる。必要に応じて、\(C_{\rm new}\) のサーバがリーダーになることを可能にするために退任する。

したがって、上記の仮定の下では、このセクションで述べられているメカニズムはあらゆるメンバーシップ変更中の可用性を維持するのに十分である。

4.3 ジョイントコンセンサスを用いた任意の構成変更

4.3 ジョイントコンセンサスを用いた任意の構成変更

このセクションではクラスタメンバーシップの変更に対するより複雑なアプローチを紹介する。これは構成に関する任意の変更を一度に処理する、例えば、2 台のサーバを一度にクラスタに追加したり、5 台のサーバクラスタ内のすべてのサーバを一度に置き換えたりすることが可能である。これは我々が考案したメンバーシップ変更の最初のアプローチであり、ここでは完全性のためにのみ説明する。より単純な単一サーバアプローチを知った今となっては、任意の変更を扱うには余分な複雑さが必要となるため、代わりにそちらを推奨する。文献では、メンバーシップ変更は一般的に任意の変更によって行われると想定されているが、実際のシステムでは単一サーバの変更を繰り返すことでクラスタメンバーシップを任意の構成に変更できるため、この柔軟性は必要ないと考えている。

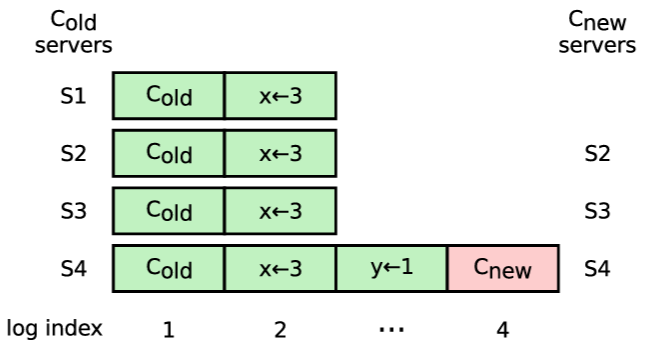

任意の構成変更について Safety を確保するために、クラスタはまず我々がジョイントコンセンサス (joint consensus) と呼ぶ過渡的な構成に切り替わる。ジョイントコンセンサスがコミットされるとシステムは新しい構成に移行する。ジョイントコンセンサスは古い構成と新しい構成の両方を組み合わせたものである。

ログエントリは両方の構成のすべてのサーバに複製される。

どちらの構成のサーバでもリーダーになることができる。

(選挙およびエントリのコミットに関する) 合意には、古い構成と新しい構成の両方からの個別の過半数が必要である。例えば、3 台のサーバからなるクラスタから 9 台のサーバからなる別のクラスタに変更する場合、合意には古い構成の 3 台のサーバのうちの 2 台と、新しい構成の 9 台のサーバのうちの 5 台の両方が必要である。

ジョイントコンセンサスにより、個々のサーバは Safety を損なうことなく、異なるタイミングで構成間を移行できる。さらに、ジョイントコンセンサスにより、クラスタは構成変更中もクライアントからのリクエストに引き続き対応できる。

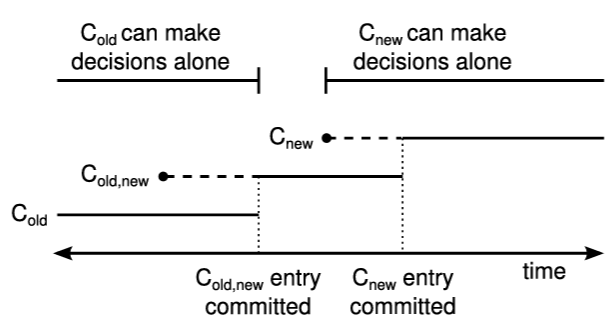

このアプローチは、単一サーバのメンバーシップ変更アルゴリズムを、ジョイント構成の中間ログエントリによって拡張する。Figure 4.8 にそのプロセスを示している。リーダーが \(C_{\rm old}\) から \(C_{\rm new}\) への構成変更リクエストを受信すると、ジョイントコンセンサス用の構成 (図中の \(C_{\rm old,new}\)) をログエントリとして保存し、通常の Raft メカニズムを使用してそのエントリを複製する。単一サーバ構成変更アルゴリズムと同様に、各サーバはログに構成を保存するとすぐに新しい構成の使用を開始する。これは、リーダーが \(C_{\rm old,new}\) のログがいつコミットされるかを判断するために \(C_{\rm old,new}\) のルールを使用することを意味する。リーダーがクラッシュした場合、\(C_{\rm old,new}\) を受信した候補が勝利したかどうかに応じて、\(C_{\rm old}\) または \(C_{\rm old,new}\) のいずれかの元で新しいリーダーが選出される可能性がある。いずれにせよ、この期間中は \(C_{\rm new}\) が一方的な決定を下すことはできない。

一度 \(C_{\rm old,new}\) がコミットされると、\(C_{\rm old}\) も \(C_{\rm new}\) も他方の承認なしに決定を下すことはできなくなる。また Leader Completeness 特性により \(C_{\rm old,new}\) ログエントリを持つサーバのみがリーダーとして選出されることが保証される。ここでリーダーが \(C_{\rm new}\) を記述するログエントリを作成して安全にクラスタに複製することができる。繰り返しになるが、この構成は各サーバで観測されるとすぐに有効になる。\(C_{\rm new}\) ログエントリが \(C_{\rm new}\) のルールに基づいてコミットされると、古い構成は無関係になり、新しい構成に含まれないサーバはシャットダウンできる。Figure 4.8 に示すように \(C_{\rm old}\) と \(C_{\rm new}\) の両方が一方的な決定を下す時間は存在せず、これにより Safety が保証される。

ジョイントコンセンサスは、以前の構成変更がまだ進行中であっても構成変更を開始できるように一般化できる。しかし、これを行うことで得られる実用的な利点はあまりないだろう。代わりに、リーダーは構成変更が既に進行中の場合 (その最新の構成がコミットされていないか、または単純な過半数ではない場合)、追加の構成変更を拒否する。このように拒否された変更は、単に待機して後で再試行できる。

このジョイントコンセンサスアプローチは中間構成への移行とそこからの移行が必要となるため単一サーバ変更よりも複雑である。ジョイント構成はまたすべての投票およびコミットメントの決定方法に変更を必要とする。リーダーは単にサーバを数えるだけではなく、サーバが古いクラスタの過半数を形成し、かつ新しいクラスタの過半数を形成するかどうかをチェックしなければならない。これを実装するには、我々の Raft 実装 [86] において約 6 箇所の比較を見つけて変更する必要があった。

4.4 システム統合

4.4 システム統合

Raft の実装は、本章で述べたクラスタメンバーシップ変更メカニズムを異なる方法で公開する場合がある。例えば Figure 4.1 の AddServer および RemoveServer RPC は、管理者によって直接呼び出されることもあれば、一連の単一サーバステップを使用して任意の方法で構成を変更するスクリプトによって呼び出されることもある。

サーバ障害のようなイベントに応じてメンバーシップ変更を自動的に呼び出すことが望ましい場合もあるだろう。ただし、これは合理的なポリシーに従ってのみ行うべきである。例えば、故障したサーバをクラスタが自動的に削除することが危険な場合がある。その結果として、意図された耐久性および障害耐性要件を満たすのに十分なレプリカ数が不足してしまう可能性がある。妥当なアプローチの一つは、システム管理者が希望するクラスタサイズを設定し、その制約内で故障したサーバを利用可能なサーバで自動的に置き換えるようにすることである。

複数の単一サーバステップを必要とするクラスタメンバーシップ変更を行う場合は、サーバを削除する前にサーバを追加することが望ましい。例えば 3 台のサーバで構成されるクラスタでサーバを交換する場合、まず 1 台のサーバを追加し、次に別のサーバを削除することで、プロセス全体を通して常に 1 台のサーバの故障をシステムが処理できる。しかし、もし 1 台のサーバを削除してからもう 1 台のサーバを追加した場合、システムは一時的にいかなる故障も隠蔽できなくなるだろう (2 台のサーバで構成されるクラスタでは両方のサーバが両可能である必要があるため)。

メンバーシップ変更はクラスタのブートストラップに異なるアプローチを必要とする。動的なメンバーシップがない場合、各サーバは構成をリストした静的ファイルを持つことになる。動的なメンバーシップ変更の場合、システムは Raft ログで構成を管理するため、静的な構成ファイルはもはや必要ない。また、静的構成ファイルは潜在的にエラーが発生しやすい可能性がある (例えば新しいサーバはどの構成で初期化されるべきか? など)。代わりに、クラスタを初めて作成する際には、1 台のサーバのログの最初のエントリとして構成エントリで初期化することを推奨する。この初期構成にはその 1 台のみがリストされており、それ単独で過半数を形成するため、この構成をコミット済みと見なすことができる。それ以降、他のサーバは空のログで初期化され、クラスタに追加され、メンバーシップ変更メカニズムを通じて現在の構成を知る。

メンバーシップ変更はまた、クライアントがクラスタを見つけるための動的なアプローチも必要とする。これについては第 6 章で議論する。

4.5 結論

4.5 結論

本章ではクラスタメンバーシップ変更を自動的に処理するための Raft の拡張機能について記述した。障害耐性要件は時間の経過と共に変化し、故障したサーバはいずれ交換する必要があるため、これは完全なコンセンサスベースのシステムの重要な部分である。

新しい構成は「過半数」の意味に影響を与えるため、コンセンサスアルゴリズムは構成変更全体にわたる Safety を維持するために根本的に関与する必要がある。本章では、一度に 1 台のサーバを追加または削除する単純なアプローチを提示した。これらの操作は、変更中に少なくとも 1 台のサーバが任意の過半数と重なり合うため Safety を単純に維持する。複数の単一サーバ変更を組み合わせることでクラスタを大幅に更新できる。Raft ではメンバーシップ変更中にクラスタが正常に動作し続けることを可能にする。

構成変更中に可用性を維持するにはいくつかの重要な問題に対処する必要がある。特に、新しい構成に含まれていないサーバが有効なクラスタリーダーを妨害するという問題は驚くほど微妙であった。ログの比較に基づくいくつかの不十分な解決策に苦労した後、ハートビートに基づく実用的なソリューションに落ち着いた。

Chapter 5 - ログ圧縮

Chapter 5 - ログ圧縮

Raft のログは、通常運用中に取り込んだクライアントリクエストが増えるにつれて増大する。ログが大きくなるとより多くのスペースを占有し、リプレイに時間がかかるようになる。ログを圧縮する方法がなければ、サーバはスペースを使い果たすか、起動時に時間がかかりすぎるかで、最終的には可用性の問題を引き起こすだろう。そのため、実用的なシステムでは何らかのログ圧縮が必要である。

ログ圧縮の一般的な考え方は、ログ内の情報の多くが時間の経過と共に陳腐化し、破棄できるというものである。例えば \(x\) を 2 に設定する操作は、その後の操作で \(x\) を 3 に設定すると陳腐化する。ログエントリがコミットされてステートマシンに適用されると、現在の状態に到達するために使用された中間状態や操作はもはや必要なくなり、圧縮によって削除できる。

Raft のコアアルゴリズムやメンバーシップの変更とは異なり、ログ圧縮に関してはシステムごとに異なるニーズがある。いくつかの理由からログ圧縮には万能な解決策はない。第一に、システムごとに単純性と性能のトレードオフの程度が異なる。第二に、ステートマシンはログ圧縮に密接に関与する必要があり、ステートマシンは、そのサイズや、ディスクベースか揮発性メモリベースかによって大きく異なる。

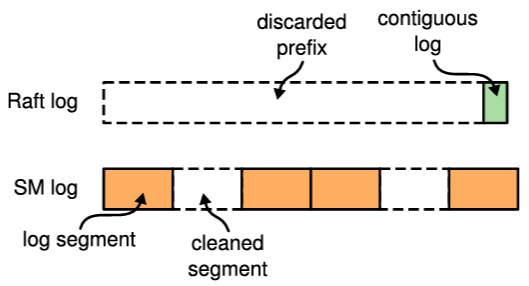

本章の目的はログ圧縮に関する様々なアプローチを議論することである。いずれのアプローチにおいても、ログ圧縮の責務のほとんどはステートマシンにあり、ステートマシンが状態をディスクに書き込み、状態を圧縮する役割を担う。ステートマシンはこれを様々な方法で実現でき、それは本章全体を通して説明され Figure 5.1 にまとめられている。

メモリベースのステートマシンにおけるスナップショットは概念的に最も単純なアプローチである。スナップショットでは、現在のシステム状態全体が安定したストレージ上のスナップショット (snapshot) に書き込まれ、その時点までのログ全体が破棄される。スナップショットは Chubby [11, 15] や ZooKeeper [38] で使用されており、我々は LogCabin でも実装した。スナップショットは本章で最も詳細に説明されているアプローチでありセクション 5.1 で詳しく説明している。

ディスクベースのステートマシンでは、システム状態の最新のコピーが通常動作の一環としてディスク上に保持される。そのためステートマシンがディスクへの書き込みを反映するとすぐに Raft ログは破棄でき、スナップショットは一貫性のあるディスクイメージを他のサーバに送信する場合にのみ使用される (セクション 5.2)。

ログクリーニングやログ構造マージツリー (log-structured merge tree) のような、ログ圧縮に対する増分アプローチについてはセクション 5.3 で説明する。これらのアプローチはディスクへの書き込みを効率的に行い、時間の経過と共にリソースを均等に利用する。

最後に、セクション 5.4 では、スナップショットを直接ログに保存することで必要なメカニズムを最小限に抑えるログ圧縮のアプローチについて説明する。実装は容易であるが、このアプローチは非常に小規模なステートマシンにのみ適している。

現在、LogCabin はメモリベースのスナップショットアプローチのみを実装している (メモリベースのステートマシンを組み込んでいるため)。

これらの様々な圧縮アプローチにはいくつかの共通するコアコンセプトがある。第一に、圧縮の決定をリーダーに集中させるのではなく、各サーバがログのコミット済みプレフィクスを独立して圧縮する。これにより、既にログにデータを持つフォロワーにリーダーはデータを送信する必要がなくなる。またモジュール性も向上する。ログ圧縮の複雑性のほとんどはステートマシン内に収まっており、Raft 自体とはあまりやりとりをしない。これはシステム全体の複雑さを最小限に抑えるのに役立つ。Raft の複雑さはログ圧縮の複雑さと「乗算」されるのではなく「加算」される。圧縮の責任をリーダーに集中させる代替アプローチについてはセクション 5.4 で詳しく説明する (そして非常に小さなステートマシンにとっては、リーダーベースのアプローチの方が優れている場合がある)。

第二に、ステートマシンと Raft の間の基本的な相互作用は、ログのプレフィクスに対する責任を Raft からステートマシンに委譲することを含んでいる。エントリを適用した後、遅かれ早かれステートマシンは現在のシステム状態を回復できる方法でそれらのエントリをディスクに反映する。それが完了すると、ステートマシンは Raft に対して対応するログプレフィクスを破棄するように指示する。Raft がロブプレフィクスに対する責任を放棄する前に、ログプレフィクスを記述する自身の状態の一部を保存しなければならない。具体的には、Raft は破棄した最後のエントリのインデックスとタームを保持する。これにより、ログの残りの部分がステートマシンの状態の後に固定され、AppendEntries の一貫性チェックが機能し続けることを可能にする (ログの最初のエントリに先行するエントリのインデックスとタームが必要である)。Raft はまたクラスタメンバーシップ変更をサポートするために、破棄されたログプレフィクスから最新の構成も保持する。

第三に、Raft がログのプレフィクスを破棄するとステートマシンは 2 つの新たな役割を担うことになる。サーバが再起動したとき、ステートマシンは Raft のログからエントリを適用する前に、破棄されたログエントリに対応する状態をディスクからロードする必要がある。さらに、ステートマシンは遅いフォロワー (リーダーのログより大幅に遅れているフォロワー) に送信できるように、一貫性のある状態イメージを生成する必要があるかもしれない。少数の遅いフォロワーがクラスタの完全な可用性を妨げてはならず、またクラスタはいつでも新しいサーバが追加される可能性があるため、ログエントリがクラスタ内のすべてのメンバーに「完全に複製」されるまで圧縮を遅らせることは現実的ではない。したがって、遅いフォロワーや新しいサーバは、時折、ネットワーク経由で初期状態を受信する必要があるだろう。この場合、ステートマシンは一貫性のある状態イメージを提供し、リーダーはそれをフォロワーに送信する必要がある。

インメモリデータ構造を変更

インメモリデータ構造で結果を検索

ログサイズが以前のスナップショットサイズの 4 倍に達した場合:

- ステートマシンのメモリをフォーク

- 親プロセスはリクエスト処理を継続

- 子プロセスはインメモリデータ構造をディスク上の新しいスナップショットファイルにシリアライズ

- 以前のスナップショットファイルをディスク上から破棄

- 子プロセスの最終適用インデックスまで Raft ログを破棄

最新のスナップショットファイル (不変)

- インメモリのヘッドセグメントにエントリを追記

- キーの場所でインデックスを更新

- インデックスでキーの場所を検索

- インデックス上のセグメントから値を読み取り

インメモリのヘッドセグメントが 2MB に達した場合:

- インメモリセグメントを新しいヘッドセグメントとしてディスクに書き込み

- インメモリセグメントをリセット

- 最後に適用したインデックスまでの Raft ログを破棄

空きスペースが 5% を下回った場合:

- 以下の値が最大となる 10 個のセグメントを選択してクリーンアップ: \[ \frac{benefit}{cost} = \frac{1-u}{1+u}\times segmentAge \] ここで \(u\) はセグメント内のライブバイトの割合

- ライブエントリを新しいセグメントにコピー

- エントリがライブかどうかを判断するためにインデックスのキーで検索

- キーの新しい場所でインデックスを更新

- 元のセグメントを破棄

ディスク上のすべてのセグメント (不変)

ログエントリを破棄する前に保持される。また、状態を転送する際にリーダーから遅いフォロワーに送信される。

| prevIndex | 最後に破棄されたエントリのインデックス (初回起動時に 0 に初期化) |

|---|---|

| prevTerm | 最後に破棄されたエントリのターム (初回起動時に 0 に初期化) |

| prevConfig | prevIndex までの最新のクラスタメンバーシップ構成 |

- ディスク上のデータ構造を更新

- 最後に適用されたインデックスまでの Raft ログを破棄

ディスク上のデータ構造で結果を検索

ディスク上のデータ構造のコピーオンライトスナップショット

インメモリツリーにエントリを追加

- インメモリツリーでキーを検索

- すべてのレベル 0 ランを検索 (いずれもキーを含む可能性)

- 1 から順にカウントアップする各レベルについて、キーを含む可能性のある単一のランを検索

インメモリツリーが 1MB に達した場合:

- インメモリツリーをディスク上の新しいソートされたレベル 0 ランに直列化

- インメモリツリーをリセット

- 最後に適用したインデックスまで Raft ログを破棄

レベル 0 に 4 つのランがある場合:

- すべてのレベル 0 ランをすべてのレベル 1 ランにマージし、2MB 境界で分割された新しい重複しないレベル 1 ランを生成

- マージされたランを破棄

レベル \(L\) のすべてのランの合計サイズが \(10^L\) MB を超えた場合:

- 1 つのレベル \(L\) ラン (ラウンドロビンで選択) を、重複するすべてのレベル \(L+1\) ランとマージし、2MB 境界で分割された新しい重複しない \(L+1\) ランを生成

- マージされたランを破棄

ディスク上のすべてのラン (イミュータブル)

インメモリデータ構造を変更

インメモリデータ構造で結果を検索

Raft ログがバイト単位で 1MB に達した場合:

- クライアントリクエストの受け入れを停止

- 最後に適用したインデックスがログの末尾に達するまで待機

- データ構造を直列化し、新しいスナップショットエントリをログに追記

- クライアントリクエストの処理を再開

- 各サーバのスナップショットエントリがコミットされたことを確認すると、そのエントリまでの Raft ログエントリを破棄

Raft ログ (追加の情報なし)

5.1 メモリベースのステートマシンのスナップショット

5.1 メモリベースのステートマシンのスナップショット

スナップショットの最初のアプローチは、ステートマシンのデータ構造がメモリ内に保持されている場合に適用される。これは、数ギガバイトまたは数十ギガバイトのデータセットを持つステートマシンにとって妥当な選択である。データはディスクから読み取る必要がないため操作は迅速に完了できる。また、豊富なデータ構造を利用でき、すべての操作を (I/O によるブロックなしで) 完了まで実行できるため、プログラミングも容易である。

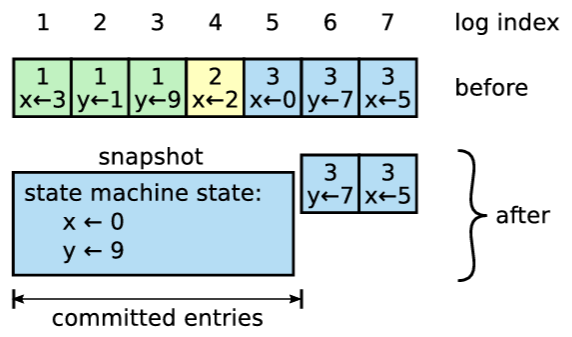

Figure 5.2 はステートマシンがメモリ内に保持されている場合の Raft におけるスナップショットの基本的な考え方を示している。各サーバは独立してスナップショットを作成し、そのログ内のコミット済みエントリのみをカバーする。スナップショットの作業のほとんどはステートマシンの現在の状態を直列化することであり、これは特定のステートマシン実装に固有のものである。例えば LogCabin のステートマシンはツリーを主要なデータ構造としており、このツリーを先行順深さ優先探索 (pre-order depth-first traversal) を使用して直列化される (これにより、スナップショットを適用すると親ノードが子ノードより先に作成される)。ステートマシンはまた、クライアントへの線形化可能性を提供するために保持する情報も直列化する必要がある (第 6 章参照)。

ステートマシンがスナップショットの書き込みを完了するとログを切り詰めることができる。Raft はまず再起動のために必要な状態、すなわち、スナップショットに含まれる最後のエントリのインデックスとターム、およびそのインデックス時点での最新の構成を保存する。その後、そのインデックスまでのログのプレフィクスを破棄する。以前のスナップショットも不要になるため破棄することができる。

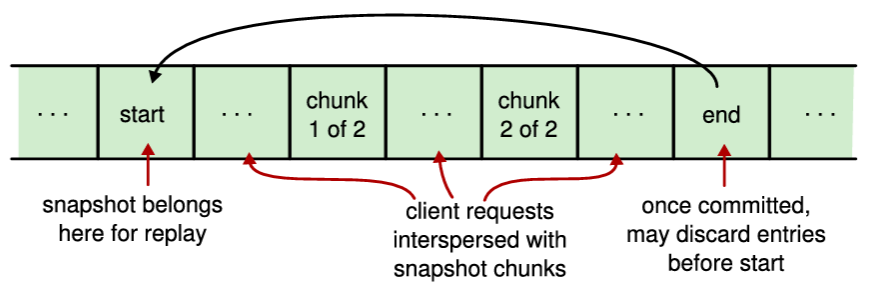

前述のように、リーダーはときどき自身の状態を、遅いフォロワーや、クラスタに参加する新しいサーバに送信する必要があるかもしれない。スナップショット作成においてこの状態は最新のスナップショットであり、リーダーはこれを Figure 5.3 に示すように InstallSnapshot と呼ばれる新しい RPC を使用して転送する。フォロワーはこの RPC でスナップショットを受信すると、既存のログエントリをどのように処理するかを決めなければならない。通常、スナップショットにはフォロワーのログにまだ含まれていない新しい情報が含まれているだろう。この場合は、フォロワーはログ全体を破棄する。スナップショットと衝突する未コミットのエントリが含まれている可能性もあるため、これはすべてスナップショットによって置き換えられる。もし、代わりにフォロワーが (再送信または誤りによって) 自身のログのプレフィクスを記述するスナップショットを受信した場合、スナップショットによってカバーされているログエントリは削除されるが、スナップショットに続くエントリは依然として有効であるため保持する必要がある。

リーダーによってフォロワーにスナップショットのチャンクを送信するために呼び出される。リーダーは常にチャンクを順番通りに送信する。

| term | リーダーのターム |

|---|---|

| leaderId | フォロワーがクライアントをリダイレクトできるようにするため |

| lastIndex | スナップショットがこのインデックスまでのすべてのエントリを置き換える (このインデックスを含む) |

| lastTerm | lastIndex のターム |

| lastConfig | lastIndex 時点での最新のクラスタ構成 (最初のチャンクでのみ送信) |

| offset | スナップショットファイル内でのチャンクが配置されるバイトオフセット |

| data[] | オフセットから始まるスナップショットチャンクの生バイト列 |

| done | これが最後のチャンクの場合 true |

| term | リーダーが自身を更新するための currentTerm |

|---|

- term < currentTerm の場合、直ちに返信

- 最初のチャンク (offset が 0) の場合、新しいスナップショットファイルを作成

- 指定されたオフセットでスナップショットファイルにデータを書き込む

- done が false の場合、返信してさらなるデータチャンクを待機

- lastIndex が最新のスナップショットのインデックスより大きい場合、スナップショットファイルと Raft の状態 (lastIndex, lastTerm, lastConfig) を保存。既存の、または不完全なスナップショットは破棄。

- 既存のログエントリが lastIndex および lastTerm と同じインデックスおよびタームを持つ場合、lastIndex までのログを破棄し (ただし後続のエントリは保持)、返信

- ログ全体を破棄

- スナップショットの内容を使用してステートマシンをリセット (そして lastConfig をクラスタ構成としてロード)

本セクションの残りの部分では、メモリベースのステートマシンのスナップショットに関する二次的な問題について議論する:

セクション 5.1.1 では、スナップショットのクライアントへの影響を最小限に抑えるため、通常の操作と並行してスナップショットを生成する方法について議論する。

セクション 5.1.2 では、スペース使用量とスナップショットのオーバーヘッドのバランスを取りながら、いつスナップショットを作成するかについて議論する。

セクション 5.1.3 では、スナップショットの実装で発生する問題について議論する。

5.1.1 スナップショットの並行性

5.1.1 スナップショットの並行性

スナップショットの作成には、状態の直列化とディスクへの書き込みの両方で長い時間がかかることがある。例えば今日のサーバでは 10GB のメモリをコピーするのに約 1 秒かかり、それを直列化するには通常さらに時間がかかる。ソリッドステートディスクでさえ 1 秒あたり約 500MB しか書き込めない。したがって、可用性ギャップを回避するためにスナップショットの直列化と書き込みの両方を通常の操作と並行して行う必要がある。

幸いなことに、コピーオンライト (copy-on-write) 技術により書き込み中のスナップショットに影響を与えることなく新しい更新を適用できる。これには 2 つのアプローチがある:

ステートマシンは、これをサポートするために不変 (関数型) データ構造で構築することもできる。ステートマシンのコマンドが状態をその場で更新しないため、スナップショットタスクは以前の状態への参照を保持し、それを一貫してスナップショットに書き込むことができる。

あるいはオペレーティングシステムのコピーオンライトのサポートを利用することもできる (プログラミング環境がこれを許容する場合)。例えば Linux では、インメモリのステートマシンは fork を使用してサーバのアドレス空間全体をコピーできる。その後、子プロセスはステートマシンの状態を書き出して終了し、その間も親プロセスはリクエストの処理を継続する。LogCabin の実装は現在このアプローチを使用している。

サーバはスナップショットを並行して実行するために追加のメモリを必要とする。これは計画的に管理されている必要がある。ステートマシンはスナップショットファイルへのストリーミングインターフェースを持つことが不可欠である。これにより、スナップショットの作成時にスナップショット全体をメモリに一時的に保持する必要がなくなる。それでも、コピーオンライトは、スナップショット処理中にステートマシンの状態が変更される割合に比例して追加のメモリを必要とする。さらに、オペレーティングシステムによるコピーオンライトに依存すると、偽共有 (false sharing) (例えば、無関係な 2 つのデータ項目がたまたま同じメモリページ上にある場合、1 つ目の項目のみが更新されているにもかかわらず 2 つ目の項目も重複して複製される) により、通常さらに多くのメモリを使用する。スナップショット作成中にメモリ容量が枯渇するという不幸な事態が発生した場合、サーバはスナップショットが完了するまで新しいログエントリの受け入れを停止する必要がある。これは一時的にそのサーバの可用性を犠牲にするかもしれないが (クラスタは引き続き利用可能かもしれない)、少なくともサーバが回復することを可能にする。スナップショットを中止して後で再試行することは、次回の試行でも同じ問題が発生する可能性があるため避けるべきである。(LogCabin ではディスクへのストリーミングインターフェースを使用するが、現時点ではメモリ枯渇を適切に処理できない。)

5.1.2 スナップショットのタイミング

5.1.2 スナップショットのタイミング

サーバはいつスナップショットを作成するかを決定しなければならない。サーバが頻繁にスナップショットを作成しすぎると、ディスク帯域幅やその他のリソースが無駄になる。一方でスナップショットの頻度が低すぎると、ストレージ容量を枯渇させるリスクがあり、再起動時のログのリプレイに必要な時間が増加する。

一つの単純な戦略は、ログがバイト単位で固定サイズに達したときにスナップショットを作成することである。このサイズがスナップショットの予想サイズよりも大幅に大きく設定されていれば、スナップショット取得に伴うディスク帯域幅のオーバーヘッドは小さくなるだろう。しかし、これにより小さなステートマシンではログが不必要に大きくなる可能性がある。

よりよいアプローチはスナップショットのサイズとログのサイズを比較することである。スナップショットがログよりも何倍も小さい場合、スナップショットを作成する価値があるだろう。しかし、スナップショットを作成する前にそのサイズを計算することは困難で負担が大きく、ステートマシンにかなりの記録管理の負荷を課したり、サイズを動的に算出するために実際にスナップショットを作成するのとほぼ同じ量の作業を必要としたりする可能性がある。スナップショットファイルを圧縮することもスペースと帯域幅の節約につながるが、圧縮後の出力サイズを予測することは難しい。

幸いなことに、次のスナップショットのサイズではなく以前のスナップショットのサイズを使用することで妥当な振る舞いが得られる。サーバは、以前のスナップショットのサイズに設定可能な拡張係数 (extension factor) を乗じた値をログのサイズが超えたときにスナップショットを作成する。拡張係数はディスク帯域幅とスペース利用率のトレードオフを行う。例えば拡張係数が 4 の場合、ディスク帯域幅の約 20% がスナップショットの作成に費やされ (スナップショット 1 バイトごとに 4 バイトのログエントリが書き込まれる)、1 つの状態コピー (古いスナップショット、その 4 倍の大きさのログ、そして書き込まれる新しいスナップショット) を保存するのに必要なディスク容量の約 6 倍のディスク容量が必要となる。

スナップショットの作成は依然として CPU およびディスク帯域幅のバーストを発生させ、クライアントの性能に影響を与える可能性がある。これはハードウェアを追加することで緩和できる。例えば 2 台目のディスクドライブを使用して追加のディスク帯域幅を提供できる。

また、スナップショット作成中のサーバでクライアントリクエストが待機することがないように、スナップショットをスケジューリングすることも可能かもしれない。このアプローチでは、サーバがクラスタ内で調整して、少数派のサーバだけが一度にスナップショットを作成する (可能であれば)。Raft ではログエントリをコミットするために過半数のサーバのみを必要とするため、少数派のサーバがスナップショットを作成しても通常はクライアントに悪影響を与えないだろう。リーダーがスナップショットを作成したい場合、まずそのサーバが退任し、その間は別のサーバにクラスタを管理させる。このアプローチが十分に信頼できるものであれば、スナップショットを並行して作成する必要性も排除できるだろう。つまり、サーバはスナップショットを取得している間、単に利用不能になるだけで良い (ただしこれはクラスタの故障を隠蔽する能力に影響する)。これはシステム全体の性能を向上させ、メカニズムを削減する可能性があるため、今後の研究にとって非常に興味深い機会である。

5.1.3 実装上の考慮事項

5.1.3 実装上の考慮事項

このセクションでは、スナップショットの実装に必要とされる主要なコンポーネントを概観し、それらの実装上の困難について議論する:

スナップショットの保存と読み込み: スナップショットの保存は、ステートマシンの状態を直列化し、そのデータをファイルに書き出す処理である。読み込みはその逆のプロセスである。様々な種類のデータオブジェクトをネイティブ表現から直列化するのはやや面倒であったが、我々はこれが比較的単純な作業であることに気づいた。ステートマシンからディスク上のファイルへのストリーミングインターフェースは、ステートマシンの状態全体をメモリにバッファリングするのを避けるのに役立つ。また、ストリームを圧縮してチェックサムを適用することも効果的かもしれない。LogCabin は、各スナップショットをまず一時ファイルに書き込み、書き込みが完了しディスクにフラッシュされた後にファイル名を変更する。これにより、サーバ起動時に部分的に書き込まれたスナップショットをロードすることがないことを保証する。

スナップショットの転送: スナップショットの転送には InstallSnapshot RPC のリーダー側とフォロワー側の実装が必要である。これは比較的単純であり、スナップショットのディスクへの書き込みと読み込みのコードと一部共有できる可能性がある。この転送の性能は通常それほど重要ではない (この状態を必要とするフォロワーはエントリのコミットに参加していないため、すぐに必要とされる可能性は低い; 一方で、クラスタが追加のの障害に見舞われた場合、可用性を回復するためにフォロワーを追いつかせる必要があるかもしれない)。

安全でないログアクセスとログエントリ破棄の排除: 我々は当初、ログ圧縮を考慮せずに LogCabin を設計したため、エントリ \(i\) がログに存在する場合、エントリ 1 から \(i-1\) も存在すると仮定していた。しかしログ圧縮ではこれはもはや真ではない。例えば AppendEntries RPC で前のエントリのタームを決定する際に、そのエントリが破棄されている可能性がある。コード全体からこの仮定を排除するには慎重な推論とテストが必要であった。より強力な型システムであれば、コンパイラがログへのすべてのアクセスにおいてインデックスが範囲外の場合も処理するように強制できれば、これはより容易になったであろう。すべてのログアクセスを安全にしてからは、ログのプレフィクスを破棄することは簡単になった。これまでは、スナップショットの保存、読み込み、転送を個別でしかテストできなかったが、ログエントリが安全に破棄できるようになったことで、これらすべてのシステム全体のテストを実行できるようになる。

コピーオンライトによるスナップショットの並行処理: スナップショットを並行して作成するには、ステートマシンの再設計やオペレーティングシステムの fork 操作の利用が必要になるかもしれない。LogCabin は現在 fork を使用しているが、これはスレッドや C++ のデストラクタと相性が悪く、これを正しく機能させるにはいくらかの困難があった。しかしコード量は少なく、ステートマシンのデータ構造を変更する必要性を完全に排除するため、我々はそれが正しいアプローチであったと考えている。

スナップショットのタイミングの決定: 開発中はすべてのログエントリを適用した後にスナップショットを作成することを推奨する。これはバグを迅速に発見するのに役立つだろう。実装が完了したら、スナップショットのタイミングに関するより有用なポリシーを追加すべきである (例えば Raft ログのサイズと最後のスナップショットのサイズに関する統計情報を使用するなど)。

我々は、スナップショットの段階的な開発とテストが困難であることを見出した。これらのコンポーネントのほとんどは、ログエントリを破棄できるようになる前に実装する必要があるが、その新しいコードパスの多くが実行されるのはシステム全体のテストより後になる。したがって、実装者はこれらのコンポーネントの実装とテストの順序を慎重に検討すべきである。

5.2 ディスクベースのステートマシンのスナップショット

5.2 ディスクベースのステートマシンのスナップショット

このセクションでは、ディスクを主要な記録場所として使用する大規模なステートマシン (数十~数百ギガバイト規模) のスナップショット作成方法について議論する。これらのステートマシンは、クラッシュに備えて常にディスク上に状態のコピーを保持するという点で他のステートマシンとは異なる挙動を示す。Raft ログの各エントリを適用すると、ディスク上の状態が変更され、実質的に新しいスナップショットが作成される。したがって、エントリが適用されると Raft ログから削除できる。(ステートマシンはディスク効率を向上させるために書き込みをメモリにバッファリングすることもできる; それらがディスクに書き込まれると対応するエントリは Raft ログから削除できる。)

ディスクベースのステートマシンの主な問題は、ディスク上の状態の変更がパフォーマンスの低下につながる可能性があることである。書き込みバッファリングがない場合、適用されるコマンドごとに 1 つ以上のランダムなディスク書き込みが必要となり、これがシステム全体の書き込みスループットを制限する可能性がある (そして書き込みバッファリングはあまり効果がないかもしれない)。セクション 5.3 では、大規模なシーケンシャル書き込みによってディスクへ効率的に書き込むログ圧縮の増分アプローチについて議論する。

ディスクベースのステートマシンは、遅いフォロワーにディスクの一貫したスナップショットを提供できる必要がある。ディスク上には常にスナップショットが存在するが、それを継続的に更新している。したがって、一貫性のあるスナップショットを十分な期間保持して転送するために、依然としてコピーオンライト技術が必要である。幸いなことに、ディスクフォーマットはほぼ常に論理ブロックに分割されているため、ステートマシンにコピーオンライトを実装するのは容易である。ディスクベースのステートマシンは、スナップショットのためにオペレーティングシステムのサポートに頼ることもできる。例えば Linux の LVM (論理ボリューム管理) はディスクパーティション全体のスナップショットを作成するために使用できる [70]。また、最近のファイルシステムの中には個々のディレクトリのスナップショットを作成できるものもある [19]。

ディスクイメージのスナップショットのコピーには長い時間がかかり、ディスクへの変更が蓄積されるにつれてスナップショットを維持するために必要な追加のディスク使用量も増加する。我々はディスクベースのスナップショットは実装していないが、ディスクベースのステートマシンでは以下のアルゴリズムでディスクの内容を転送することで、こうしたオーバーヘッドの大部分を回避できると推測している:

各ディスクブロックについて、最終更新時刻を追跡する。

通常の操作を継続しながら、ディスクの内容全体をブロックごとフォロワーに転送する。この処理中、リーダー側では余分なディスク領域は使用されない。ブロックは並行して変更されているため、フォロワー上では不整合なディスクイメージになる可能性がある。リーダーから各ブロックが転送される際、その最終更新時刻を記録する。

ディスクの内容のコピーオンライトスナップショットを作成する。このスナップショットが作成されると、リーダーはディスクの内容の一貫したコピーを保持するが、クライアントによる継続的な操作によってディスクへの変更が発生するにつれ追加のディスク領域が使用される。

ステップ 2 で最初に送信されてからステップ 3 でスナップショットが作成されるまでの間に変更されたディスクブロックのみを再送する。

うまくゆけば、一貫したスナップショットのブロックのほとんどはステップ 3 でスナップショットが作成されるまでに既に転送されているだろう。もしそうならステップ 4 での転送は迅速に進行する。ステップ 4 でリーダーノード上にスナップショットを保持するために追加されるディスク容量は少なく、変更されたブロックを再送するためにステップ 4 で使用される追加のネットワーク帯域幅も少ないだろう。

5.3 増分クリーニングのアプローチ

5.3 増分クリーニングのアプローチ

ログクリーニング [97, 98] やログ構造マージツリー [84, 17] (LSM tree) といった圧縮に対する増分アプローチも可能である。これらはスナップショットよりも複雑だが、増分アプローチにはいくつかの望ましい特徴がある:

これらのアプローチは一度にデータの一部のみを処理するため、圧縮の負荷が時間の経過と共に均等に分散される。

これらは通常動作時と圧縮中の両方でディスクへの書き込みを効率的に行う。いずれの場合も大規模なシーケンシャル書き込みが行われる。増分アプローチはまた、最も再利用しやすい領域を持つディスクの一部を選択的に圧縮するため、(スナップショットごとにディスク全体を書き換える) メモリベースのステートマシンのスナップショットよりもディスクへの書き込みデータ量が少ない。

増分アプローチはディスク領域をその場で変更しないため、一貫性のある状態スナップショットを比較的容易に転送できる。

セクション 5.3.1 とセクション 5.3.2 では、まずログクリーニングと LSM ツリーの一般的な基礎について説明する。その後、セクション 5.3.3 でこれらを Raft に適用する方法について説明する。

5.3.1 ログクリーニングの基礎

5.3.1 ログクリーニングの基礎

ログクリーニングはログ構造化ファイルシステム [97] の文脈で導入され、最近では RAMCloud [98] などのインメモリストレージシステムにも提案されている。原則として、ログクリーニングはあらゆる種類のデータ構造に使用できるが、効率的に実装するのが他の構造より難しいものもある。

ログクリーニングはログをシステムの状態を記録する場所として維持する。レイアウトはシーケンシャル書き込みに最適化されており、読み取り操作は実質的にランダムアクセスとなる。したがって、データを読み取るためにインデックス構造が必要となる。

ログクリーニングでは、ログはセグメントと呼ばれる連続した領域に分割される。ログクリーナーの各パスは 3 段階のアルゴリズムを使用してログを圧縮する。

まず、不要となったエントリが大量に蓄積されているセグメントをクリーニング対象として選択する。

次に、それらのセグメントからライブエントリ (現在のシステム状態に影響を与えるエントリ) をログの先頭にコピーする。

最後に、セグメント用のストレージスペースを解放し、そのスペースを新しいセグメントに利用できるようにする。

通常の操作への影響を最小限に抑えるため、このプロセスは並行実行できる [89]。

ライブエントリをログの先頭にコピーした結果、エントリはリプレイ時に順序がずれることになる。ログを適用する際に正しい順序を再構築するために、エントリには追加情報 (バージョン番号など) を含む場合がある。

どのセグメントをクリーニング対象として選択するかというポリシーは性能に大きな影響を与える。先行研究では、ライブエントリによって使用されるスペースの量だけではなく、それらのエントリがどれくらいの期間ライブ状態のままかという要素も考慮した費用対効果の高いポリシーが提案されている [97, 98]。

エントリがライブであるかを判断するのはステートマシンの責任である。例えばキーバリューストアでは、キーを特定の値に設定するログエントリは、そのキーが存在し、現在その値に設定されている場合にライブである。キーを削除するログエントリがライブであるかを判断するのはより微妙である。そのキーを設定する以前のエントリがログに存在し続ける限り有効である。RAMCloud は必要に応じて (墓石 (tombstone) と呼ばれる) 削除コマンドを保存するが [98]、別の方法として、現在の状態にあるキーの要約を定期的に書き出し、その後、リストにはないキーに関するすべてのログエントリはライブでないと見なす方法がある。キーバリューストアはかなり単純な例である。他のステートマシンも可能ではあるが、残念ながらライブ状態の判断はそれぞれ異なる。

5.3.2 ログ構造マージツリーの基礎

5.3.2 ログ構造マージツリーの基礎

ログ構造マージツリー (LSM ツリー) は O'Neil [84] によって初めて記述され、後に BigTable [17] によって分散システムで普及した。これらは Apache Cassandra [1] や HyperDex [27] などのシステムで使用されており、LevelDB [62] やそのフォーク (RocksDB [96] や HyperLevelDB [39]) のようなライブラリとしても利用可能である。

LSM ツリーは、順序付けられたキーと値のペアを格納するツリー状のデータ構造である。大まかに言えばこれらはログクリーニングのアプローチと同様にディスクを使用する。すなわち、大きなシーケンシャルストライドで書き込みを行い、ディスク上のデータをインプレースで変更しない。ただし、LSM ツリーはすべての状態をログに保存する代わりに、状態を再編成することでランダムアクセスを向上させる。

典型的な LSM ツリーは、最近書き込まれたキーをディスク上の小さなログに保存する。ログが一定サイズに達すると、キーでソートされ、ソートされた順序でラン (run) と呼ばれるファイルに書き込まれる。ランはインプレースで変更されることはないが、圧縮プロセスが定期的に複数のランをマージし、新しいランを生成して古いものを破棄する。このマージはマージソートを想起させる。キーが複数の入力ランに依存する場合、最新バージョンのみが保持されるため、生成されるランはよりコンパクトになる。LevelDB で使用される圧縮戦略は Figure 5.1 にまとめられている。これは効率性を高めるためにランを世代別に分離する (ログクリーニングに似ている)。

通常の操作中、ステートマシンはこのデータを直接操作できる。キーを読み取るには、まずそのキーがログ内で最近変更されたかを確認し、次に各ランをチェックする。検索のたびにすべてのランでキーをチェックするのを避けるために、一部のシステムでは各ランに対してブルームフィルタを作成する (これは、特定のケースでキーがランに存在しないことを確実に判断できるコンパクトなデータ構造だが、キーが存在しない場合でもランを検索する必要がある場合がある)。

5.3.3 Raft におけるログクリーニングとログ構造マージツリー

5.3.3 Raft におけるログクリーニングとログ構造マージツリー

我々は Raft においてログクリーニングや LSM ツリーを実装しようとはしなかったが、どちらも上手く機能するのではないかと推測している。LSM ツリーを Raft に適用するのは比較的簡単である。Raft ログは既に最近のエントリをディスクに永続的に保存しているため、LSM ツリーは最近のデータをより便利なツリー形式でメモリ上に保持できる。これは検索処理を高速化し、Raft のログが一定サイズに達した時点でツリーは既にソートされた順序でディスクに新しいランとして書き込まれる準備が整っているだろう。リーダーから遅いフォロワーに状態を転送するには、すべてのランをフォロワーに転送する必要がある (ただしインメモリのツリーは送信しない)。幸いにもランは不変であるため、転送中にランが変更される心配はない。

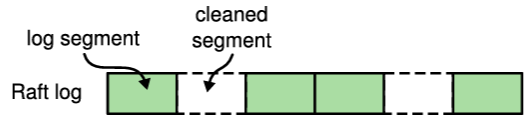

ログクリーニングを Raft に適用するのはそれほど簡単ではない。我々はまず Raft ログをセグメントに分割してクリーニングするアプローチを検討した (Figure 5.4(a) 参照)。残念ながら、クリーニングを行うとセグメントが解放されたログに多くの穴を開けることになり、ログレプリケーションのアプローチを修正する必要がある。このアプローチは機能させることができると考えるが、Raft とステートマシンとの相互作用に大きな複雑性を加えることになる。さらに、Raft ログに追記できるのはリーダーのみであるため、クリーニングはリーダーベースである必要があり、リーダーのネットワーク帯域幅を消費することになるだろう (これについてはセクション 5.4 で詳しく説明する)。

よりよいアプローチはログクリーニングを LSM ツリーと同様に扱うことである。Raft は最近の変更に対して連続したログを保持し、ステートマシンは自身の状態をログとして保持するが、これらのログは論理的に区別されるだろう (Figure 5.4 参照)。Raft ログが一定サイズに達すると、新しいエントリはステートマシンのログに新しいセグメントとして書き込まれ、対応する Raft ログのプレフィクスは破棄される。ステートマシン内のセグメントは各サーバで独立してクリーニングされるため、Raft ログはこれによる影響を受けないだろう。ログクリーニングの複雑性はステートマシン内に完全にカプセル化されており (ステートマシンと Raft 間のインターフェースはシンプルなまま)、サーバは独立してクリーニングできるため、Raft ログを直接クリーニングするよりもこのアプローチを推奨する。

前述のように、このアプローチではステートマシンが Raft のすべてのログエントリを独自のログに書き込む必要がある (ただし大規模なバッチ処理も可能である)。この追加のコピーは、ログエントリからなるファイルを Raft のログから直接移動し、そのファイルをステートマシンのデータ構造に組み込むとで最適化できるかもしれない。これは性能が重視されるシステムにおいて有用な最適化となる可能性があるが、残念ながら、ステートマシンが Raft ログのディスク上の表現を理解する必要があるため、ステートマシンと Raft モジュールの結合度がより高くなるだろう。

5.4 代替案: リーダーベースのアプローチ

5.4 代替案: リーダーベースのアプローチ

本章で提示したログ圧縮アプローチはサーバがリーダーの知識なしに自身のログを圧縮するため、Raft の強力なリーダー原則から逸脱している。しかし我々はこの逸脱は正当化されると考える。リーダーの存在はコンセンサスに達する際の矛盾する決定を避けるのに役立つが、スナップショット作成時には既にコンセンサスが達成されているため矛盾した決定は発生しない。データは依然としてリーダーからフォロワーにのみ流れるが、フォロワーは独自にデータを再編成できるようになる。

我々はリーダーベースのログ圧縮アプローチも検討したが、通常は性能上の考慮事項の方がその利点を上回っている。リーダーがログを圧縮し、その結果をフォロワーに送信することは無駄が多く、フォロワーがそれぞれ独立してログを圧縮する方が効率的である。各フォロワーに冗長な状態を送信すると、ネットワーク帯域幅が浪費され、圧縮プロセスが遅くなる。各フォロワーは既に自身の状態を圧縮するために必要な情報を持っており、リーダーの送信ネットワーク帯域幅は通常、Raft の最も貴重な (ボトルネックとなる) リソースである。メモリベースのスナップショットの場合、サーバがローカル状態からスナップショットを作成する方が、ネットワーク経由でスナップショットを送受信するよりもはるかに安価である。増分圧縮アプローチの場合、これはハードウェア構成に依存するが、我々は独立した圧縮の方が安価であると予想する。

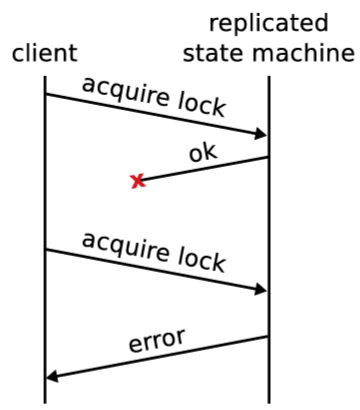

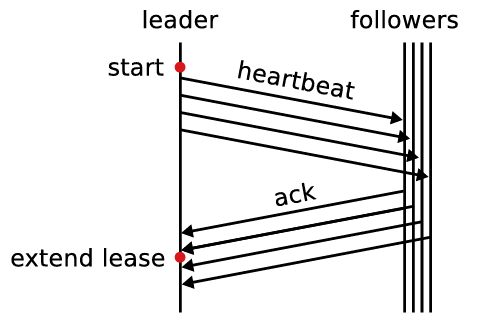

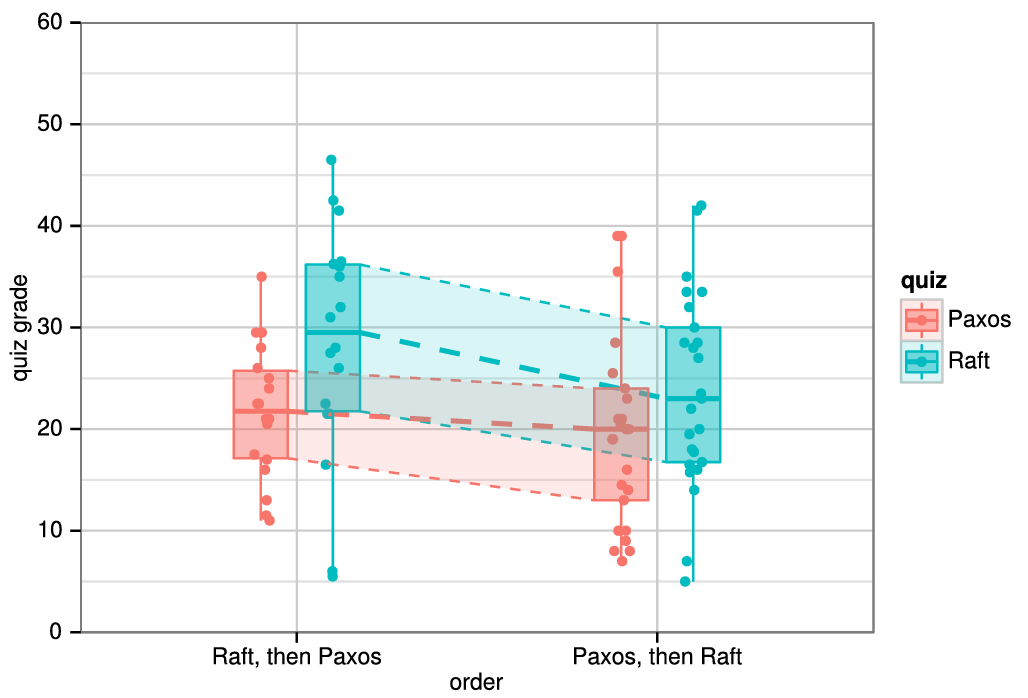

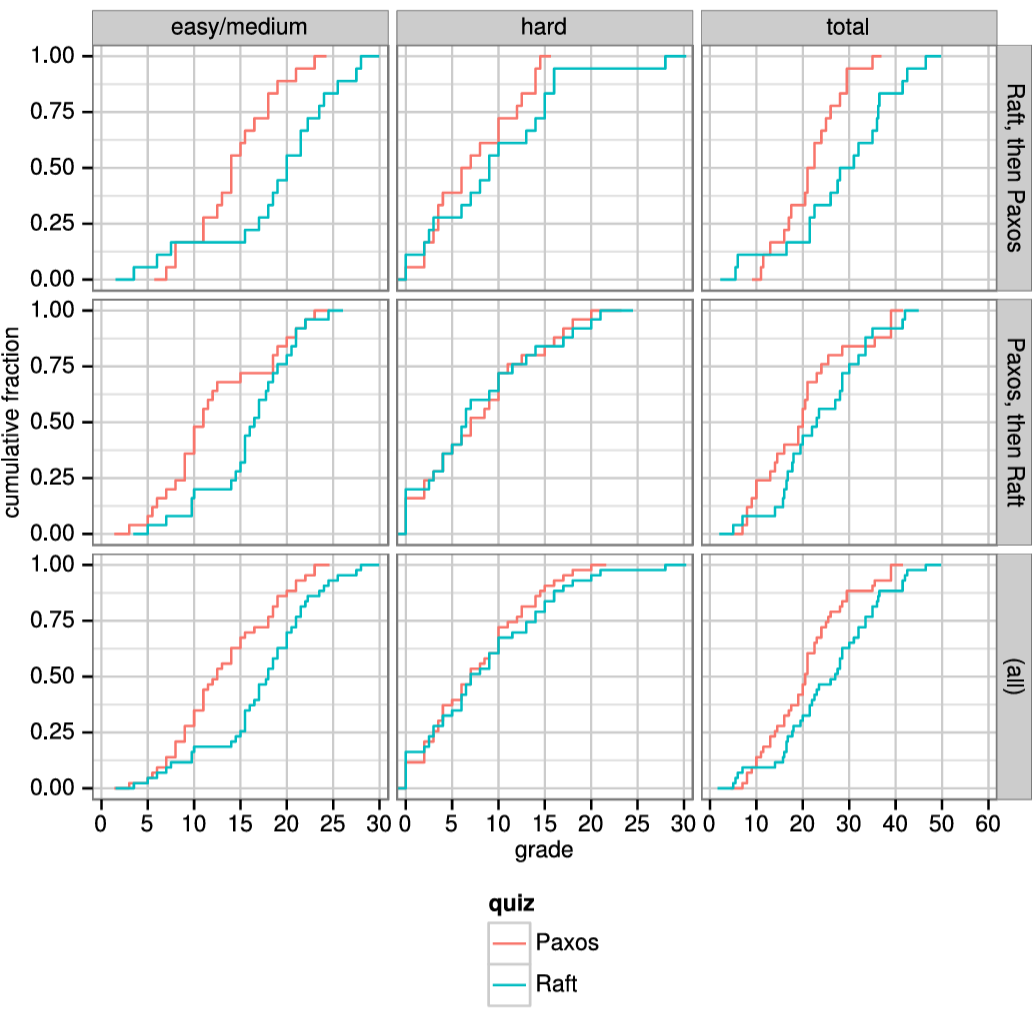

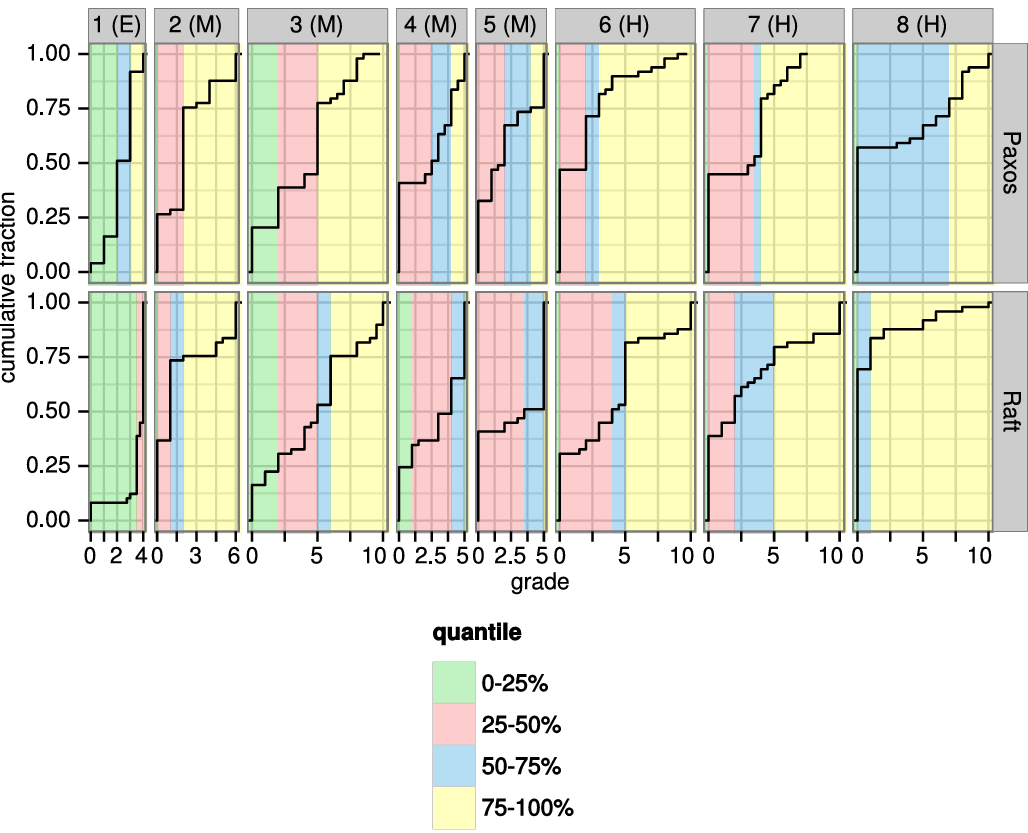

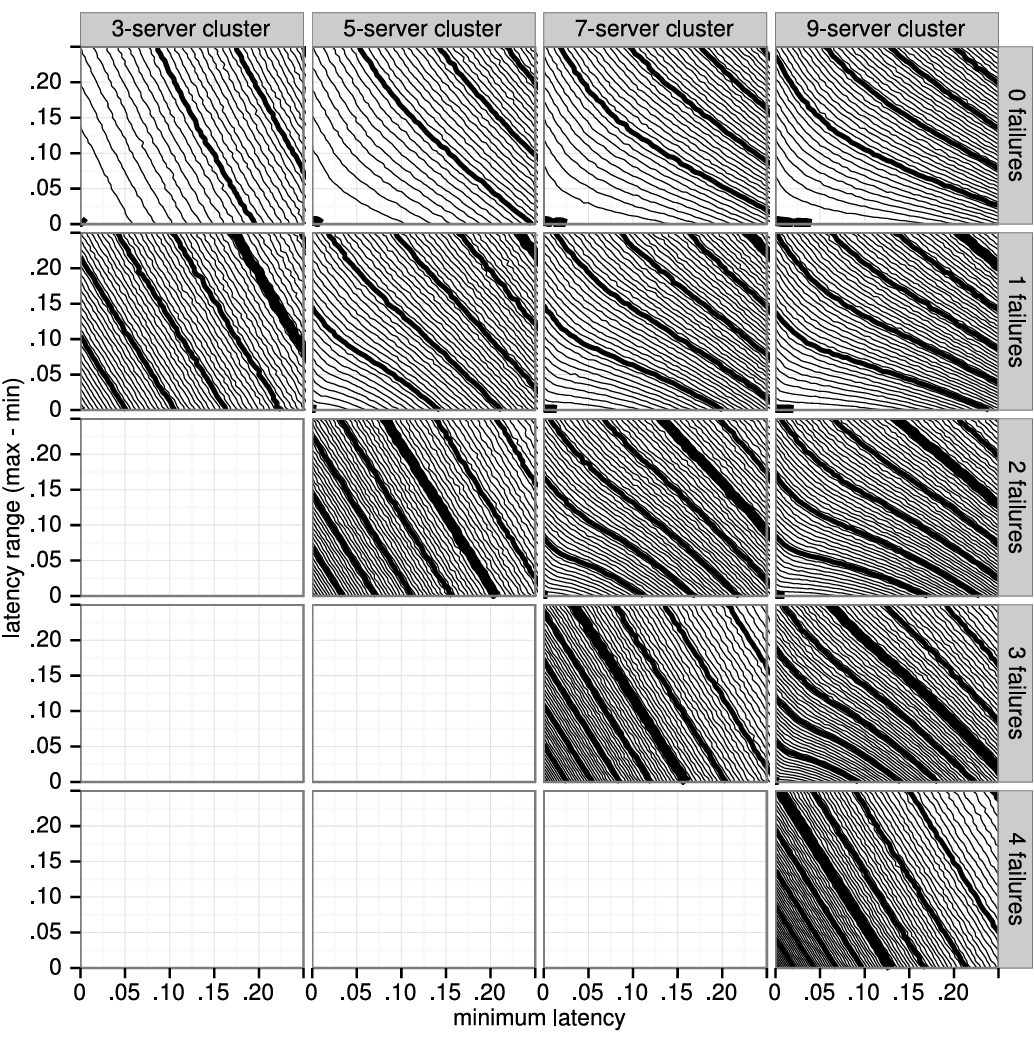

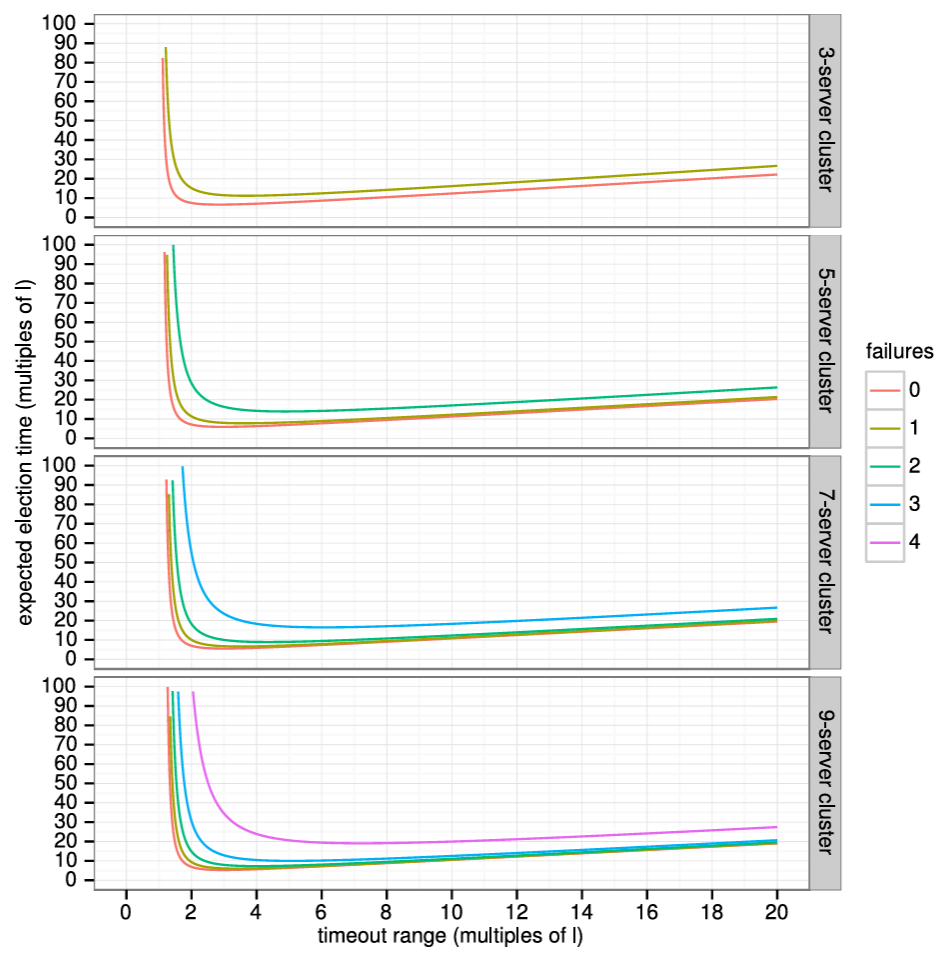

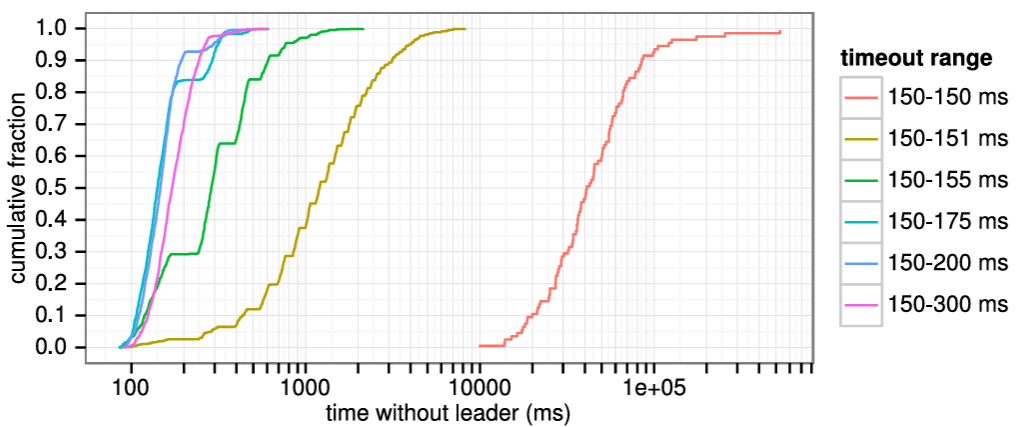

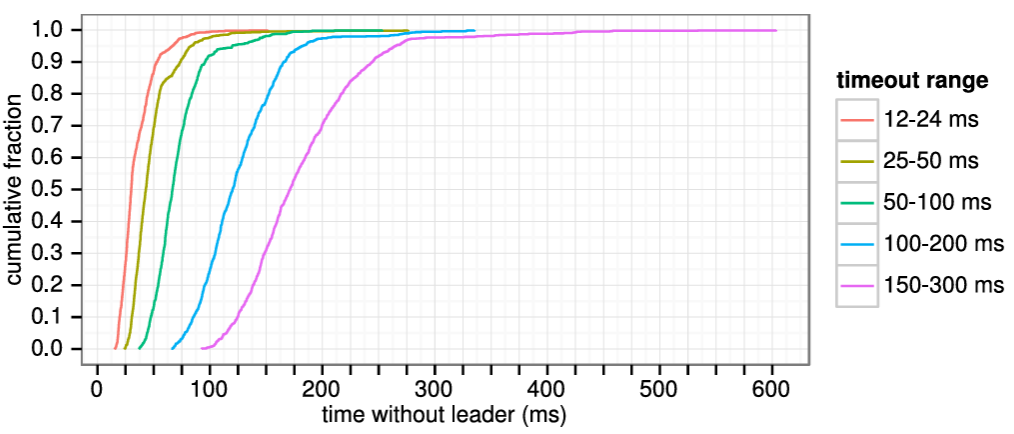

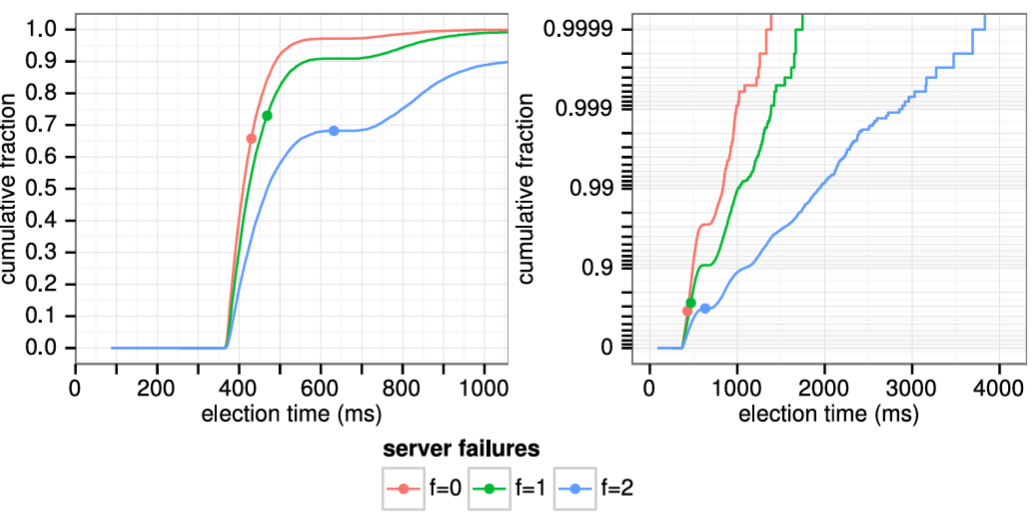

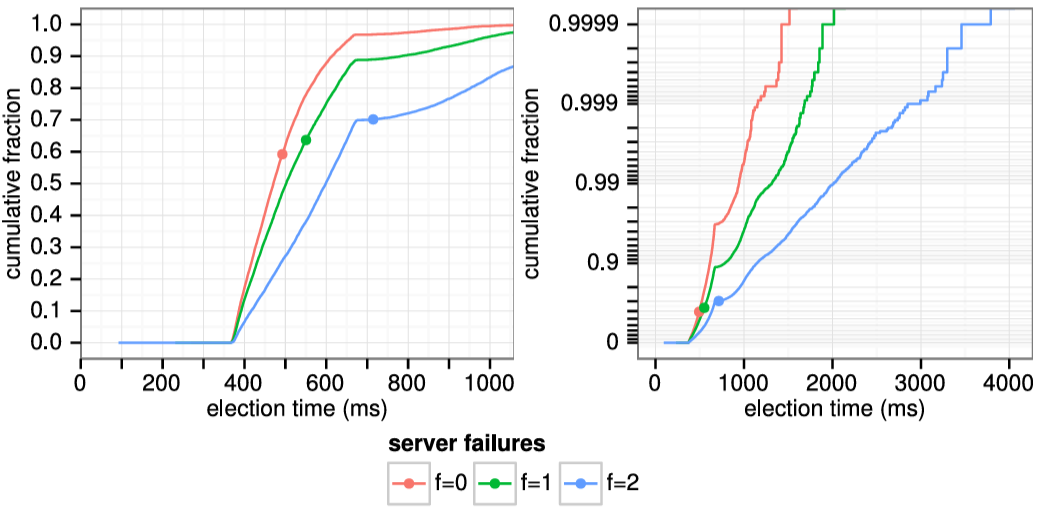

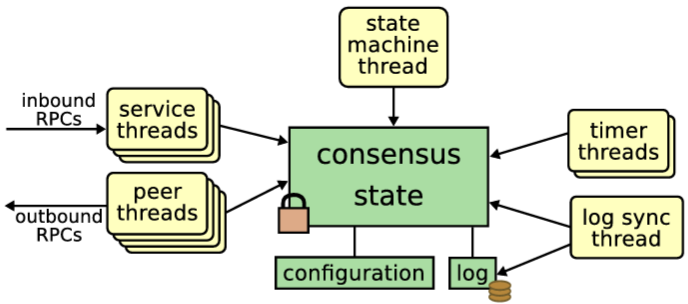

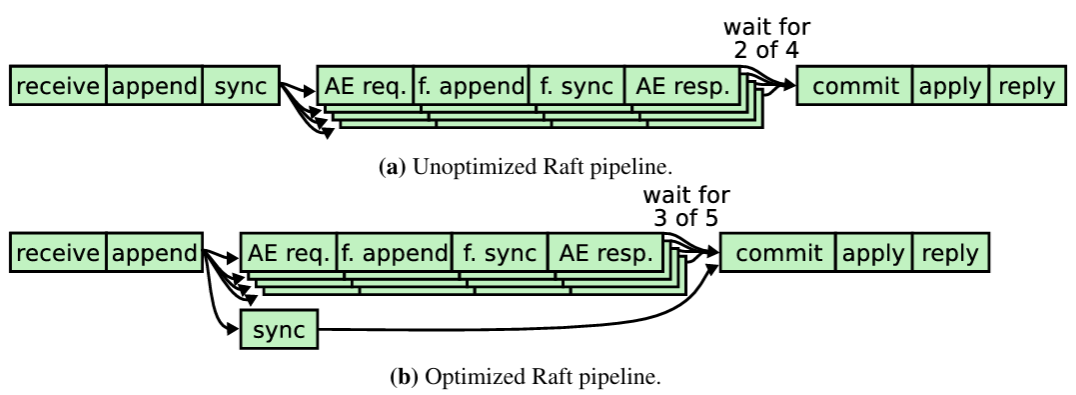

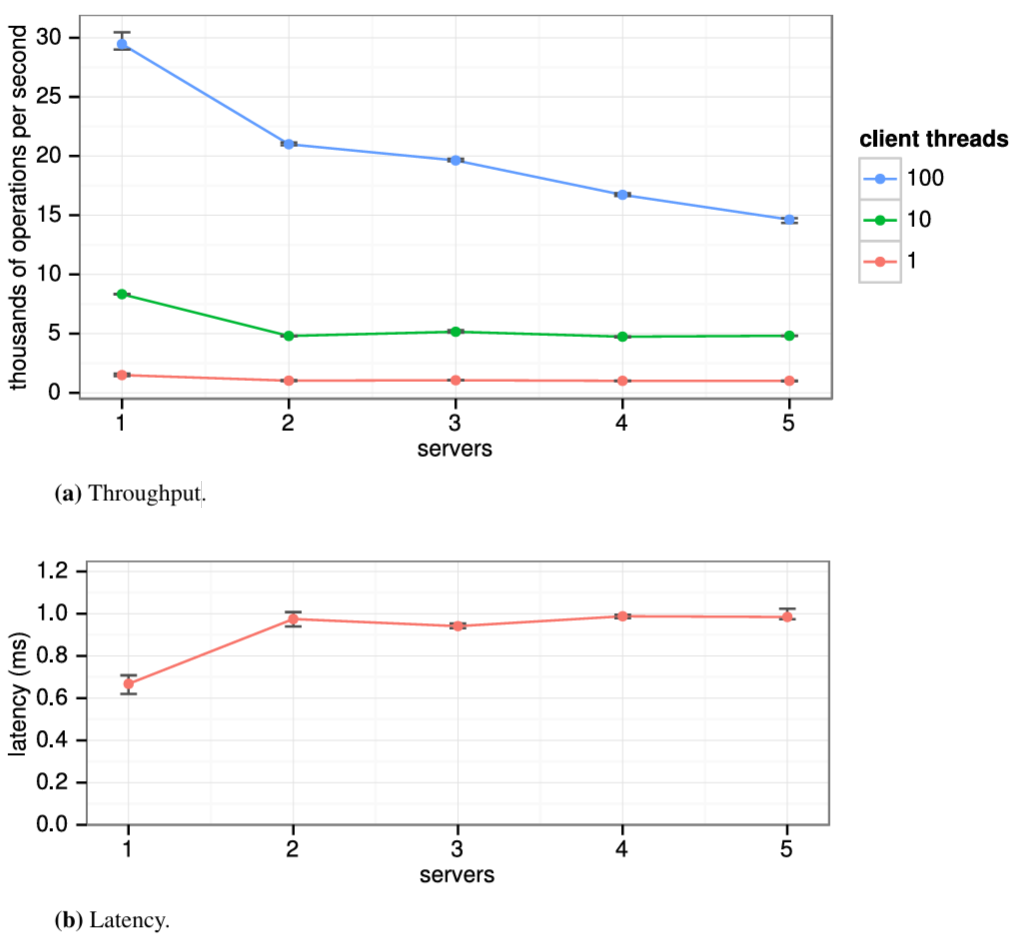

5.4.1 スナップショットのログへの保存