エントロピー

概要

概要

エントロピー (entropy) は、情報理論において情報源から得られる平均的な情報量を表す概念である。1948 年にクロード・シャノンによって導入され、情報理論のきをを那須最も重要な概念の一つとされている。データ圧縮や暗号学などの符号理論、機械学習、自然言語処理などで応用されている。

Table of Contents

定義

定義

離散確率変数 \(X\) が値 \(x_1\), \(x_2\), …, \(x_n\) を確率 \(p_1\), \(p_2\), …, \(p_n\) でとるとき、\(X\) のエントロピー \(H(X)\) は式 (\(\ref{entropy}\)) で定義される。\[ \begin{equation} H(X) = - \sum_{i=1}^n p_i \log_2 p_i \label{entropy} \end{equation} \] ここで \(\log\) の底は通常 2 が用いられ、この場合エントロピーの単位はビット (bit) となる。自然対数を用いる場合をナット (nat)、常用対数を用いる場合をディット (dit) と呼ぶ。

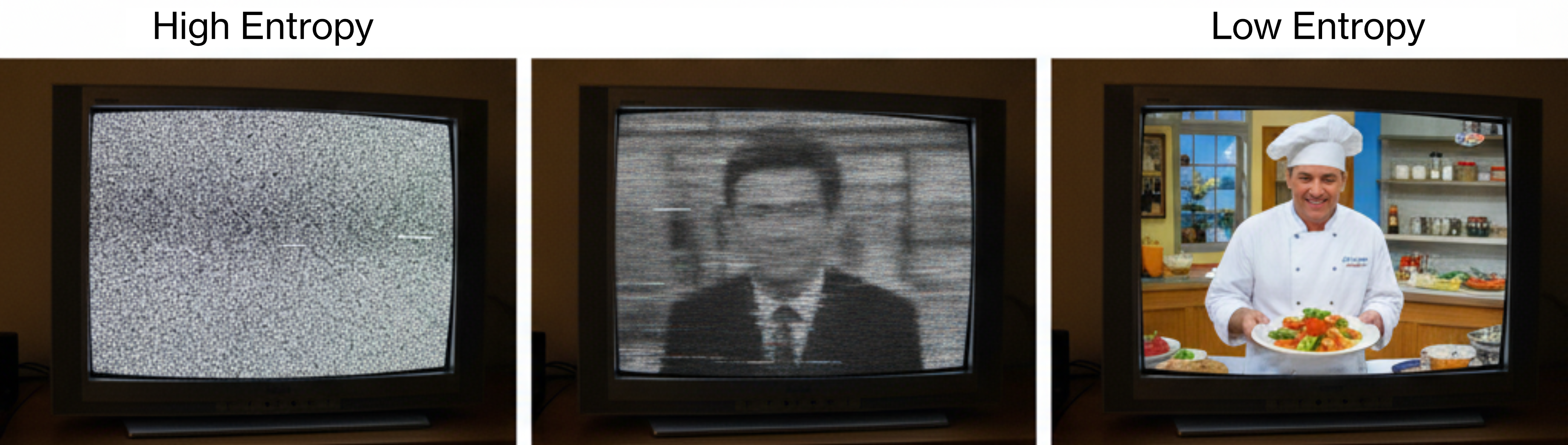

エントロピーは情報源の「予測不可能性」や「ランダム性」の度合いを定量化する。エントリピーが高いほど乱雑であり、その情報源から得られる情報は予測困難となる。逆にエントロピーが低い情報源は予測可能性が高い。

例えば、常に同じ結果を出力する \(p_1=1\), \(p_2=\ldots=p_n=0\) のような完全に決定的な情報源のエントロピーは \(H(X)=0\) であり、\(p_1=p_2=0.5\) の公正なコイントスのエントロピーは \(H(X)=1\) ビットとなる。

性質

性質

エントロピーは以下の性質を持つ:

非負性: \(H(X) \ge 0\) (統合は \(X\) が定数の時のみ成立)

最大性: 離散確率変数の場合、一様分布の時エントロピーが最大となる。

加法性: 独立名確率変数 \(X\), \(Y\) に対して、\(H(X,Y) = H(X) + H(Y)\)

対称性: 確率の順序に依存しない

連続性: 確率の小さな変化に対してエントロピーは連続的に変化する。

条件付きエントロピー

条件付きエントロピー

確率変数 \(Y\) が与えられたときの \(X\) の条件付きエントロピーは式 (\(\ref{cond_entropy}\)) で表される。\[ \begin{equation} H(X\mid Y) = - \sum_j p(y_i) \sum_i p(x_i \mid y_j) \log_2 p(x_i \mid y_j) \label{cond_entropy} \end{equation} \] これは \(Y\) を知っている状態で \(X\) について残る不確実性を表す。

結合エントロピー

結合エントロピー

2 つの確率変数 \(X\), \(Y\) の結合エントロピーは式 (\(\ref{joint_entropy}\)) で表される。\[ \begin{equation} H(X,Y) = - \sum_{i,j} p(x_i, y_j) \log_2 p(x_i, y_j) \label{joint_entropy} \end{equation} \]

相互情報量との関係

相互情報量との関係

エントリピーは相互情報量 \(I(X;Y)\) と密接に関連しており、式 (\(\ref{i}\)) に示す関係がある。\[ \begin{equation} I(X;Y) = H(X) - H(X \mid Y) = H(Y) - H(Y \mid X) \label{i} \end{equation} \] 相互情報量は2つの確率変数間で共有される情報量を表す。

二値エントロピー

二値エントロピー

二値エントロピー (binary entropy) は 2 つの値のみをとる確率変数のエントロピーであり、情報理論における基本的な概念の一つである。確率変数 \(X\) が確率 \(p\) で値 1、確率 \(1-p\) で値 0 をとるとき、\(X\) の二値エントロピー \(H_2(p)\) は式 (\(\ref{bin_entropy}\)) のように示される。\[ \begin{equation} H(p) = -p \log_2 p - (1 - p) \log_2 (1 - p) \label{bin_entropy} \end{equation} \] ここで \(0 \le p \le 1\) であり、極限として \(0 \log_2 0 = 0\) とする。

アンチエントロピー

アンチエントロピー

アンチエントロピー (anti-entropy) は、分散システムにおいてレプリカ感のデータの不一致 (高エントロピー) を減少させ、最終的にすべてのレプリカが同じ状態になる一貫性を達成するためのプロセスである。この概念は情報理論のエントロピーを分散システムの文脈に適用したものであり、システム内の「無秩序状態」を「秩序状態」に収束させるメカニズムを指す。